![]() 大规模预训练视觉模型(PVMs)已经显示出在各种下游视觉任务中的适应性强大潜力。然而,随着最先进的PVMs增长到数十亿甚至数万亿的参数,标准的完全微调范式因高计算和存储需求而变得不可持续。作为回应,研究人员正在探索参数高效微调(PEFT),它寻求以最小的参数修改超越完全微调的性能**。这篇综述提供了一个关于视觉PEFT的全面概览和未来方向,提供了最新进展的系统回顾**。首先,我们提供了PEFT的正式定义并讨论了模型预训练方法。然后,我们将现有方法分类为三类:基于添加的、基于部分的和基于统一的。最后,我们介绍了常用的数据集和应用,并提出了潜在的未来研究挑战。一个全面的资源集合可在 https://github.com/synbol/Awesome-Parameter-Efficient-Transfer-Learning 获取。

大规模预训练视觉模型(PVMs)已经显示出在各种下游视觉任务中的适应性强大潜力。然而,随着最先进的PVMs增长到数十亿甚至数万亿的参数,标准的完全微调范式因高计算和存储需求而变得不可持续。作为回应,研究人员正在探索参数高效微调(PEFT),它寻求以最小的参数修改超越完全微调的性能**。这篇综述提供了一个关于视觉PEFT的全面概览和未来方向,提供了最新进展的系统回顾**。首先,我们提供了PEFT的正式定义并讨论了模型预训练方法。然后,我们将现有方法分类为三类:基于添加的、基于部分的和基于统一的。最后,我们介绍了常用的数据集和应用,并提出了潜在的未来研究挑战。一个全面的资源集合可在 https://github.com/synbol/Awesome-Parameter-Efficient-Transfer-Learning 获取。

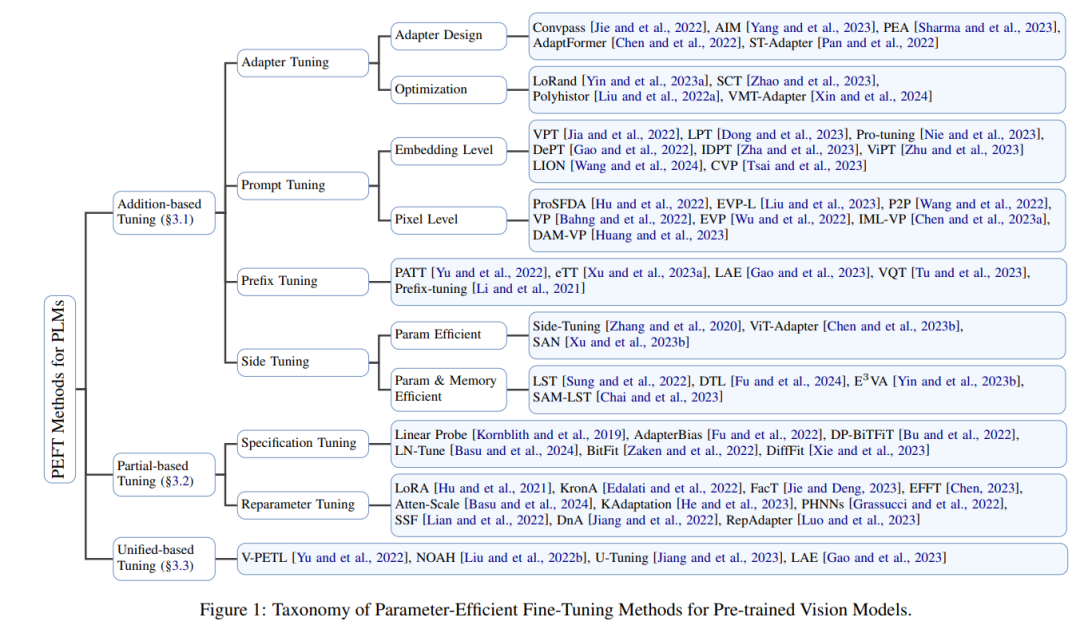

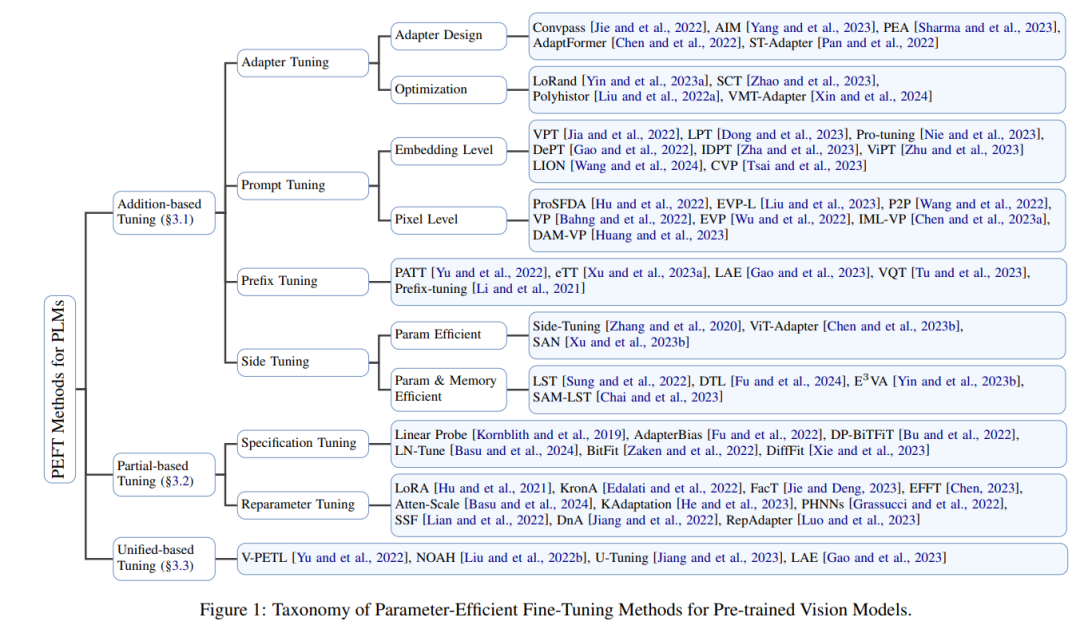

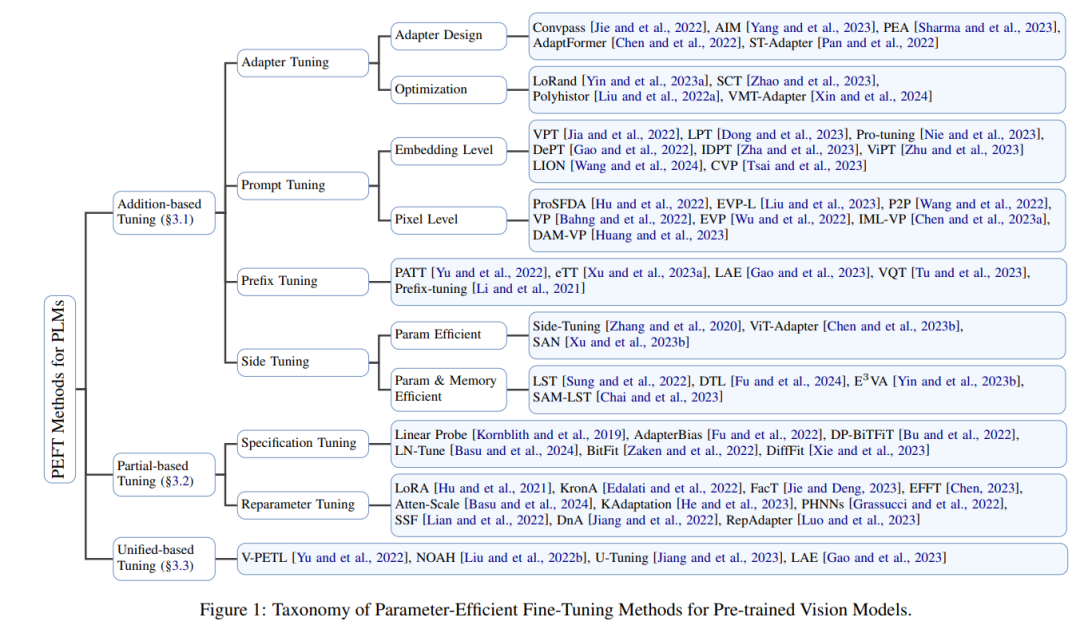

![]() 随着可用数据集[Deng 及其他人,2009]、模型架构[Dosovitskiy 及其他人,2021]和训练算法[He 及其他人,2022]的发展,大量的视觉基础模型得到了开发。特别是,基于Transformer的预训练视觉模型(PVMs)[Khan 及其他人,2022]在各种计算机视觉任务中展现了卓越的性能,例如图像分类[Dosovitskiy 及其他人,2021]和语义分割[Kirillov 及其他人,2023]。 由于PVMs的强大表示能力,微调PVMs以学习下游任务已成为一种流行的范式。然而,尽管传统的完全微调有效,但它需要大量的计算和存储资源。对于拥有数十亿甚至数万亿参数的模型来说,这种做法尤其昂贵。此外,还需要为每个数据集维护单独的模型权重,随着任务数量的增加,特别是在大型PVMs的情况下,这变得不切实际。 作为一种有前景的解决方案,最初在NLP中提出的参数高效微调(PEFT)通过更新最少数量的参数来克服上述挑战,同时可能实现与完全微调相当或更优的性能[Hu 及其他人,2021; Yu 及其他人,2022]。这些方法依赖于最近的进展,表明用丰富数据训练的大型预训练模型具有强大的泛化能力,PVMs中的大多数参数可以为新任务共享[Kornblith 及其他人,2019; Yu 及其他人,2022]。PEFT方法可以减少可学习的参数,这不仅促进了对新任务的更有效适应,而且还保护了PVMs内部的预存知识。考虑到PEFT的前景和大规模视觉模型的快速发展,迫切需要一项提供PEFT在视觉领域详细和最新调查的综述。 本文旨在提供一项关于视觉领域PEFT方法的全面和系统的研究,特别关注从2019年到2023年的基于Transformer的预训练模型。如图1所示,现有的视觉PEFT方法可以分为基于添加的调整、基于部分的调整和基于统一的调整。在第2部分,我们将定义PEFT的问题,介绍流行的主干网络,并讨论预训练方法。在第3部分,将提出PEFT方法的详细分类和深入分析。第4部分将介绍PEFT的实际应用。最后,在第5部分,我们将指出未来研究的挑战。

随着可用数据集[Deng 及其他人,2009]、模型架构[Dosovitskiy 及其他人,2021]和训练算法[He 及其他人,2022]的发展,大量的视觉基础模型得到了开发。特别是,基于Transformer的预训练视觉模型(PVMs)[Khan 及其他人,2022]在各种计算机视觉任务中展现了卓越的性能,例如图像分类[Dosovitskiy 及其他人,2021]和语义分割[Kirillov 及其他人,2023]。 由于PVMs的强大表示能力,微调PVMs以学习下游任务已成为一种流行的范式。然而,尽管传统的完全微调有效,但它需要大量的计算和存储资源。对于拥有数十亿甚至数万亿参数的模型来说,这种做法尤其昂贵。此外,还需要为每个数据集维护单独的模型权重,随着任务数量的增加,特别是在大型PVMs的情况下,这变得不切实际。 作为一种有前景的解决方案,最初在NLP中提出的参数高效微调(PEFT)通过更新最少数量的参数来克服上述挑战,同时可能实现与完全微调相当或更优的性能[Hu 及其他人,2021; Yu 及其他人,2022]。这些方法依赖于最近的进展,表明用丰富数据训练的大型预训练模型具有强大的泛化能力,PVMs中的大多数参数可以为新任务共享[Kornblith 及其他人,2019; Yu 及其他人,2022]。PEFT方法可以减少可学习的参数,这不仅促进了对新任务的更有效适应,而且还保护了PVMs内部的预存知识。考虑到PEFT的前景和大规模视觉模型的快速发展,迫切需要一项提供PEFT在视觉领域详细和最新调查的综述。 本文旨在提供一项关于视觉领域PEFT方法的全面和系统的研究,特别关注从2019年到2023年的基于Transformer的预训练模型。如图1所示,现有的视觉PEFT方法可以分为基于添加的调整、基于部分的调整和基于统一的调整。在第2部分,我们将定义PEFT的问题,介绍流行的主干网络,并讨论预训练方法。在第3部分,将提出PEFT方法的详细分类和深入分析。第4部分将介绍PEFT的实际应用。最后,在第5部分,我们将指出未来研究的挑战。

![]()