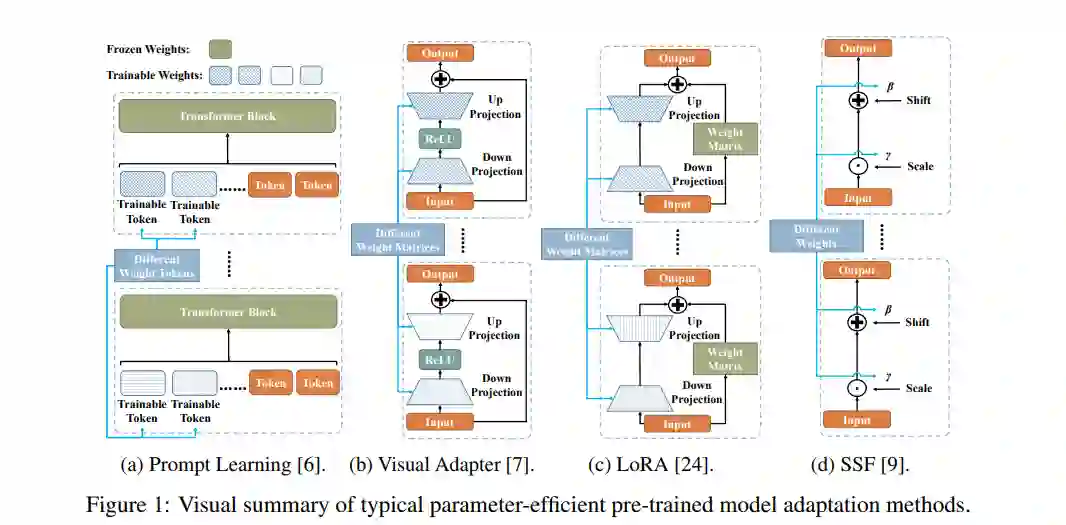

高容量预训练模型的出现已经彻底改变了计算机视觉中的问题解决方式,从训练特定任务的模型转变为调整预训练的模型。因此,有效地将大型预训练模型适应到下游任务中已经成为一个突出的研究领域。现有的解决方案主要集中在设计轻量级的适配器以及它们与预训练模型的交互上,目的是最小化需要更新的参数数量。在本研究中,我们提出了一种新颖的适配器重组 (ARC) 策略,从一个全新的角度解决有效地预训练模型的适应问题。我们的方法考虑了适应参数的可重用性,并引入了一个参数共享方案。具体来说,我们利用对称的下/上投影来构建瓶颈操作,这些操作在各个层之间共享。通过学习低维度的重新缩放系数,我们可以有效地重新组合层适应的适配器。这种在适配器设计中的参数共享策略允许我们在保持满意的性能的同时显著减少新参数的数量,从而为压缩适应成本提供了一个有前景的方法。我们使用各种视觉变压器变体,在24个下游的图像分类任务上进行了实验来评估我们的方法。结果表明,我们的方法在减少参数数量的同时,实现了引人注目的迁移学习性能。

我们的代码可在以下地址找到:https://github.com/DavidYanAnDe/ARC。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

225+阅读 · 2023年4月7日