【导读】BERT自问世以来,几乎刷新了各种NLP的任务榜,基于BERT的变种也层出不穷。19年来,很多研究人员都尝试融合视觉音频等模态信息进行构建预训练语言模型。本文介绍了EMNLP2019来自UNC-北卡罗来纳大学教堂山分校的Hao Tan的工作。构建LXMERT(从Transformers中学习跨模态编码器表示)框架来学习这些视觉和语言的语义联系。作者这份76页PPT详细介绍了语言和视觉任务的概况以及如何构建多模态BERT。

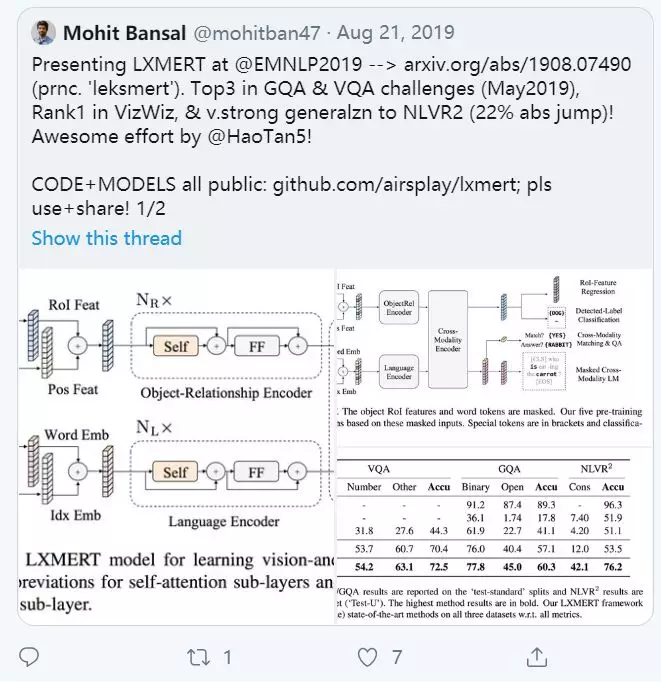

视觉和语言推理需要理解视觉概念、语言语义,最重要的是理解这两种模式之间的对齐和关系。因此,我们提出了LXMERT(从Transformers中学习跨模态编码器表示)框架来学习这些视觉和语言联系。在LXMERT中,我们构建了一个大型Transformers模型,它由三个编码器组成:一个对象关系编码器、一个语言编码器和一个跨模态编码器。接下来, 赋予我们的模型的功能连接视觉和语言的语义,我们在大量image-and-sentence 预训练模型, 通过五个不同代表训练的任务: mask语言建模,mask对象预测(功能回归和标签分类), 跨模式匹配和图像问答。这些任务有助于学习模态内和模态间的关系。从我们预先训练的参数进行微调后,我们的模型在两个可视化的问题回答数据集(即, VQA和GQA)。我们还通过将预训练的跨模态模型应用于具有挑战性的视觉推理任务NLVR2,并将之前的最佳结果提高了22%(54%至76%),从而展示了该模型的通用性。最后,我们展示了详细的ablation study,以证明我们的新模型组件和预训练策略对我们的结果有显著的贡献;并针对不同的编码器提出了几种注意可视化方法。代码和预训练的模型可在: https://github.com/airsplay/lxmert