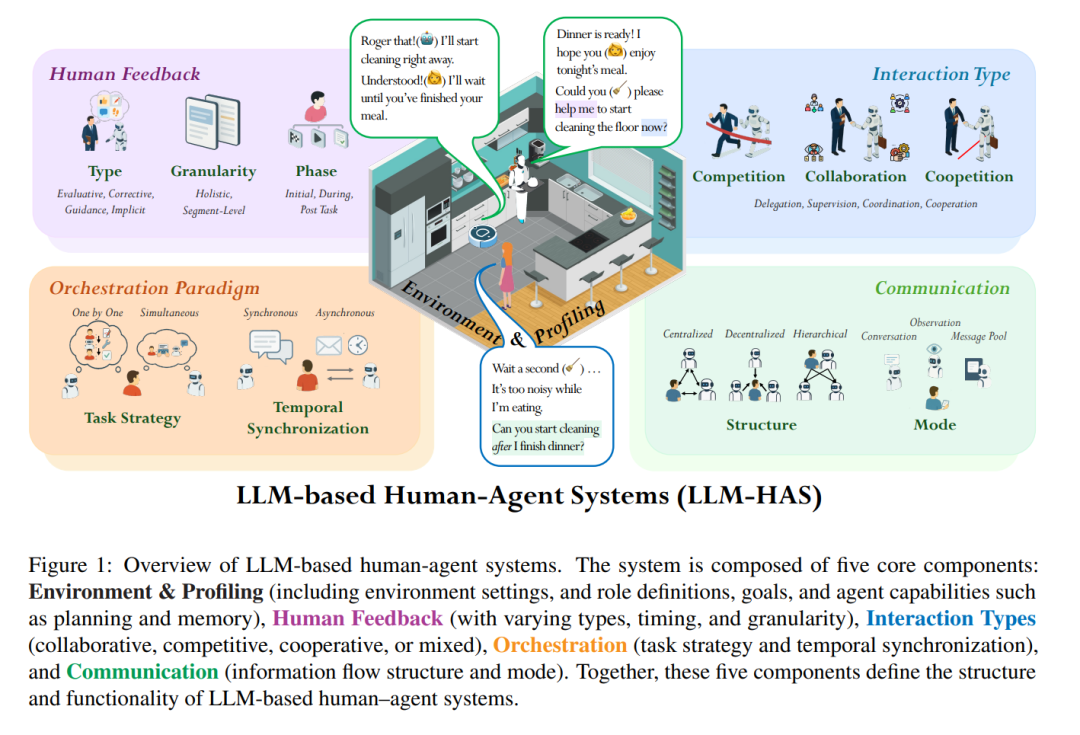

近年来,大型语言模型(LLMs)的进展激发了构建完全自主智能体的浓厚兴趣。然而,基于LLM的完全自主智能体仍面临诸多重大挑战,包括由于幻觉现象导致的可靠性不足、难以处理复杂任务,以及显著的安全性与伦理风险,这些问题限制了其在现实应用中的可行性和可信度。 为克服上述限制,基于LLM的人机系统(LLM-HAS)通过引入人类提供的信息、反馈或控制,增强了系统的性能、可靠性和安全性。本文首次对LLM-HAS进行了全面而系统的综述。我们澄清了该领域的基本概念,系统地介绍了构成此类系统的核心组件,包括环境与用户画像、人类反馈、交互类型、系统编排与通信机制;同时探索了新兴应用,并讨论了该领域所面临的独特挑战与机遇。 通过整合当前知识并提供结构化的概览,我们旨在推动这一快速发展、跨学科领域的进一步研究与创新。相关论文列表与资源已在GitHub仓库中提供。

1 引言

近年来,大型语言模型(LLMs)的飞跃式发展,引发了对构建完全自主智能体的广泛关注——这类系统以LLM为核心引擎,具备感知环境、做出决策并执行动作以达成目标的能力(Wang 等,2024a;Li 等,2024a)。这些智能体通常集成了记忆、规划和工具使用等模块,旨在在最小化人为干预的前提下,实现复杂任务流程的自动化(Xi 等,2025)。 然而,追求完全自治仍面临关键障碍:(1)可靠性问题依然突出。由于LLM存在“幻觉”倾向,即生成貌似合理但实则错误或无意义的内容,这种不确定性会削弱用户信任,特别是在多步操作链中可能造成严重后果(Gosmar 和 Dahl,2025;Xu 等,2024)。(2)任务复杂性成为瓶颈。自主智能体在处理需要深层专业知识、长链条执行、复杂推理、动态适应,或对上下文连贯性要求极高的任务(如科学研究)时,往往力不从心(Feng 等,2024;Yehudai 等,2025)。(3)安全性与伦理风险随自主程度上升而加剧。智能体可能执行意料之外的有害行为、放大训练数据中的社会偏见,或在关键决策场景中(如金融、医疗或安全)造成责任归属不清的问题(Mitchell 等,2025;Deng 等,2024;Shen 等,2024)。 这些挑战的持续存在表明,在许多现实世界场景中,完全自主并非理想解决方案(Mitchell 等,2025;Natarajan 等,2025),并凸显了一个常被忽视的核心观点:人类参与的不可替代性。人类在提供关键澄清、上下文信息与领域知识、反馈修正以及监管控制方面扮演着重要角色。这促使研究者开始转向一种新的系统设计范式:基于LLM的人机协作系统(LLM-HAS)。 尽管已有若干综述涵盖了基于LLM的自主智能体(Wang 等,2024a;Li 等,2024a)、多智能体系统(Tran 等,2025;Wu 等,2025)以及特定应用场景(Wang 等,2025b;Peng 等,2025),但尚无专门聚焦于LLM-HAS的系统性综述。本综述填补了这一空白,提供了对LLM-HAS的全面且结构化的概览,澄清了基本概念,系统梳理了核心组成模块、新兴应用场景,以及该领域特有的挑战与机遇。据我们所知,这仍是首篇专注于基于LLM的人机系统的综述文章。我们希望通过整合当前知识,推动该快速发展的跨学科领域的深入研究与技术创新。 为了支持本文的持续资源更新,我们维护了一个开源GitHub仓库,以补充本综述中的内容。我们期望本综述能够激发更多关于LLM-HAS的探索、创新及其在各类研究领域中的广泛应用。 本综述的组织结构如下:第二节定义并形式化LLM-HAS;第三节详述构成该系统的核心模块(如人类反馈、交互方式、编排与通信协议);第四节探讨多样化的应用领域;第五节介绍开源实现框架、数据集与评测基准;第六节则讨论LLM-HAS所面临的关键挑战与未来发展机遇。