近年来,人工智能(AI)尤其是在深度学习和大型语言模型(LLM)方面的进展,推动了其在医学领域的整合。然而,这些发展也引发了公众对AI安全应用的担忧。在医疗保健中,这些担忧尤为重要,因为AI的伦理和安全部署对于保护患者健康和隐私至关重要。本文综述了可能在医学领域中影响安全性的AI实践风险,包括在不同人群中的性能下降、操作稳定性不一致、有效模型调优所需的高质量数据需求,以及模型开发和部署过程中数据泄露的风险。对于医疗从业者、患者和研究人员来说,LLM提供了一种通过语言与AI和数据互动的便捷方式。然而,它们的出现也加剧了安全担忧,特别是像幻觉问题等。本文的第二部分探讨了LLM在医学环境中特定的安全问题,包括处理复杂逻辑的局限性、将AI目标与人类价值观对齐的挑战、理解错觉以及关于多样性的担忧。对安全AI的深思熟虑开发有望加速其在实际医疗环境中的采用。

1. 引言

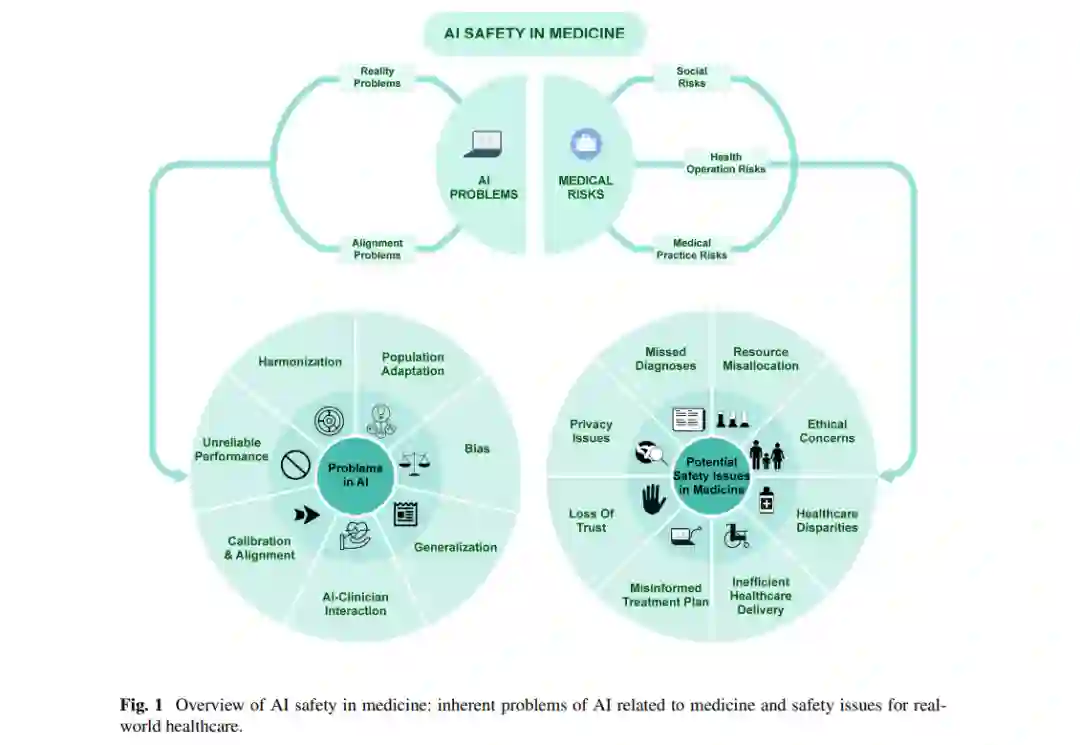

人工智能(AI)的最新进展为提高医疗效率和质量带来了重大机遇。仅在2023年,美国食品药品监督管理局(FDA)就批准了近700种AI驱动的设备,涵盖了放射学、眼科和血液学等多个医疗领域[1]。尽管取得了如此快速的进展,AI在医学中的成功应用仍然有限。最近的一项美国调查显示,60%的公众对医疗服务提供者依赖AI感到不安[2]。在患者、临床医生和公众中建立信任感至关重要,而确保安全是实现这一目标的关键。将AI系统应用于医疗中的安全挑战包括机器学习固有的科学问题、实施中的后勤障碍、采纳壁垒以及社会文化的变革需求。我们确定了两个关键领域,其中安全问题尤为突出:可靠性和一致性。AI可靠性的复杂性包括数据协调、性能一致性、校准、泛化、偏差与公平性、领域适应性以及AI与人类的交互[3, 4]。在本文中,AI的一致性指的是确保AI遵循人类定义的目标和原则,解决目标误指定和由患者或临床医生设定的奖励黑客问题。我们旨在通过首先讨论与医学风险相关的AI固有问题,然后探讨具体的医疗AI风险,最后总结大型语言模型(LLM)在医疗中的独特安全问题,来探讨AI在医学中的安全问题。

2. 与医学相关的AI固有问题

尽管AI近年来取得了重大进展,仍然存在许多挑战和问题,这些方法的局限性限制了其在医学中的应用,甚至可能导致潜在的安全问题。在本节中,我们将重点讨论与医学密切相关的AI的可靠性和一致性问题。

**2.1 医疗应用中AI的可靠性问题

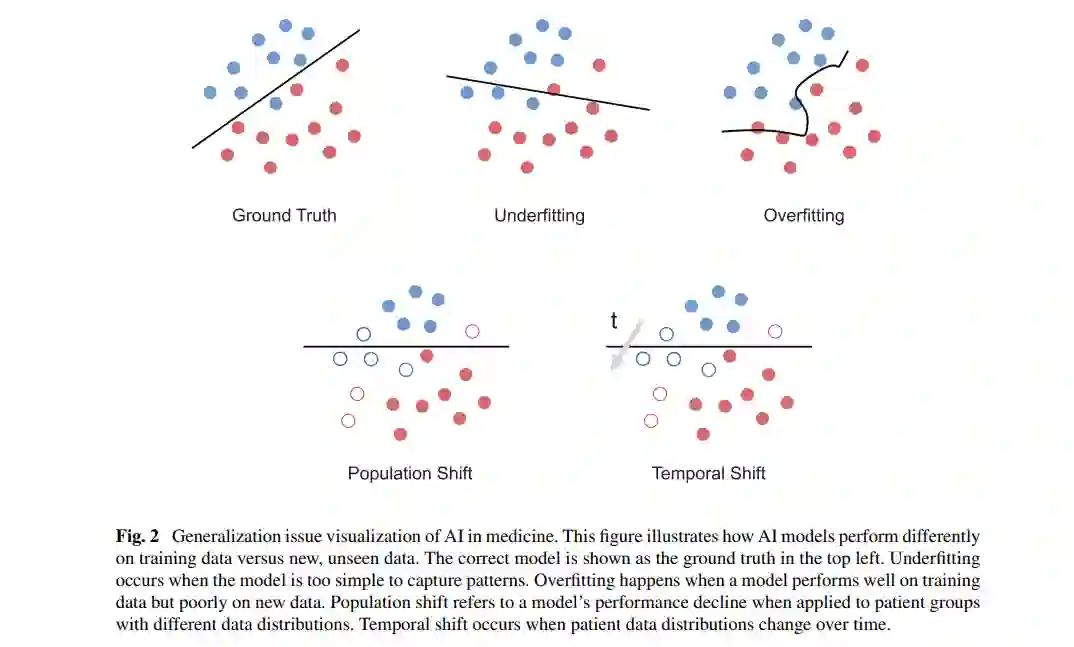

在医学实践中,建立能够被患者、临床医生和公众信赖的AI模型非常重要,因为医疗决策和结果的风险极高。然而,获得一个可靠的模型,即建立的模型应对潜在的干扰不变并始终根据不同的输入提供正确且准确的医疗指导,这在以下几个方面存在挑战,包括数据协调、模型校准、模型泛化和偏差。我们将在医疗环境中讨论这四个挑战。2.1.1 不同医疗提供者之间的数据协调数据协调挑战源于用于训练机器学习模型的数据的异质性。数据量的指数增长伴随着多样性的增加,这给数据管理和分析带来了巨大挑战。筛选这些异构数据的任务尤为复杂,影响了数据可视化和预测的过程,进而影响了分析结果。数据协调是一个至关重要的过程,旨在标准化不同形式的数据,尤其是在医学领域,以便进行统一的解释[5]。在医学机器学习领域,训练于有限数据集的模型缺乏泛化能力。当前的趋势倾向于使用来自多个医疗机构的大规模数据集,这使得多机构数据的协调变得不可或缺。数据协调通常是数据科学项目的初步步骤。如果协调不当,可能会引入错误,导致严重的医疗后果。无论规模大小,这些错误都会不可避免地改变特征值和分布,一些特征对这些扰动的容忍度较低。因此,将这些特征用于统计分析和模型构建可能会产生不可靠的结果,或掩盖真实的相关性,或错误地表明存在相关关系[6]。医学数据的协调在机器学习应用中面临几个重大挑战,包括:(1) 多样化的数据来源。医疗数据来自多个来源,如电子健康记录(EHR)、医学影像、基因组数据和可穿戴设备数据。它们独特的结构、格式和表示方式使得集成和共同分析变得困难[7-9]。(2) 不一致性和可变性:不同的医疗服务提供者可能会为相同类型的数据使用不同的术语、计量单位和编码方案,从而在数据集之间产生差异和不一致性。大多数数据已被证明对多个因素的跨机构变化高度敏感,包括设备制造商的差异、设备代次和型号、采集协议和重建设置的变化[6]。(3) 高维度性和复杂性:医学数据通常是高维的,涉及众多特征和变量。当不同类型的数据需要组合进行分析时,复杂性增加,需要复杂的方法来识别模式并做出预测[10]。(4) 标准化的缺乏:尽管医疗设备和行业中存在某些标准(如ISO),但在医疗文档和数据表示方面缺乏广泛认可和使用的全球标准,导致数据质量和结构的显著差异,给数据集成和随后的协调工作带来了困难[11, 12]。(5) 隐私和安全问题:医疗数据本质上是敏感的,其管理受严格的隐私和安全法规约束。这些法规虽然对于保护患者隐私是必要的,但通常限制了数据共享和合作的程度,从而限制了协调过程的范围[13-15]。(6) 偏差和代表性:数据收集方法和患者对医疗系统的访问存在差异,可能导致偏差或非代表性的数据集。这种数据集会影响机器学习模型的开发,进而对其泛化能力和可靠性产生负面影响[16, 17]。这些复杂性共同强调了创建适合开发可靠和有效的机器学习应用的连贯和全面的医学数据集的难度。2.1.2 针对不同患者的模型校准模型校准是医学AI中的另一个主要挑战。机器学习中的模型校准是一个关键过程,确保预测结果的概率与该结果的实际发生率高度一致。例如,如果一个校准的模型预测某事件的发生概率为80%,那么在大规模患者群体中,该事件应大约80%的时间发生。校准的主要挑战在于医学领域中AI预测置信度水平的正确解释和应用。首先,缺乏标准化的校准基准,目前没有公认的指导方针用于医学中的AI模型校准。这导致了模型可靠性水平的差异,并使跨医疗机构的性能评估变得复杂。其次,在医学环境中,置信度水平的误解很常见。临床医生可能会过度依赖置信度高的AI预测,削弱临床判断,或由于缺乏信任或理解而未能充分利用有价值的预测,尤其是在模型提供中等但具有临床意义的预测时。最后,随着医疗知识和实践的不断发展,保持AI模型的校准具有挑战性,这需要持续更新和重新校准,以确保新疗法和诊断技术的准确性。2.1.3 针对不同患者群体的泛化能力机器学习中的“泛化”指的是模型在训练后能够对未见过的数据表现良好的能力。对于医学AI应用,过拟合、欠拟合、人口转移以及时间变化是泛化能力常见的问题。2.1.4 针对不同患者群体的偏差机器学习模型在医学中的偏差问题是一个重要的关注点,因为它会影响医疗决策的可靠性和公平性,可能导致不同人群亚组的医疗不平等。2.1.5 适应新患者群体的困难将机器学习模型微调至本地数据是适应新患者群体和医疗环境的关键,但这也带来了挑战,影响了模型的有效性和泛化能力。

**2.2 医疗AI中的一致性问题

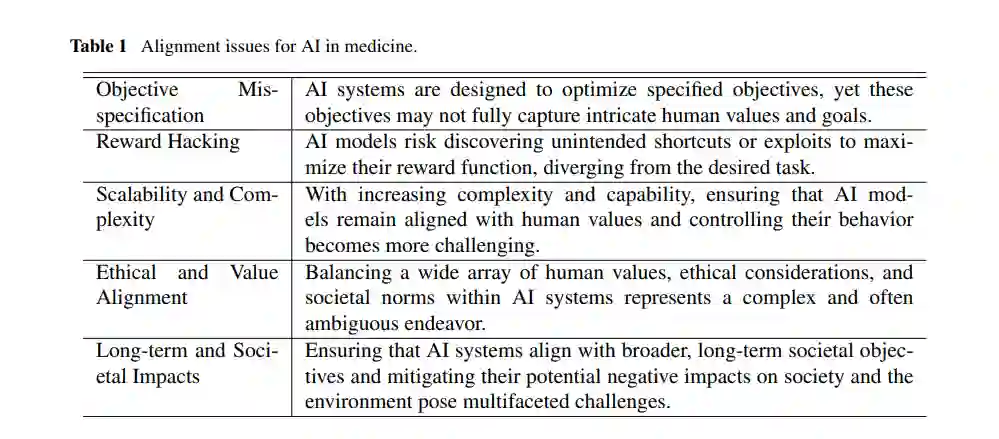

除了执行任务的可靠性外,确保AI模型的行为符合人类用户的目标和价值观也至关重要。我们讨论AI在医学中的一致性挑战,重点关注技术和规范性一致性以及AI与临床医生的互动。2.2.1 医学实践中的一致性挑战AI一致性问题涉及确保AI系统的行为与人类的价值观、意图和期望相一致。技术挑战包括“奖励黑客”等问题,而规范性挑战则涉及应当编码哪些人类价值观。2.2.2 AI与临床医生的互动与一致性AI与临床医生的互动和一致性是将AI解决方案应用于医学实践的基本方面。通过共识或分歧交叉验证实现的AI与临床医生的协作,将显著提高患者护理质量并降低临床运营成本。