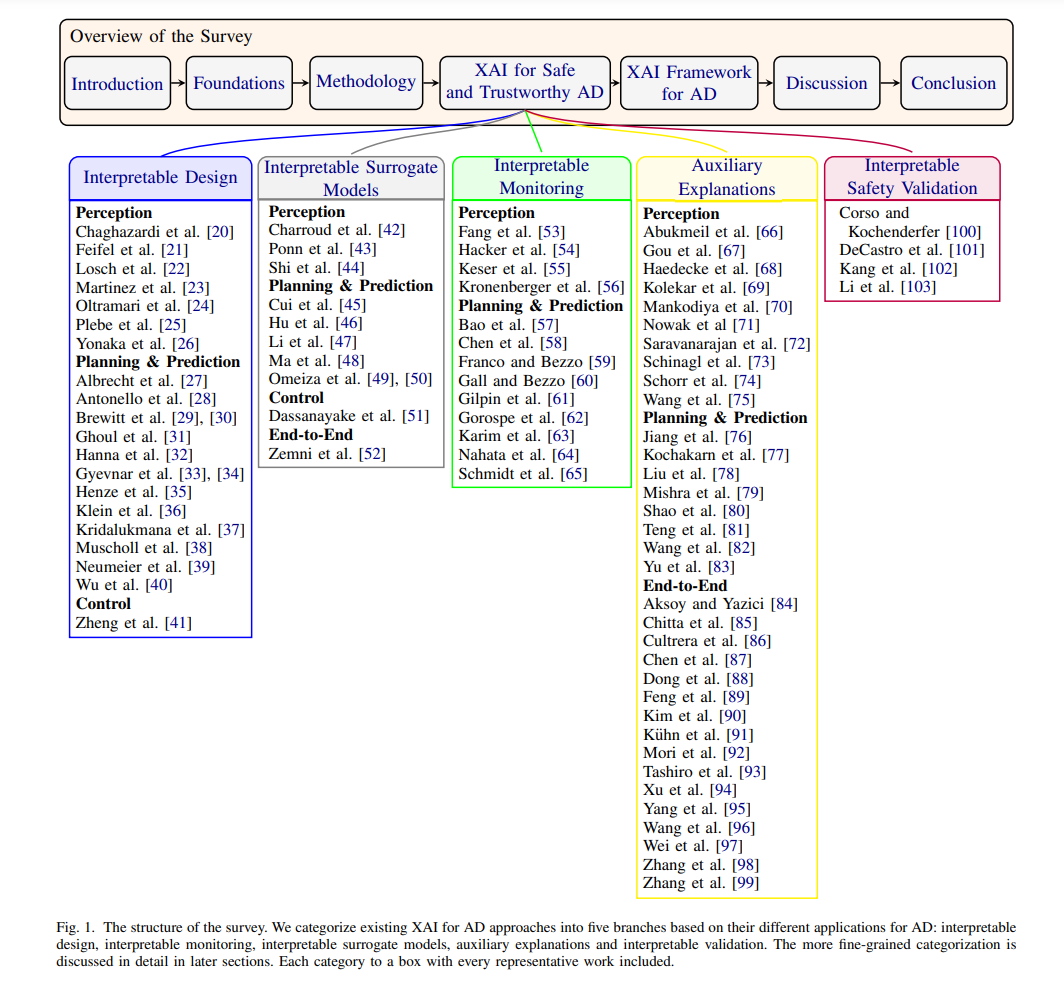

人工智能(AI)在自动驾驶(AD)的感知和规划任务中展现出了令人期待的应用前景,与传统方法相比,其优越的性能更是不言而喻。然而,难以解读的AI系统加剧了AD安全保障的现有挑战。解决这一挑战的方法之一是利用可解释AI(XAI)技术。为此,我们呈现了第一个关于安全可信赖AD的可解释方法的全面系统的文献综述。我们从分析AD中AI的需求开始,重点关注三个关键方面:数据、模型和代理。我们发现XAI对于满足这些需求至关重要。基于此,我们解释了AI中解释的来源,并描述了一个XAI的分类体系。然后,我们确定了XAI在AD中实现安全可信AI的五个关键贡献,分别是可解释设计、可解释替代模型、可解释监控、辅助解释和可解释验证。最后,我们提出了一个名为SafeX的模块化框架,以整合这些贡献,实现向用户提供解释的同时确保AI模型的安全。

人工智能(AI)在过去几十年里在各个技术领域获得了大量关注。特别是,基于深度神经网络(DNNs)的深度学习(DL)因其数据驱动的高维学习能力,在某些任务上提供了与人类相当乃至更好的性能[1],[2],因此自然而然地成为自动驾驶(AD)领域的一个重要组成部分。然而,深度学习缺乏透明度。它表现出黑盒行为,使其内部运作的洞察变得模糊。这种不透明性使得识别问题和确定哪些AI应用在现实世界中是可接受的变得更加困难。然而,在诸如AD这样的安全相关领域中,开发安全可信的AI至关重要。虽然存在几种缓解AI安全问题的过程,如合理的数据获取[3],但这些措施确保足够安全性的充分性仍是一个悬而未决的问题,这突出了进一步方法的需求。此外,目前没有标准明确指出在AD中使用数据驱动的AI。现有的安全标准ISO 26262 - 道路车辆 - 功能安全[4]并非专门为数据驱动的AI系统及其独特特性[5]而开发。标准ISO 21448 - 预期功能的安全性(SOTIF)[6]旨在确保由系统功能不足引起的危险没有不合理的风险,并且需要为每个危险制定定量的接受标准或验证目标。这一概念可以应用于基于AI的功能,但这些接受标准并没有明确定义[7]。此外,缺乏针对设计基于AI功能的具体指导。因此,这些标准在解决数据驱动深度学习系统的安全要求方面面临挑战[8]。尽管ISO/AWI PAS 8800 - 道路车辆 - 安全性和人工智能[9]的工作正在进行中,但由于它仍处于开发阶段,其范围和指导仍不清晰。总的来说,社会对AD也存在相对较高的不信任水平。美国汽车协会关于自动驾驶车辆(AV)的调查表明,美国68%的驾驶员对AV持谨慎态度[10],并且AI被认为是社会不接受AV的关键因素之一[11]。解决这些问题的一个有希望的方法是可解释AI(XAI)。XAI旨在提供人类可理解的AI行为洞察,开发XAI方法对不同利益相关者可能是有益的[12]。首先,它可能成为AI开发人员识别和调试故障的必要工具[13]。其次,XAI可以帮助用户根据AV的实际能力正确校准他们对自动化系统的信任[14],从而防止误用。最后,保险公司和监管机构也可能受益,因为XAI增加的透明度可以实现可追溯性,允许更准确地评估事故责任[15]。Muhammad等[16]甚至表示,未来在DL的AD中,包括公平性、责任性和透明度在内的监管合规性可能需要XAI。鉴于特别是针对AD的XAI文献不断增加,有必要系统地回顾哪些XAI技术存在以及它们如何被应用于增强AD的安全性和可信度。

A. 关于AD的XAI的先前回顾 我们注意到已经存在一些关于AD的XAI的回顾,我们在本小节中简要概述每个回顾。这些工作提供了该领域的挑战和利益相关者的良好概述,但存在一些关键缺陷:

-

缺乏系统和可复制的文献回顾方法论,导致可能的偏差和覆盖不完整;

-

没有专注于XAI在AD的安全性和可信度方面的具体益处和缺点;

-

没有回顾用于将XAI与AD集成的框架。Omeiza等人[17]的工作是该领域的第一个值得注意的综述。他们提供了AD中XAI的全面看法,涵盖了解释的不同需求、法规、标准和利益相关者,以及在AD中应用的一些解释性方法的概述。他们回顾了为AD设计有用的XAI系统所涉及的挑战及相关文献,然而,这个回顾既不可复制也不完整,特别是对于感知和规划任务。此外,Atakishiyev等人[18]覆盖了与Omeiza等人非常相似的主题,但对最近的XAI技术在AV感知和规划方面有稍微广泛的覆盖。独特地,他们是第一个提出将XAI与现有AD技术集成的端到端框架的,然而,他们没有进一步探索这个方向。他们的文献回顾也以一种不可复制的方式进行。最后,Zablocki等人[19]的文献回顾识别了潜在的利益相关者以及为什么他们可能需要解释、对他们有用的解释类型以及何时需要提供解释。基于此,他们检查了文献中的不同方法。然而,他们没有专注于XAI在满足安全和可信AI要求方面的影响。此外,综述在完整性方面存在一些缺陷,因为他们只关注了端到端系统的基于视觉的方法。因此,他们没有考虑可以应用于模块化AD管道的XAI方法和感知规划。

B. 主要贡献鉴于现有作品和XAI对AD日益增长的重要性,我们做出以下贡献:

- 我们讨论了AD中AI的详细要求,并强调了XAI在满足这些要求中的重要性。

- 我们提供了一个结构化、系统化和可复制的关于AD中应用XAI的回顾,重点关注环境感知、规划和预测以及控制;

- 根据我们的回顾,我们确定了五种应用于安全和可信AD的XAI技术范式,包括可解释设计、可解释替代模型、可解释监控、辅助解释和可解释验证。此外,我们使用具体示例讨论每个范式;

- 我们分析了现有模块化XAI框架在AD中的局限性,然后提出了一个更具体和可操作的安全可解释AI框架,称为SafeX,基于总结的XAI技术。C. 范围和结构 我们的研究提供了AD当前最先进的XAI方法的全面视图,包括模块化和端到端管道,重点关注感知、规划和预测以及控制。基于我们回顾的方法,我们还提出了一个模块化框架,将XAI纳入AV设计。然而,我们的调查没有识别利益相关者,也不旨在提供DNNs或强化学习等数学基础的背景。对于这些,第I-A节中的现有综述提供了良好的覆盖。我们的调查结构如图1所示。在第II部分,我们提供基础,在这里我们定义了可信AI并确定了应用AD中AI的要求。此外,我们描述了AI系统的各种解释来源,并引入了XAI概念以及AD组件的术语分类。第III部分描述了我们的研究问题和调查方法论,确保可复制性。第IV部分调查了文献,分为可解释设计、可解释监控、可解释替代模型、辅助解释和可解释验证。在第V部分,我们回顾了AD中现有的XAI框架,并提出了我们的框架SafeX。在第VI和第VII部分,我们根据我们的调查结果讨论我们的发现,并确定未来的方向。II. 基础 我们在这一节开始探索可信AI的需求。然后我们检查应用AD中可信AI的要求。我们的分析强调了XAI在满足这些要求中的关键作用,并识别了AI系统中解释的来源。我们通过回顾XAI的分类以及AD组件的详细术语来结束。A. 可信AI 在我们开始讨论AD中的XAI时,了解AI中解释需求的来源很重要。历史上,AI是基于符号表示的,其中信息使用定义明确的数学符号编码,如命题逻辑或程序归纳。AI应用的第一个成功实例是专家系统[104],它依赖于此类符号表示,这使它们在不同程度上具有固有的可解释性,通常以推理的因果链的形式表现出来。相比之下,当前的神经AI方法依赖于子符号表示。在这一范式下,输入数据通过从大量训练数据中学习数百万个参数来数学转化为输出。这种方法允许模拟高度复杂的多维关系,从而产生高性能。然而,由于其庞大的规模和高度的抽象,子符号系统的输出不具可解释性。因此,它们通常被视为缺乏透明度的黑盒。尽管这种效率与透明度的权衡有时是可以接受的(甚至可以说不存在[105]),但如AD这样的高度复杂的安全相关系统不能完全依赖于黑盒系统,因为它们不容易获得安全认证。这还包括无数的伦理、社会和法律原因,为什么神经方法也可能是可疑的[106]。