人工智能(AI)的快速发展引发了专家、政策制定者和世界领导人对日益先进的人工智能系统可能带来灾难性风险的日益担忧。虽然许多风险已被单独详述,但目前迫切需要对潜在危险进行系统的讨论和说明,以便更好地为减轻这些危险提供信息。本文概述了人工智能灾难性风险的主要来源,将其分为四类:恶意使用,即个人或团体故意使用人工智能造成伤害;人工智能竞赛,即竞争环境迫使行为者部署不安全的人工智能或将控制权让给人工智能;组织风险,强调人为因素和复杂系统如何增加灾难性事故的几率;流氓人工智能,描述控制远比人类智能的代理固有的困难。对于每一类风险,我们都描述了具体的危害,介绍了说明性故事,设想了理想场景,并提出了减轻这些危险的实用建议。我们的目标是促进对这些风险的全面了解,并激发集体的积极努力,确保以安全的方式开发和部署人工智能。最终,我们希望这将使我们能够实现这一强大技术的益处,同时将灾难性后果的可能性降至最低。

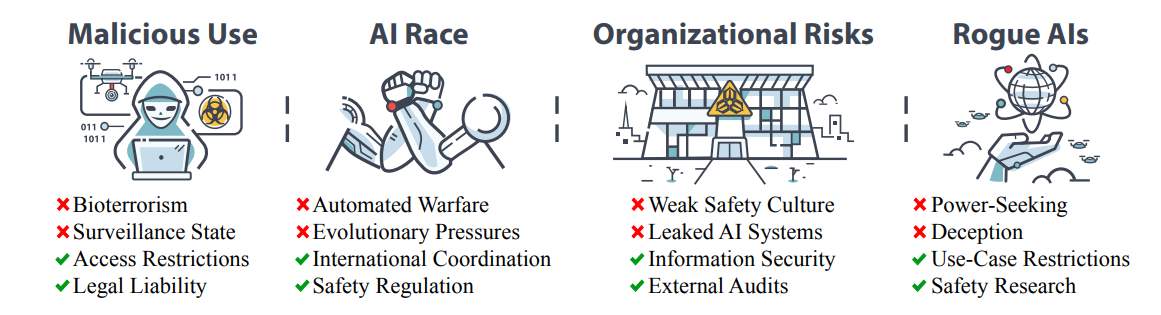

图:本文将介绍四类人工智能风险,并讨论如何降低这些风险。

近年来,人工智能(AI)突飞猛进,引起了人工智能专家、政策制定者和世界领导人对先进人工智能所带来的潜在风险的担忧。与所有强大的技术一样,人工智能必须以高度的责任感来管理风险,并利用其潜力来改善社会。然而,关于灾难性或生存性的人工智能风险可能如何发生或如何应对,可获得的信息非常有限。虽然有关这一主题的资料很多,但往往分散在各种论文中,而且通常针对的受众面较窄,或侧重于特定的风险。在本文中,我们将概述灾难性人工智能风险的主要来源,并将其分为四类:

恶意使用。行为者可能故意利用强大的人工智能造成广泛伤害。具体风险包括人工智能赋能的生物恐怖主义,它可以帮助人类制造致命的病原体;蓄意传播不受控制的人工智能制剂;以及利用人工智能能力进行宣传、审查和监视。为了降低这些风险,我们建议改善生物安全,限制获取最危险的人工智能模型,并让人工智能开发者为其人工智能系统造成的损害承担法律责任。

人工智能竞赛。竞争可能会迫使国家和企业匆忙开发人工智能,并将控制权拱手让给人工智能系统。军方可能会面临开发自主武器的压力,并将人工智能赋能的网络战,从而实现一种新的自动化战争,在这种战争中,事故可能会在人类有机会干预之前就失控。企业也将面临类似的激励,促使人类劳动自动化,并将利润置于安全之上,从而可能导致大规模失业和对人工智能系统的依赖。我们还讨论了从长远来看,进化压力可能会如何塑造人工智能。人工智能之间的自然选择可能会导致自私的特性,而人工智能相对于人类的优势最终可能导致人类被取代。为了降低人工智能竞赛带来的风险,建议对通用人工智能实施安全监管、国际协调和公共控制。

组织风险。组织事故造成的灾难包括切尔诺贝利、三里岛和挑战者号航天飞机灾难。同样,开发和部署先进人工智能的组织也可能遭受灾难性事故,特别是如果它们没有强大的安全文化。人工智能可能会意外泄露给公众或被恶意行为者窃取。各组织可能无法投资于安全研究,不了解如何以比一般人工智能能力更快的速度可靠地提高人工智能的安全性,或者压制内部对人工智能风险的担忧。为了降低这些风险,可以建立更好的组织文化和结构,包括内部和外部审计、多层风险防御以及最先进的信息安全。

流氓人工智能。一个普遍而严重的担忧是,随着人工智能变得比我们更智能,我们可能会失去对人工智能的控制。人工智能可能会在一种被称为代理博弈的过程中,将有缺陷的目标优化到极致。人工智能在适应不断变化的环境时,可能会经历目标漂移,这与人在一生中获得和失去目标的过程类似。在某些情况下,人工智能变得追求权力可能是工具理性的。我们还研究了人工智能如何以及为何会进行欺骗,在不受控制的情况下表现出受控制的样子。与前三个风险来源相比,这些问题更具技术性。我们概述了一些建议的研究方向,以促进我们对如何确保人工智能可控的理解。

在每一节中,我们都提供了一些说明性场景,更具体地展示了风险源如何可能导致灾难性结果,甚至构成生存威胁。通过提供一个对风险进行适当管理的更安全未来的积极愿景,我们强调,人工智能新出现的风险虽然严重,但并非不可克服。通过积极应对这些风险,我们可以努力实现人工智能的益处,同时最大限度地降低灾难性后果的可能性。