基于机器学习的KPI自动化异常检测系统

作者:刘平

转自:「智能运维前沿」订阅号

导读

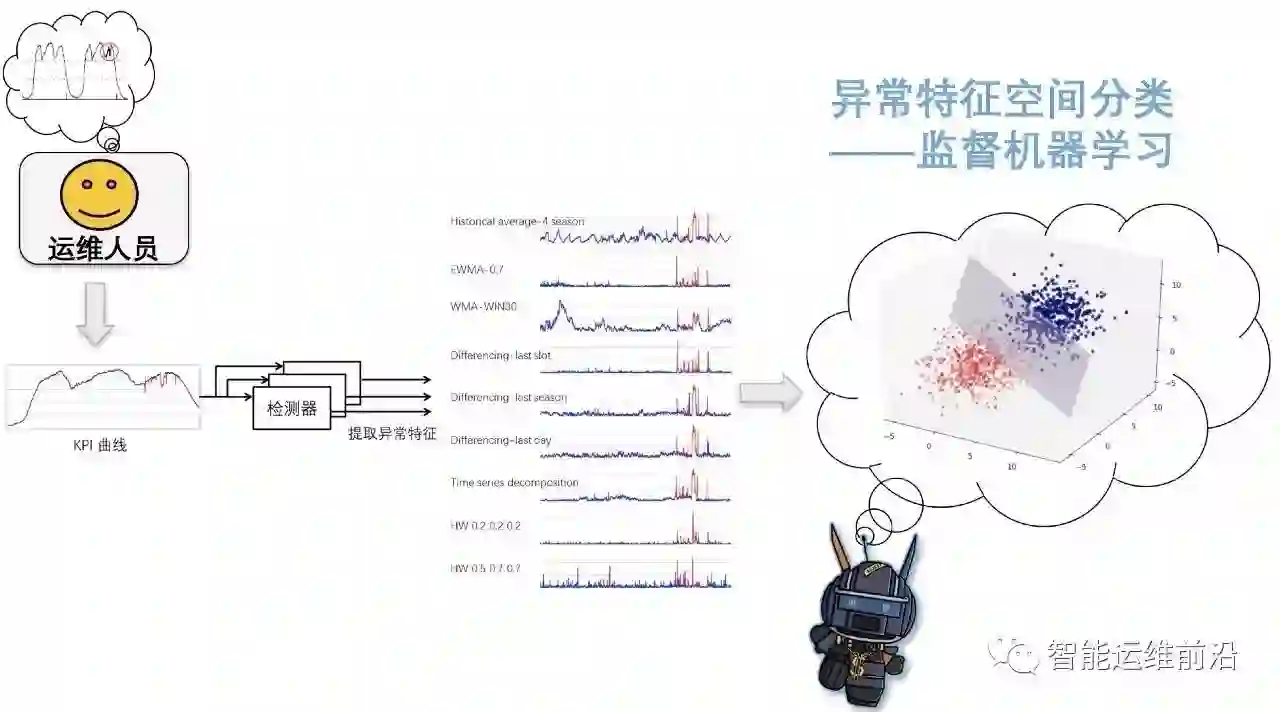

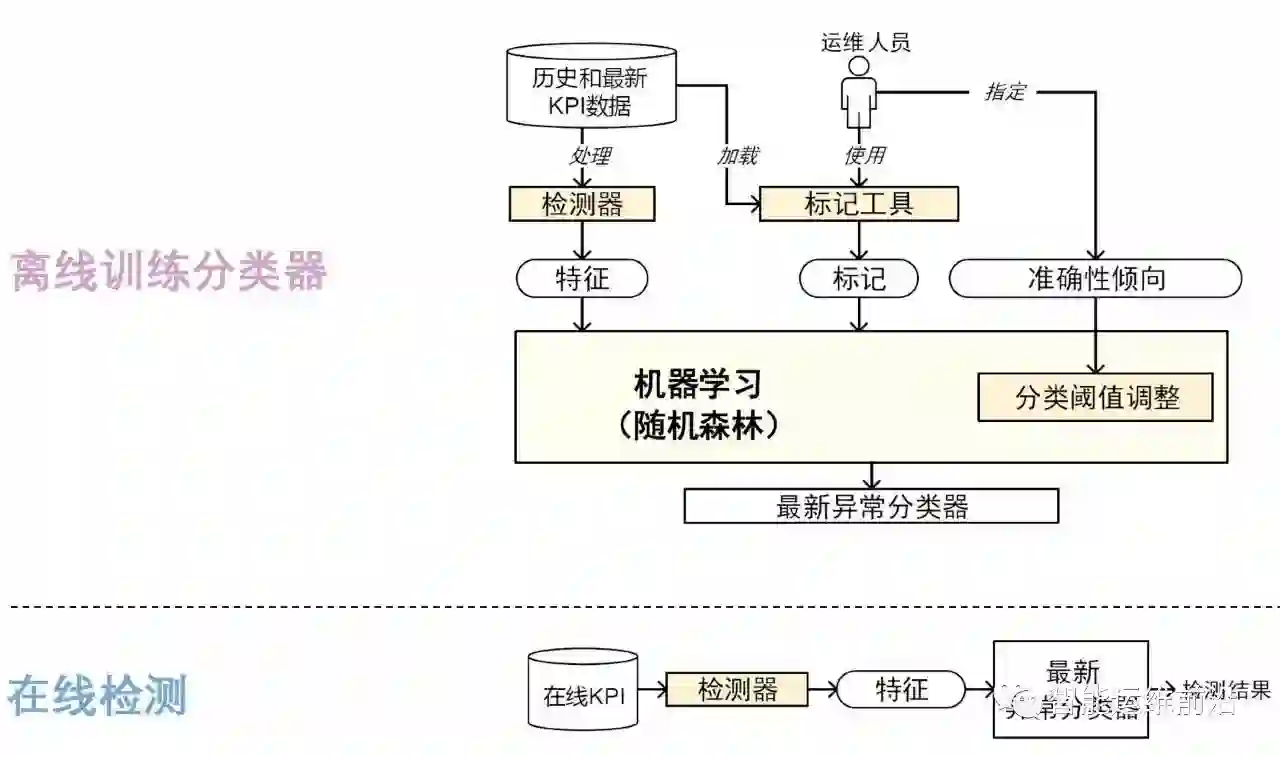

今天给大家介绍Netman实验室在异常检测领域的研究成果:基于机器学习的KPI自动化异常检测系统(Opprentice)。在实际生产环境中,异常检测系统的痛点就是异常检测算法的选择以及算法参数的调整,这个过程往往耗费大量的人力和时间,但是往往效果无法达到预期,Opprentice主要针对这类难题设计,通过将异常检测问题转换为监督式的机器学习问题,实现了异常检测算法的自动选择和算法参数的自动调整。

如何构建一个异常检测系统?

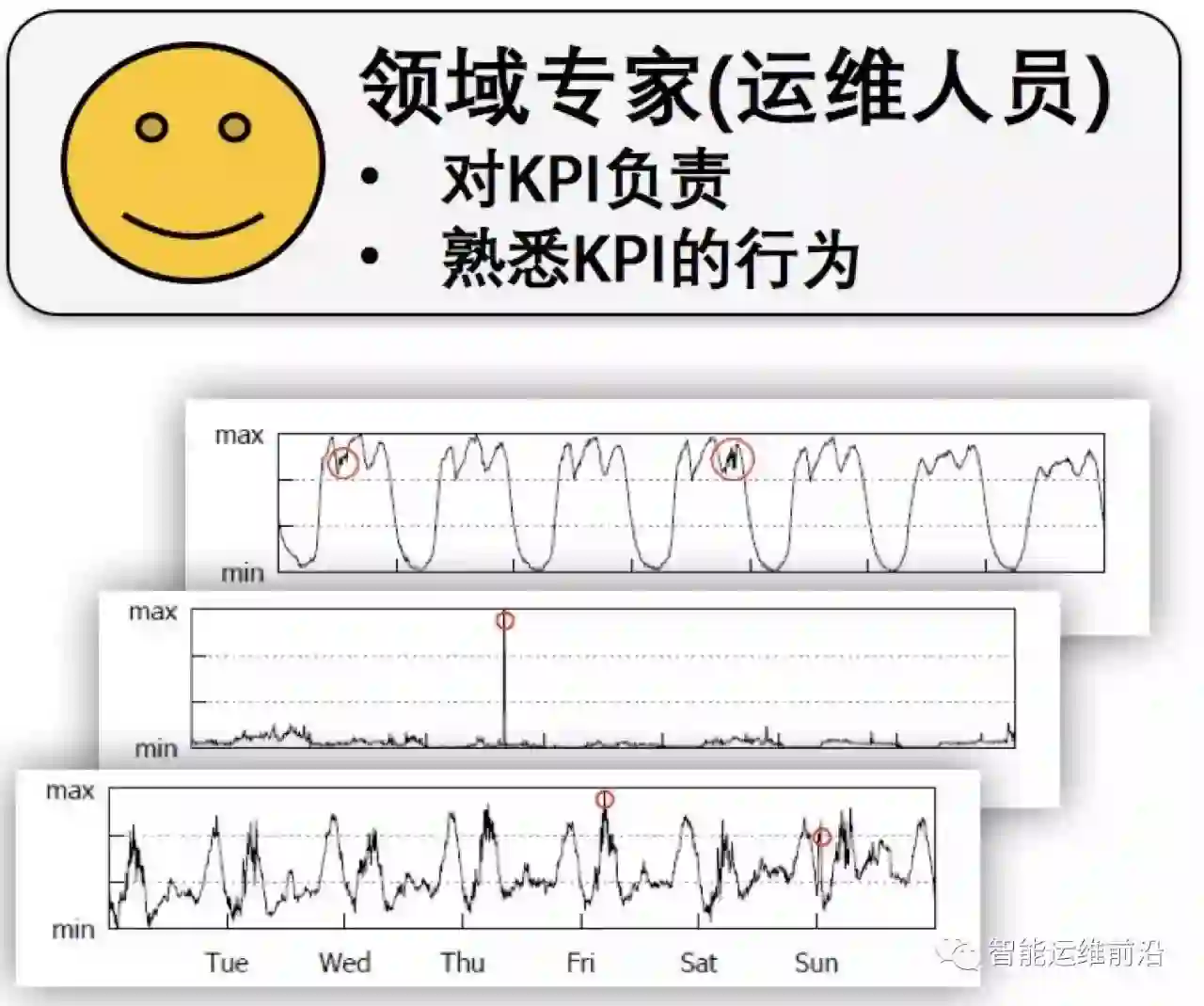

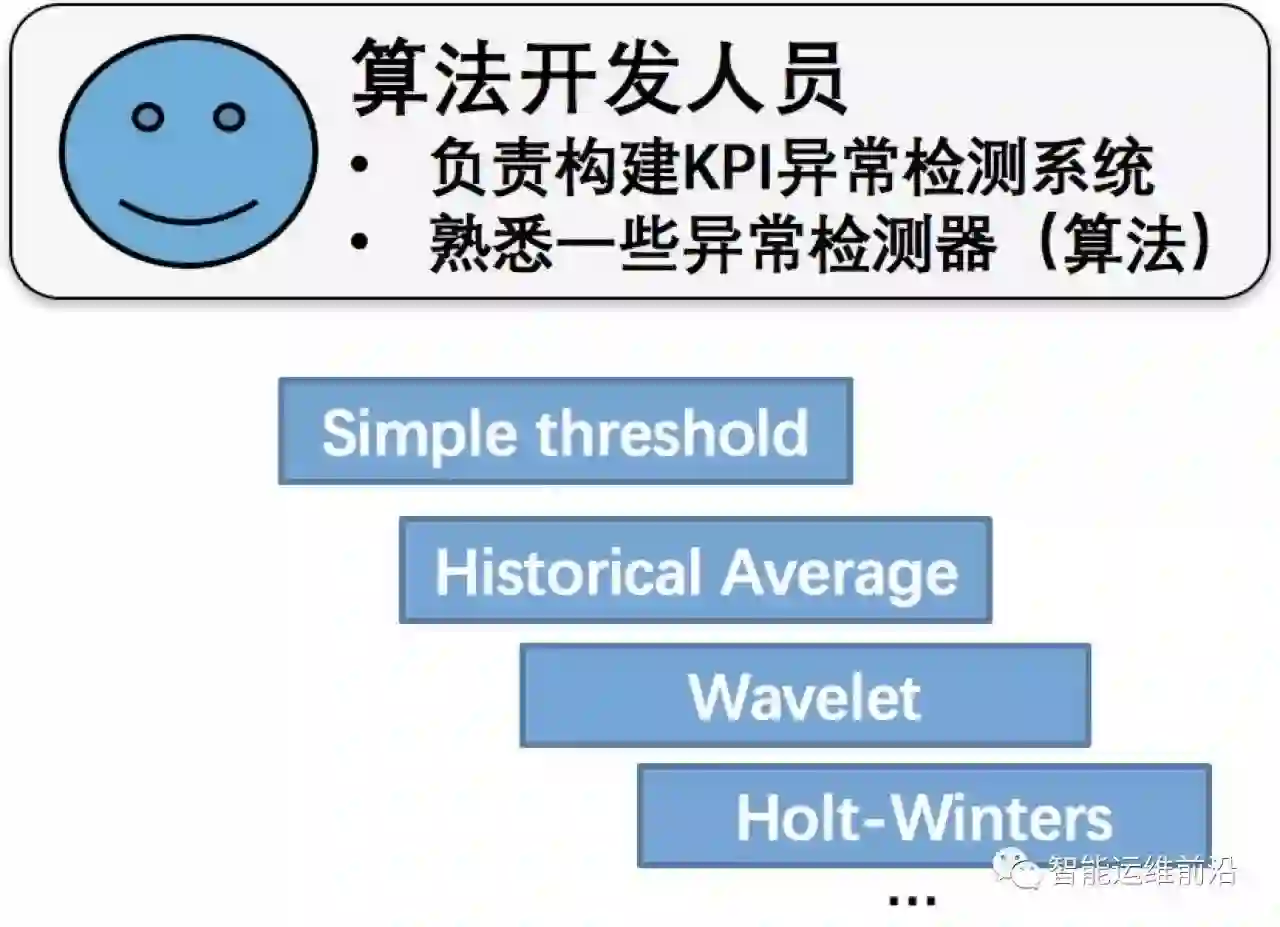

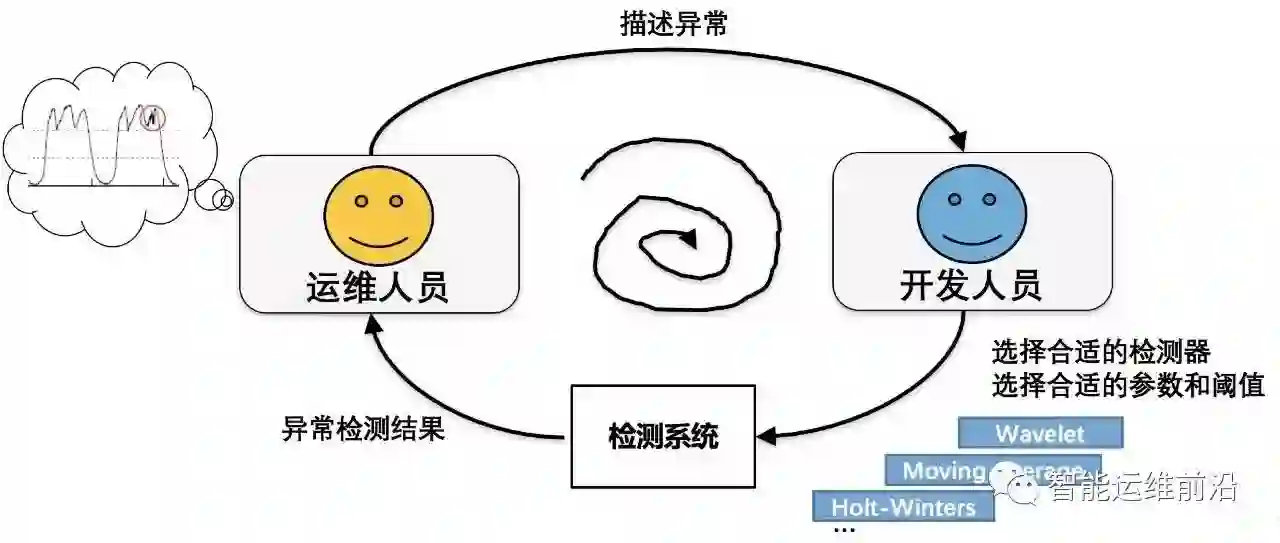

在实际构建异常检测系统时,首先需要运维人员结合自己的领域知识向算法开发人员描述异常,然后开发人员根据这些描述来为KPI曲线选择合适的检测器和算法参数,接着领域专家根据这些检测器的检测结果向开发人员反馈,来进一步优化检测器。所以实际中经常需要经过多次迭代才能开发出可用的异常检测系统,有时还会出现最终开发失败的例子,这是因为:

运维人员难以事先给出准确、量化的异常定义

选择和综合不同的检测器需要很多人力

检测器算法复杂,参数调节不直观

实际中经常需要经过多次迭代才能开发出可用的异常检测系统,有时还会出现最终开发失败的例子。因此,我们就会问,有没有一个可以自动选择异常检测器和自动调节算法参数的系统呢?答案是有!,我们实验室的研究成果:基于机器学习的KPI自动化异常检测系统(Opprentice)就是针对它设计的,下文将主要介绍Opprentice 的设计思想以及设计框架。

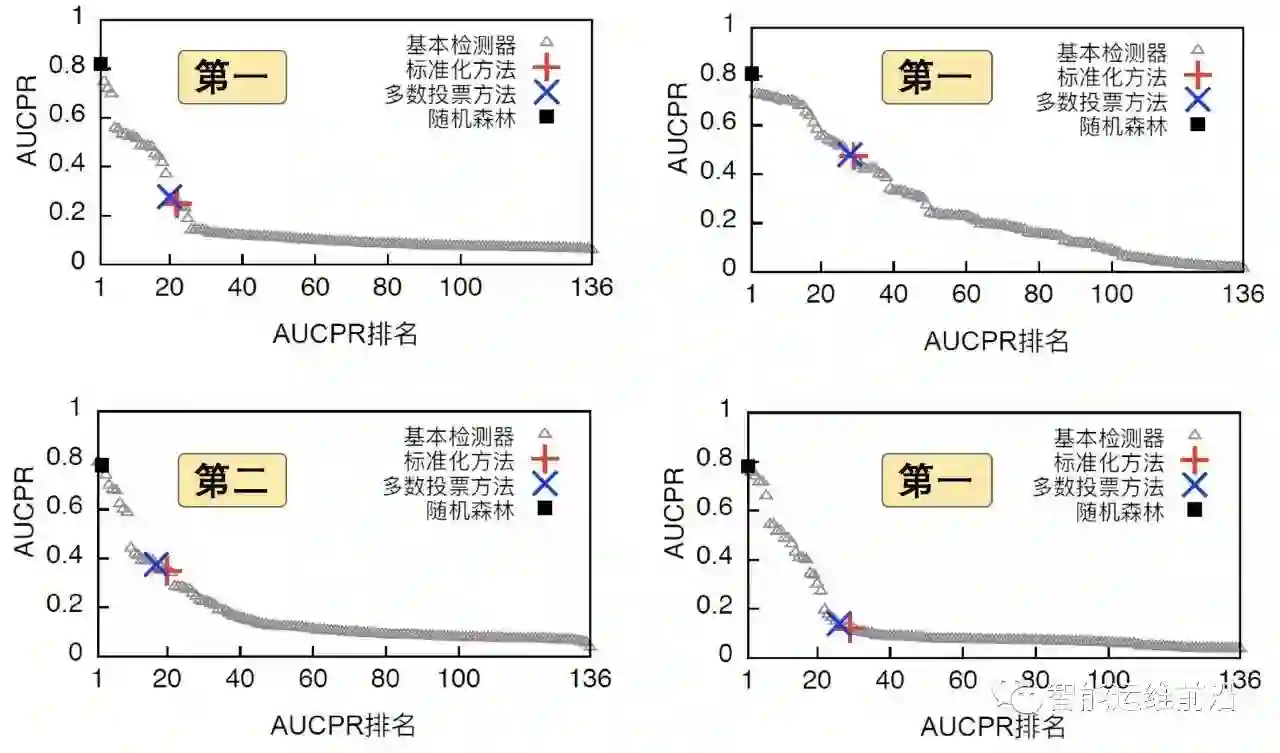

设计思想

设计框架

总结

商务合作,请加微信yunweibang555

登录查看更多

相关内容

在数据挖掘中,异常检测(英语:anomaly detection)对不符合预期模式或数据集中其他项目的项目、事件或观测值的识别。通常异常项目会转变成银行欺诈、结构缺陷、医疗问题、文本错误等类型的问题。异常也被称为离群值、新奇、噪声、偏差和例外。

特别是在检测滥用与网络入侵时,有趣性对象往往不是罕见对象,但却是超出预料的突发活动。这种模式不遵循通常统计定义中把异常点看作是罕见对象,于是许多异常检测方法(特别是无监督的方法)将对此类数据失效,除非进行了合适的聚集。相反,聚类分析算法可能可以检测出这些模式形成的微聚类。

有三大类异常检测方法。[1] 在假设数据集中大多数实例都是正常的前提下,无监督异常检测方法能通过寻找与其他数据最不匹配的实例来检测出未标记测试数据的异常。监督式异常检测方法需要一个已经被标记“正常”与“异常”的数据集,并涉及到训练分类器(与许多其他的统计分类问题的关键区别是异常检测的内在不均衡性)。半监督式异常检测方法根据一个给定的正常训练数据集创建一个表示正常行为的模型,然后检测由学习模型生成的测试实例的可能性。

Arxiv

3+阅读 · 2019年3月20日

Arxiv

4+阅读 · 2018年4月2日