人工智能(AI)的成功,特别是深度学习模型,由于它们能够处理大量数据并学习复杂模式,已经导致了它们在各个行业的广泛采用。然而,由于它们缺乏可解释性,关于它们在金融和医疗等关键领域的使用存在重大担忧,这些领域中决策透明度至关重要。在本文中,我们提供了一项比较综述,目的是在金融背景下提高深度学习模型的可解释性。我们根据它们相应的特征对可解释AI方法的集合进行分类,并回顾了采用可解释AI方法的担忧和挑战,以及我们认为适当和重要的未来方向。

https://www.zhuanzhi.ai/paper/d63c36f6fb9fa3686573070179162960

金融是一个不断发展的领域,深深植根于人类文明的发展之中。金融的主要任务之一是资源的高效配置,一个主要的例子就是处理不同需求的各个实体之间的资本流动。这些实体可以分为个人、公司和国家,并导致了个人、公司和政府金融的常见分类。该领域可以追溯到5000年前,在那个时候已经建立和发展了几千年的农业社会。实际上,金融中的中央机构——银行的第一个例子可以归因于巴比伦帝国。从那时起,社会发展和技术进步推动了这个领域经历了几次变革。在过去的二十年里,由于技术发展的加速步伐,特别是在AI的背景下,这些变化特别明显。后者已经开始在金融的多个领域传播,从数字交易到投资管理、风险管理、算法交易等[114]。现在使用新颖的AI和非AI技术来自动化和改善金融流程被称为金融科技(FinTech),在过去的二十年里,它的增长是显著的[89]。在本次回顾中,我们关注基于AI的技术和机器学习在金融应用中的使用

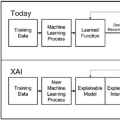

金融研究人员和从业人员一直依赖于监督、无监督和半监督的机器学习方法以及强化学习来处理许多不同的问题。一些例子包括信用评估、欺诈检测、算法交易和财富管理。在基于监督的机器学习方法中,通常使用神经网络来识别隐藏在可用标记数据中的复杂关系。这些标签通常由领域专家提供。例如,人们可以想象构建一个股票选择系统,在该系统中,领域专家标记正收益和负收益的时期。然后机器被分配任务来建立(可能是)高维数据和给定股票(或多只股票)的正和负回报之间的关系,并泛化到未见数据以预测未来股票的行为。在基于无监督的机器学习方法中,任务是识别可以聚集在一起的具有相似特性的数据,无需领域专家标记。例如,可以考虑使用一些相似度度量,如估值、盈利能力和风险,将所有具有相似特性的股票识别到群集中。半监督学习是监督学习和无监督学习之间的中间地带,只有一部分数据有标签。最后,强化学习的目标是通过一组行动最大化由从业者指定的累积奖励。强化学习用于金融,例如,投资组合构建。强化学习与马尔科夫决策过程紧密相关,与监督学习和无监督学习有很大的不同。 在监督、无监督和强化学习方法中,存在着极大的复杂性异质性。有些方法被认为容易理解,因此也被从业者解读(也被称为白盒方法),而其他一些被认为不可解释(也被称为黑盒方法)。为此,神经网络和深度学习策略,支持大多数(虽然不是全部)最近的金融应用机器学习方法,被视为黑盒方法——即,给定预测的原因不容易获取(如果可用)。这构成了一个关键问题,特别是在风险和高度监管的行业,如医疗和金融,错误的决定可能导致生命(医疗)或资本(金融)的灾难性损失。因此,理解机器用于做出特定决定的原因(即,数据和模式)被认为是重要的。这一方面涵盖了AI透明度的广泛领域。后者由三个支柱组成,(一)AI意识,(二)AI模型可解释性,和(三)AI结果可解释性。第一个任务是理解AI是否涉及到给定的产品。第二个负责提供AI模型的详细解释,包括其输入和输出。第三个负责提供输入对AI模型结果的详细解释。在这最后一类别中,我们发现了大量的事后可解释性方法。在这篇回顾中,我们假设已经实现了AI意识,即我们知道在给定的金融过程中涉及了AI,并集中在AI可解释性上,也称为可解释AI或简称XAI。常见的进一步区分是AI模型的可解释性和解释性之间的区别。这两个术语经常可以互换使用,但有细微的差别。可解释性指的是模型如何及为什么运作。解释性指的是以人类术语解释结果的能力。

尽管深度学习方法被视为黑箱方法,但金融领域中的许多其他方法被视为白箱方法。复杂性与可解释性之间的权衡可能是金融人工智能领域最有争议的方面之一。一方面,白箱方法具有很高的可解释性,但缺乏把握复杂关系的能力,通常无法达到预期的性能。另一方面,黑箱方法虽然通常(但不总是)满足预期性能,但不可解释。因此,近年来,为使黑箱方法更加可解释而进行的努力显著增加,深度学习领域是主要例子。在本文中,我们对金融领域的XAI方法进行了广泛的调研,我们称之为FinXAI。尽管已有一些关于XAI方法的调查[7,19,49,88,90,102,105],但这些论文主要针对一般XAI,而不是特定于金融。因此,我们对仅与金融用例相关的可解释性技术进行了调研。

为了编写这篇综述,我们考虑了69篇论文,主要关注第三支柱,即AI模型结果的输入的可解释性。为此,我们考虑了应用于黑箱深度学习模型的事后解释方法,以及不需要进一步事后解释的固有透明模型。尽管在XAI领域收集的论文相对较少,但重要的是要注意,我们的主要目标是专注于适用于金融业的XAI技术。这种有针对性的方法将为相关领域的研究人员提供宝贵的见解,并最终将推动金融业的创新和发展。随着对深度学习的透明度和可靠性的需求日益增长,XAI社区已经看到了发表的作品数量不断增长,我们在这里只关注与金融用例有关的作品。值得注意的是,FinXAI只是XAI通用领域的一个小子集,因此,我们采取全面的方法来组装现有研究,目标是与当前的方法保持同步。我们从Google学术和Scopus中查询了论文,我们使用了一组关键词,涉及已在金融用例中应用了可解释AI技术的作品,这组关键词包括“XAI,可解释AI,金融,金融部门,金融领域,可解释ML”。我们试图收集一系列充分涵盖每个类别的论文,并在表1、2、3中进行了总结。我们还注意到,大多数解释类型仅限于基于事实的解释,因此我们明确寻找以反事实形式解释的技术。反事实解释被视为一种理想的解释形式,因为接收者往往更喜欢了解为什么做出了某个预测,而不是相反。 **我们的主要贡献如下: **

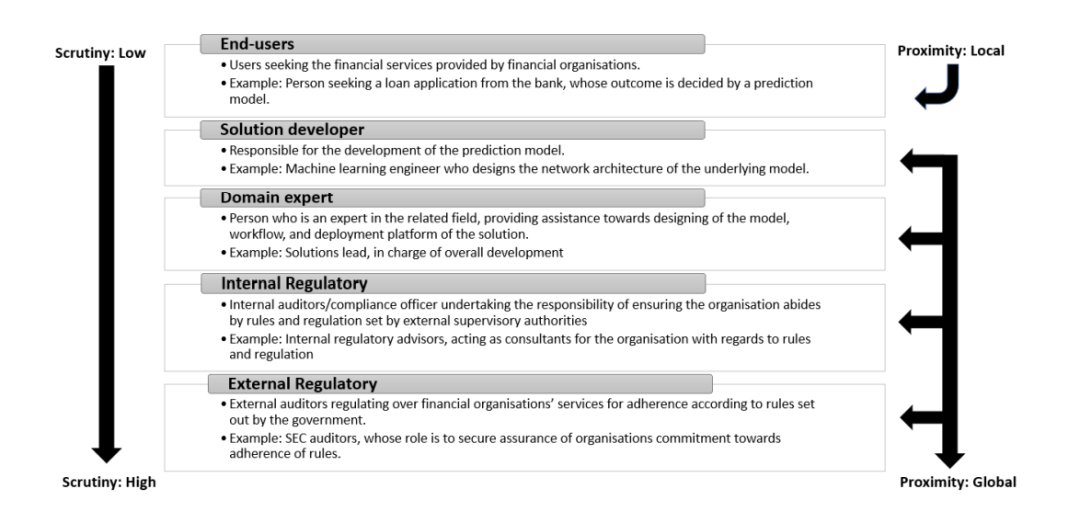

• 我们提供了一个关于金融领域XAI方法的广泛研究(FinXAI),供对在他们的解决方案中优先考虑透明度的研究人员参考。 • 我们将FinXAI过程定位为一系列的决策过程(参见图4),我们强调将XAI技术与目标受众保持一致。这个框架的目标是产生既面向目标又以观众为中心的解释。 • 我们调研了当前的FinXAI技术,分析了它们对伦理目标的技术贡献,并列出了实施XAI时面临的一些关键挑战以及未来需要改进的重要方向。

本综述论文的其余部分的组织如下:第2部分描述了FinXAI的定义、原因和简要概述。随后,我们从第3部分的数字开始,解释了FinXAI的方法论,文本在第4部分,混合分析在第5部分,以透明模型结束在第6部分。在第7部分,我们分析了调研过的FinXAI方法是如何促进伦理目标的。第8部分讨论了采用可解释模型的关键挑战和未来研究方向。最后,第9部分提供了结论性评论。

FINXAI: 金融可解释人工智能

FinXAI 或者说金融领域中的可解释 AI 方法,是与 AI 透明度这一更广泛概念密切相关的。 如第 1 节所述,这个术语在一个单一框架下包含了三个关键步骤:AI 意识,AI 模型可解释性,和 AI 结果可解释性。在本次综述中,我们主要关注后两个方面,即模型和结果的可解释性。模型可解释性意味着给定的 AI 解决方案的内部运作是可以解释的,因此结果可被人类理解。这通常适用于复杂度较低的模型(即白盒模型),如线性和逻辑回归以及决策树。结果可解释性意味着给定的 AI 解决方案的内部运作不是完全可解释的,因此除非应用一些可解释性工具来解释 AI 的结果,否则结果可能不会被人类完全理解。这适用于复杂的模型(即黑盒模型),例如深度神经网络。在这些情况下,通常会应用模型不可知的事后解释工具(以及其他解释工具)来理解 AI 用人类的语言提供的结果。 相应地,XAI 模型可以分为两大类:由于其高度可解释的性质而固有地可解释(例如,线性和逻辑回归),和外在可解释的,因此需要外部工具使它们变得可解释。反过来,这两类模型导致了不同类别的模型透明度:可模拟性、可分解性和算法透明度 [7]。这三个类别中的每一个都继承了前一个类别的属性,即,如果一个模型是可分解的,那么它也是可模拟的,如果一个模型在算法上是透明的,那么它也是可分解和可模拟的。简单来说,可模拟性是指模型能够允许人类观察者模拟模型内部运作的思考过程。可分解性意味着模型的每个部分都是可解释的,包括输入、输出以及模型的内部运作和参数。算法透明度主要涉及人类用户能够理解模型如何应对不同的输入,并且更重要的是,能够推理模型产生的错误。 透明的模型是一种可解释的模型,它展现出能够提供人类能理解的解释的能力。透明度的领域不仅仅存在于模型的区域内,还存在于最终产品的数据和设计过程中 [118]。欧盟人工智能高级专家组 [54] 声明,模型交互的数据应该在任何时候都能被人类用户追溯。此外,系统的设计过程必须清晰且以相关利益相关者能理解的方式进行解释。被视为可解释的信息类型清单甚至可以扩展到包括 AI 系统开发的原则和指南,以及参与实施和开发过程的人员 [63]。

结论

总的来说,可解释性将继续成为金融科技中的一个关键焦点区域,因为公司寻求与消费者和监管者建立信任和信心。总结我们的工作,我们对金融领域的 XAI 工具(FinXAI)进行了全面的综述,突出了近年来在开发金融应用的可解释 AI 模型方面取得的重大进展。这包括固有透明的模型和事后解释性技术,我们主张对前者进行更多的改进。我们提供了一个框架,将选择适当的 FinXAI 工具建立为一个序列决策过程,强调观众和生成解释的迭代评估。所调研的作品根据它们各自的特性进行分类,以方便感兴趣的读者使用。我们还检查了当前 FinXAI 对几个道德目标的贡献,例如,可信度,公平性,信息性,可访问性,隐私,信心,因果性和透明度。 虽然到目前为止已经完成了很多伟大的工作,但综述也揭示了与 FinXAI 相关的一些限制和挑战。这包括衡量解释的忠实度和合理性的适当指标,以及过度依赖可能误导性解释的问题。未来的研究应该专注于解决这些挑战,以及探索 FinXAI 的新方向,包括将自然语言处理集成到生成解释的技术中,以及更加关注固有透明的模型。尽管如此,XAI 技术有很大的潜力在金融领域提高透明度,信任和问责性。这强调了在该领域进行积极研究和开发的重要性。