本文介绍NeurIPS 2024录用论文“Harmonizing Visual Text Comprehension and Generation”的主要工作。这篇文章提出了首个OCR领域的大一统多模态文字理解与生成大模型,即TextHarmony。TextHarmony不仅精通视觉文本的感知(文字检测识别等)、理解(KIE、VQA等)和生成(视觉文字生成、编辑、抹除等),而且在单一模型中实现了视觉与语言模态生成的和谐统一。 一、研究背景****

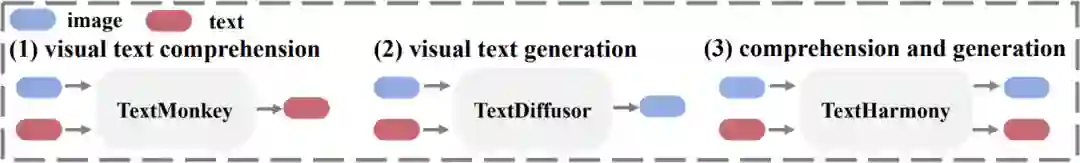

如何让机器像人类一样感知、理解、编辑和生成图像中的文字,一直是人工智能领域的热点问题。当前视觉文字领域的大模型研究专注于单模型生成任务,单模态生成的大模型虽然统一了某些任务,但无法做到OCR领域中大部分任务的大一统,比如Monkey等VLM只能处理文字检测、识别、VQA等文本模态生成的任务,无法胜任文字图像生成、抹除、编辑等图像模态生成的任务,基于Diffusion Model的图像生成模型如AnyText则相反,OCR领域中的多模态生成统一大模型仍然是一个空白。此外,研究人员在探索中发现,在多模态生成大模型中,视觉与语言模态之间的固有不一致性,往往导致性能的显著下降。面对这种不一致性时,最近的一些工作依赖于特定模态的监督微调,从而产生文字生成和图片生成两个不同的模型权重。这种做法违背了统一视觉理解与生成的初衷。为了解决这些难题,作者提出了一种创新的多模态生成模型——TextHarmony。

二、关键问题****

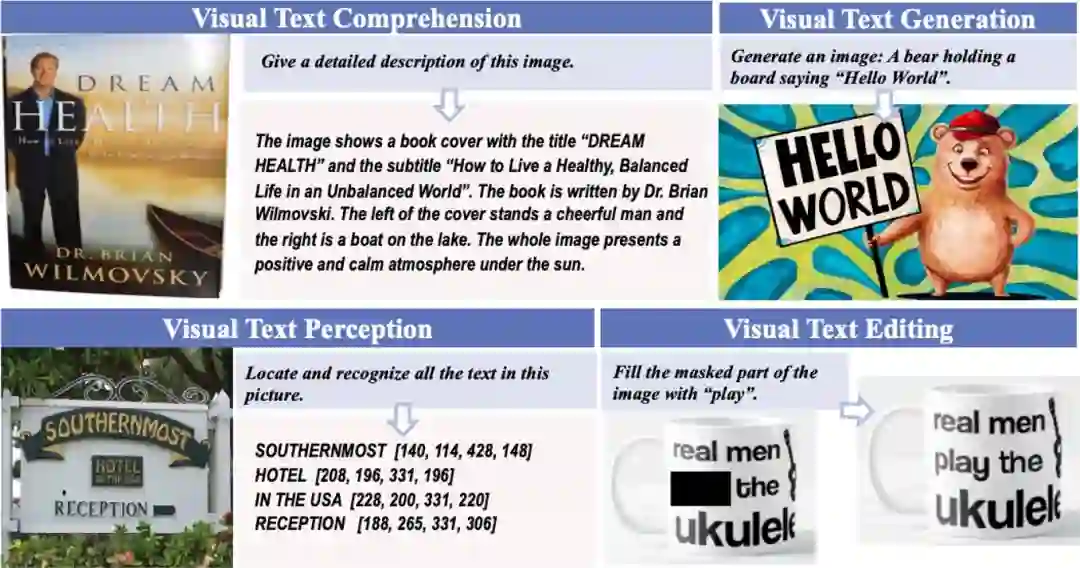

TextHarmony的核心贡献在于其能够统一视觉文本的理解和生成。在以往的研究中,理解与生成任务往往由不同的模型分别处理。例如,一些模型专注于从图像中检测和识别文字,而另一些模型则致力于根据文字描述生成、编辑图像。TextHarmony通过整合这两大类生成模型,使得模型能够同时进行视觉文字理解和视觉文字生成,从而统一了OCR领域中的大部分任务。

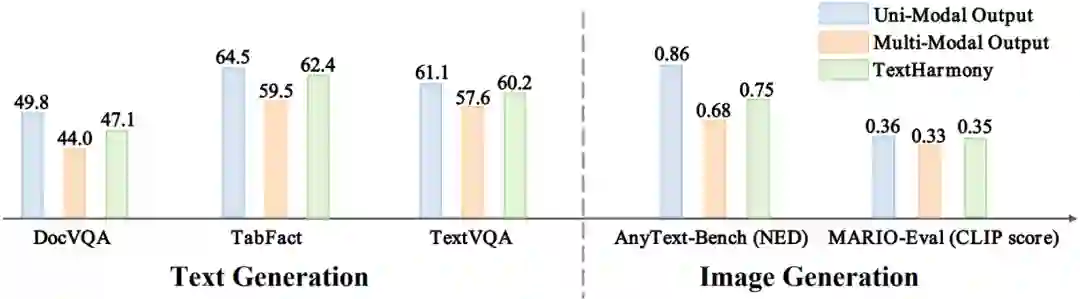

然而,研究人员发现,视觉理解和视觉生成之间具有较大的差异,直接将他们整合在一个模型中,会产生严重的模态不一致问题。具体地,多模态生成模型在文本生成(视觉感知、理解)和图像生成上,相比单模态生成模型(视觉理解模型或者图像生成模型)效果有比较明显的劣化。

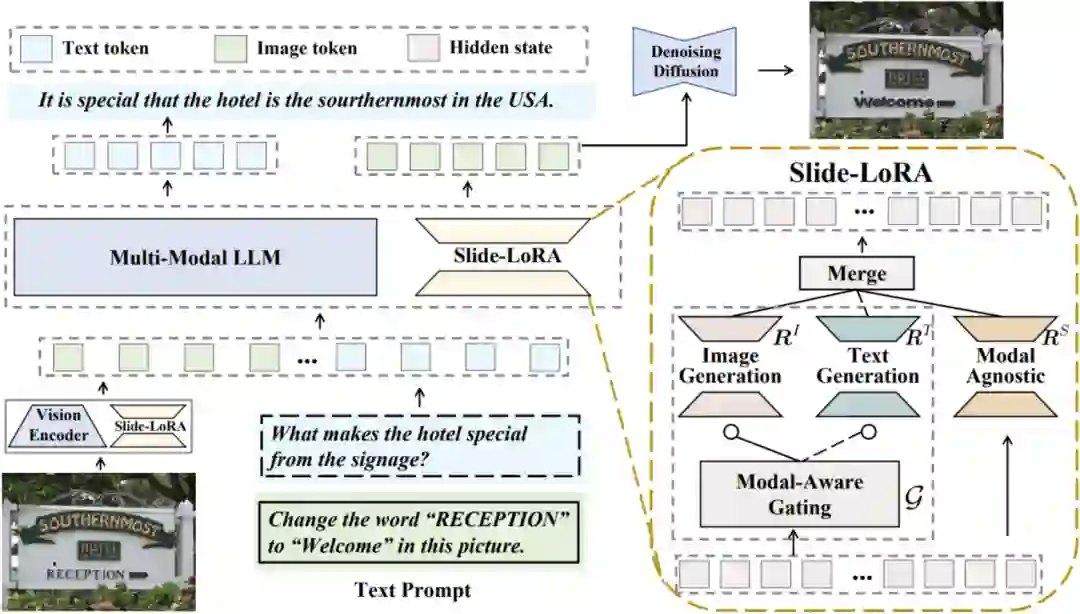

TextHarmony主要是基于 ViT+MLLM+Diffusion Model 的结构,其中ViT负责将图像压缩为视觉Token序列。MLLM的输入是视觉Token与文本Token的交叉序列,其输出Token分为两种:(1)文本Token将会被送入一个文本解码器,解码为文本输出;(2)视觉token将会和文本Token拼接,一起作为Diffusion Model的Condition(条件),引导Diffusion Model生成目标图像。通过结合多模态大语言模型和扩散模型,TextHarmony实现了多模态内容的理解与生成。

为了缓解训练过程中的模态不一致问题,研究者提出Slide-LoRA,通过动态聚合模态特定的和模态无关的LoRA(Low-Rank Adaptation)专家,来实现在单一模型中部分解耦图像和文本的生成空间。具体地,Slide-LoRA主要由一个动态门控网络和三个低秩分解模块组成。其中,模态特定LoRA专家专门处理与特定模态(视觉或语言)相关的生成任务,使得模型能够在各自的空间中更有效地学习和生成,而模态无关的LoRA专家处理与两种模态都相关的通用特征,增强了模型对跨模态共享知识的学习。动态门控网络根据输入的文本和图像特征,动态决定在生成过程中使用哪些模态特定的专家和模态无关的专家,从而实现对不同模态生成任务的适应。 TextHarmony的训练分为两阶段,一阶段使用 MARIO-LAION 和 DocStruct4M 等图文对来预训练模型的对齐模块(Perceiver Resampler)和图像解码器,使得模型具备初步的文本生成与图像生成能力。二阶段使用视觉文本的生成、编辑、理解、感知四个类别的数据来做统一微调,这个阶段ViT、对齐模块、图像解码器和Slide-LoRA都被放开,从而学习到统一的多模态理解与生成能力。 四、主要实验及可视化****

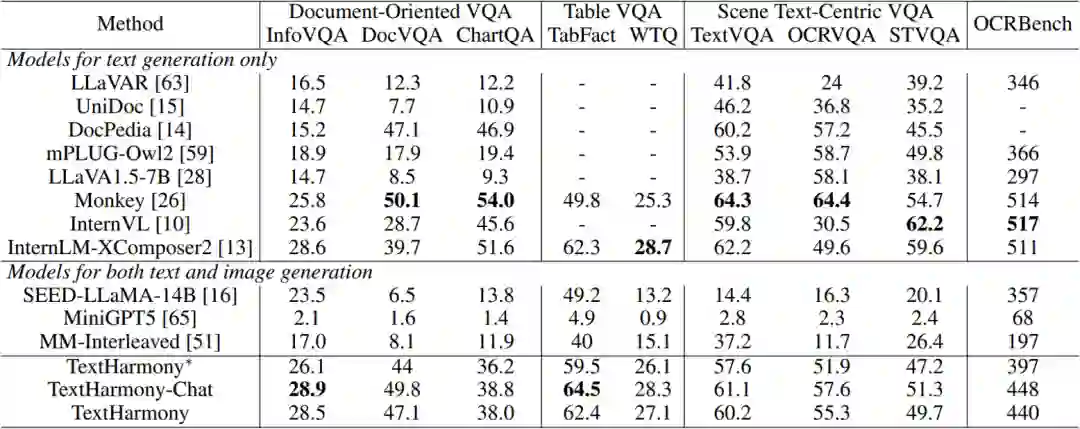

研究者在视觉文本场景对TextHarmony做了四个方面的对比实验:理解、感知、生成与编辑。 视觉文本理解:TextHarmony大幅度超过了多模态生成模型,并且接近Monkey等文字理解专家模型。

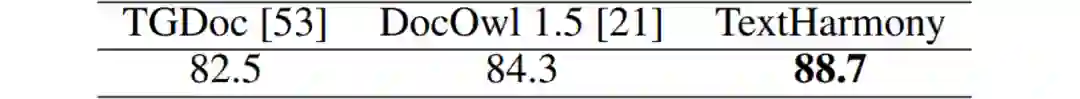

视觉文本感知:TextHarmony在OCR定位任务上超过了TGDoc、DocOwl1.5等模型。

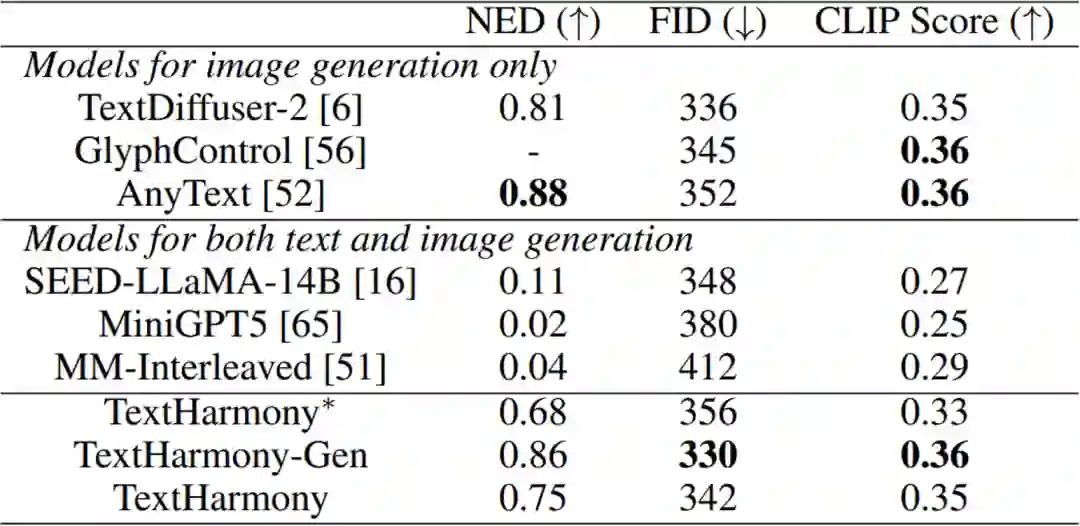

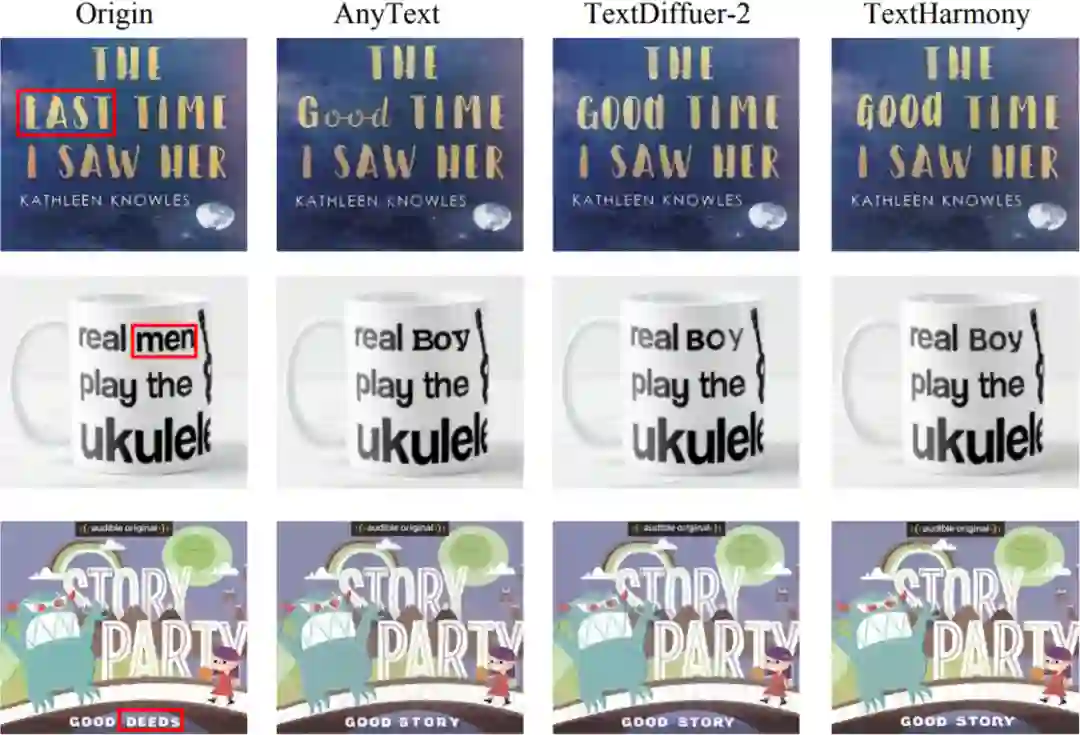

视觉文本编辑与生成:TextHarmony大幅度超过了所有的多模态理解模型,并且接近TextDiffuser2等专家模型。

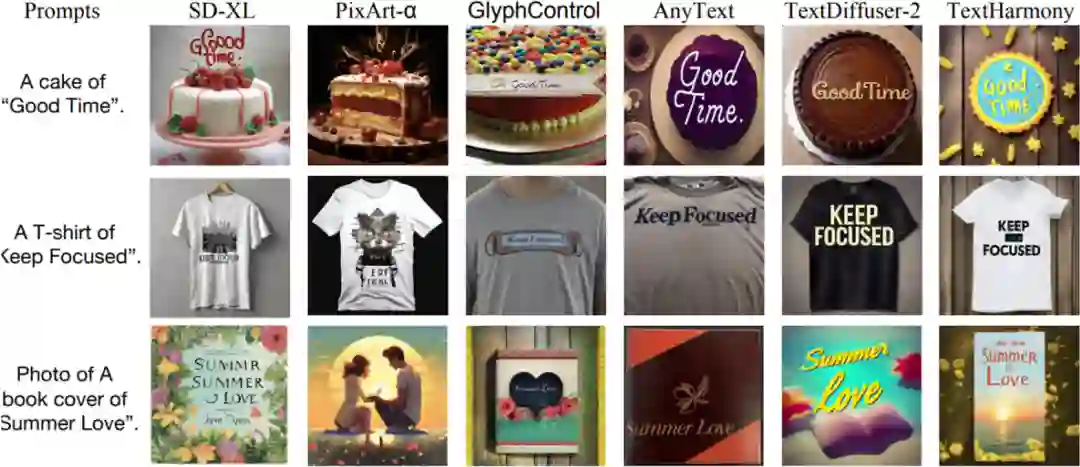

文字生成效果对比

文字编辑效果对比

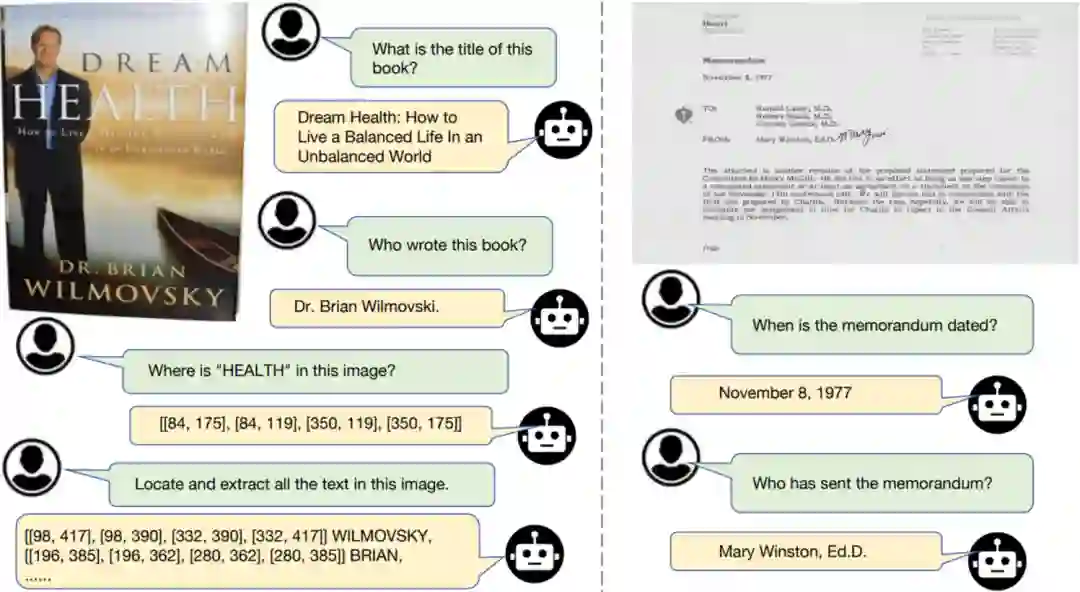

文字图像感知与理解可视化

五、总结****

TextHarmony是首个OCR领域的多模态生成模型,统一了视觉文本理解和生成任务。针对多模态生成模型的模态不一致问题,研究者提出Slide-LoRA模块,在单一模型中实现了视觉与语言模态的和谐统一。TextHarmony展现出了优秀的视觉文字感知、理解、生成和编辑能力,为依赖于视觉文本理解和生成的复杂交互任务提供了革命性的前景。 六、相关资源****

论文链接: https://arxiv.org/abs/2407.16364 代码开源: https://github.com/bytedance/TextHarmony(即将开源)

原文作者:Zhen Zhao, Jingqun Tang, Binghong Wu, Chunhui Lin, Shu Wei, Hao Liu, Xin Tan, Zhizhong Zhang, Can Huang, Yuan Xie