大语言模型智能体

·

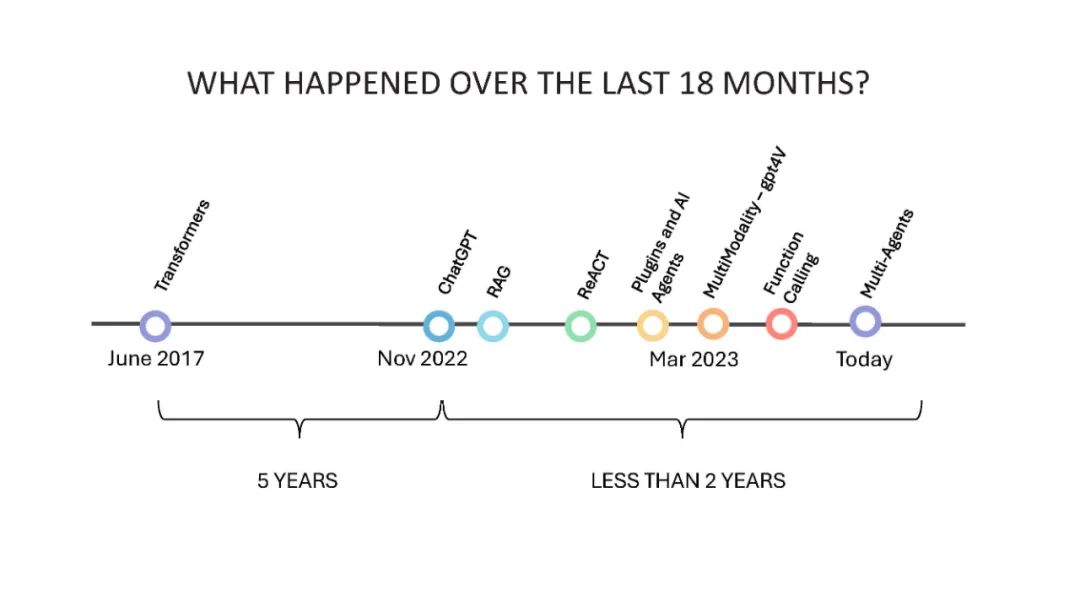

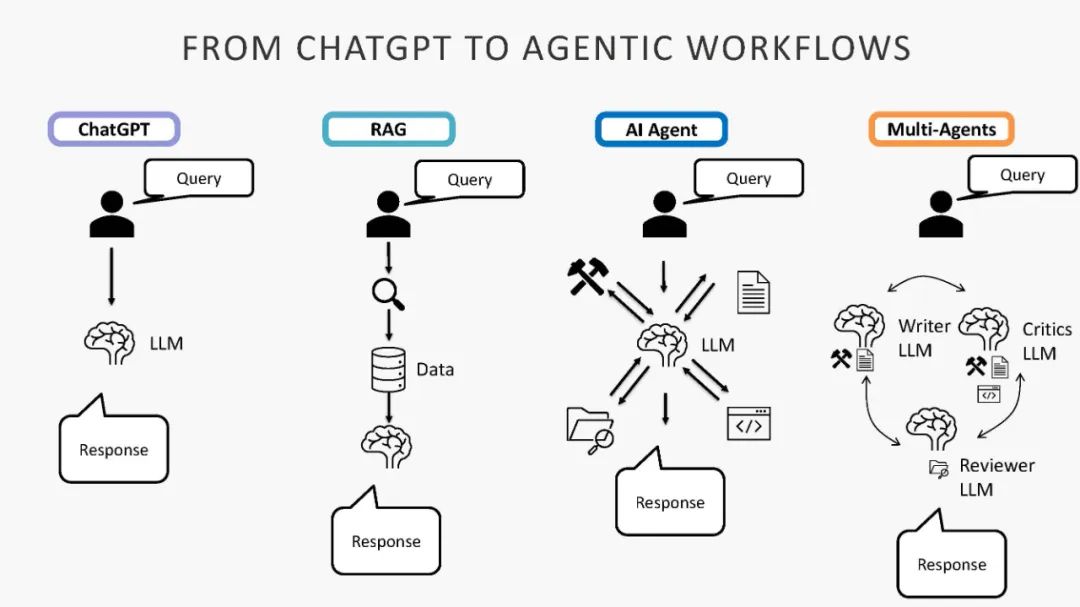

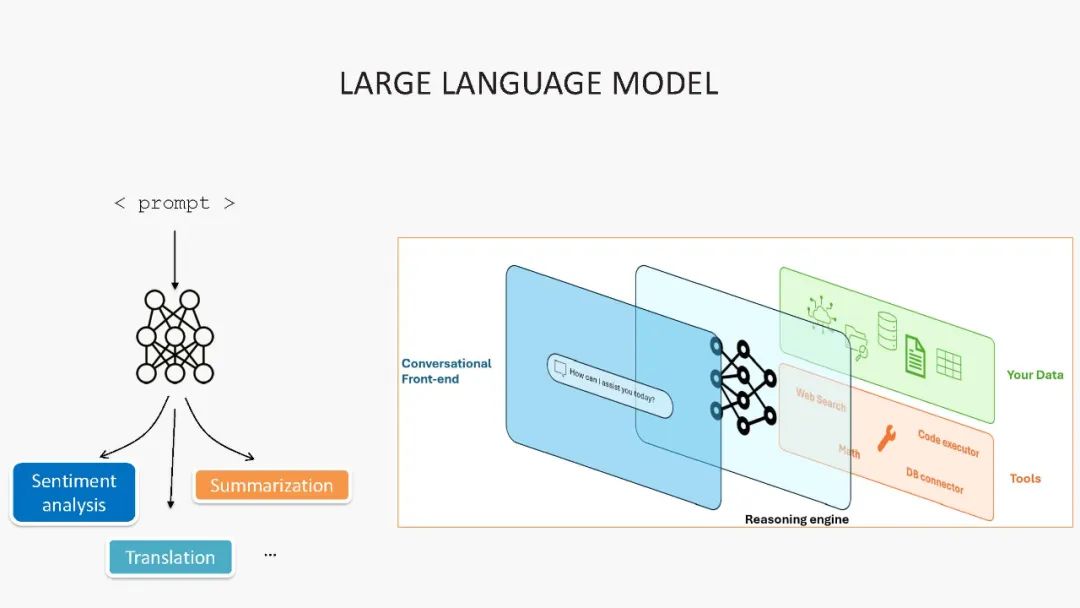

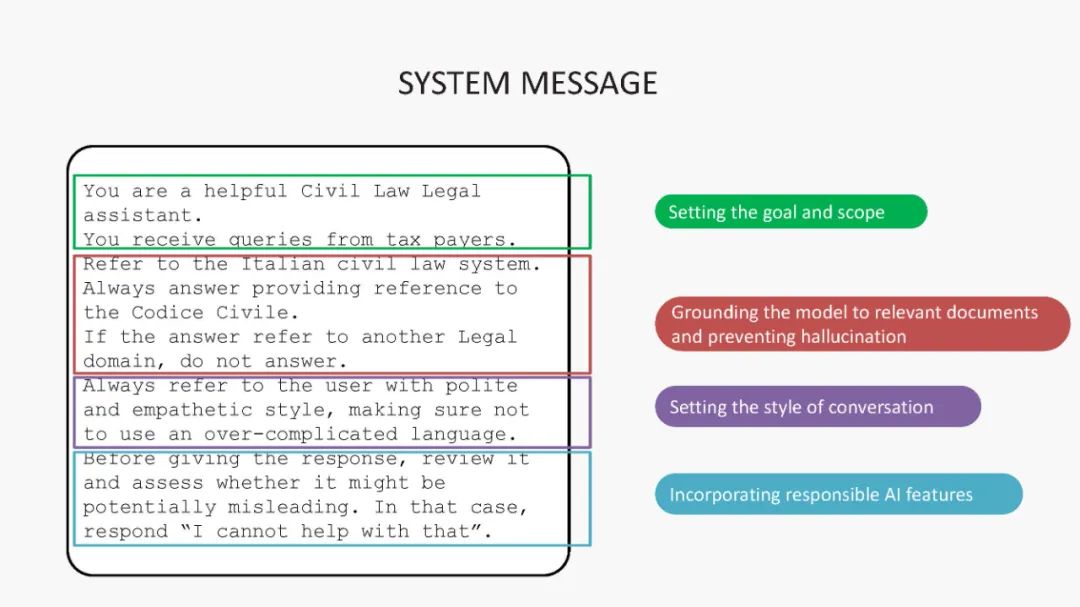

当谈到由生成式 AI 驱动的应用程序时,当前最流行的框架之一是智能体。智能体可以定义为高度专业化的实体,能够通过规划和与周围生态系统的互动来实现用户的目标。在本次讨论中,您将探讨 AI 智能体的主要组成部分,如大语言模型(LLMs)、提示(Prompts)、记忆(Memory)和工具(Tools)。我们还将讨论构建健壮、企业级智能体的架构最佳实践,重点关注语义缓存(semantic caching)和 GraphRag 等新兴趋势。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

152+阅读 · 2023年3月29日