摘要—近年来,多模态理解模型与图像生成模型均取得了显著进展。尽管各自取得了成功,但这两个领域的发展相对独立,形成了各自不同的架构范式:多模态理解领域主要采用自回归架构,而扩散模型已成为图像生成的核心技术。近年来,越来越多的研究开始探索将这两个任务融合到统一框架中的可能性。GPT-4o 的新能力正是这种趋势的体现,显示出统一建模的巨大潜力。然而,这两个领域在架构上的差异带来了重大挑战。为了全面梳理当前在统一建模方向上的研究进展,我们开展了一项系统综述,旨在为未来研究提供指导。首先,我们介绍了多模态理解与文本到图像生成模型的基础概念与最新进展。接着,我们对现有的统一模型进行了分类综述,归纳为三种主要的架构范式:基于扩散的模型、基于自回归的模型,以及融合了自回归与扩散机制的混合方法。对于每一类模型,我们分析了其结构设计及相关工作的创新点。此外,我们整理了适用于统一模型的公开数据集与评测基准,为后续研究提供资源支持。最后,我们讨论了该新兴领域面临的关键挑战,包括符号化策略、跨模态注意力机制及数据问题。由于该领域仍处于早期阶段,我们预计将迅速发展,并计划定期更新本综述。我们的目标是激发更多研究灵感,并为研究社区提供有价值的参考。本文所引用的文献将很快在 GitHub 上公开。

关键词—统一多模态模型,多模态理解,图像生成,自回归模型,扩散模型

1 引言

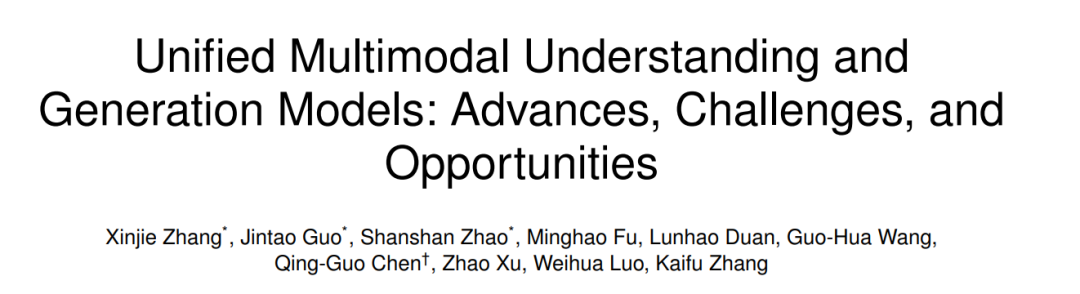

近年来,大语言模型(LLMs)的快速发展(如 LLaMa [1], [2],盘古 [3], [4],Qwen [5], [6],以及 GPT [7])正在彻底变革人工智能领域。这些模型在规模和能力上持续扩展,实现了在多个应用场景中的突破性进展。与此同时,LLMs 正在向多模态领域拓展,催生了诸如 LLaVa [8]、Qwen-VL [9], [10]、InternVL [11]、Ovis [12] 和 GPT-4 [13] 等强大的多模态理解模型。这些模型的能力已从简单的图像描述扩展到能够基于用户指令执行复杂推理任务。 另一方面,图像生成技术也在迅速发展,诸如 SD 系列 [14], [15] 和 FLUX [16] 的模型如今能够生成高度符合用户提示的高质量图像。在架构范式上,大语言模型和多模态理解模型普遍采用基于自回归(autoregressive)的生成方式 [17],这类模型通常采用纯解码器结构,并通过下一个 token 的预测来生成文本序列。相比之下,文本生成图像的领域则沿着另一条路径演进:早期以生成对抗网络(GANs)[18] 为主,近年来逐渐被基于扩散的模型 [19] 所取代,这些模型通常结合 UNet [14] 和 DiT [20], [21] 等架构,以及 CLIP [22] 和 T5 [23] 等先进文本编码器。尽管也有研究尝试将 LLM 风格的架构应用于图像生成任务 [24], [25], [26],但在当前的性能表现上,基于扩散的模型仍是主流。 尽管自回归模型在图像生成质量上落后于扩散方法,但它们与 LLMs 架构上的一致性,使其在构建统一的多模态系统方面具有天然优势。一个能够同时理解与生成多模态内容的统一模型具有巨大的潜力:它可以根据复杂指令生成图像,推理视觉信息,并通过生成的内容展示多模态分析结果。GPT-4o 于 2025 年 3 月发布的增强能力 [27] 更进一步凸显了这一潜力,引发了研究界对统一建模的广泛兴趣。 然而,设计这样的统一框架面临诸多挑战。这需要将自回归模型在推理和文本生成方面的优势,与扩散模型在高质量图像合成方面的能力进行有效融合。其中一个核心问题是如何为自回归生成过程有效地进行图像 token 化。一些方法 [28], [29], [30] 借鉴了扩散模型中常用的 VAE [31] 或 VQ-GAN [32],或其变体;另一些则采用了语义编码器,如 EVA-CLIP [36] 和 OpenAI-CLIP [22] [33], [34], [35]。此外,虽然离散 token 是自回归模型处理文本的标准表示方式,但一些新兴研究 [25] 提出,对于图像内容,连续表示可能更为合适。除了 token 化策略之外,结合并行扩散过程与顺序自回归生成机制的混合架构 [37], [38], [39],也为实现统一建模提供了另一种有前景的思路。因此,无论是图像 token 化技术还是架构设计,目前都仍处于初步探索阶段。 为了全面概述当前统一多模态模型的发展现状(如图1所示),并为未来研究提供支持,我们在本文中开展了系统性的综述。我们首先介绍多模态理解与图像生成的基础概念与最新进展,涵盖自回归和扩散两种范式。随后,我们对已有的统一模型进行分类综述,分为三大类:基于扩散的、基于自回归的,以及融合两者机制的混合方法。在自回归和混合方法两类中,我们进一步根据图像 token 化策略对模型进行细分,反映该领域方法的多样性。 除架构之外,我们还整理了适用于训练与评估统一多模态模型的数据集和基准,涵盖多模态理解、文本生成图像、图像编辑等任务,为未来研究提供资源支持。最后,我们讨论该新兴领域面临的关键挑战,包括高效的 token 化策略、数据构建、模型评估等。这些问题的解决对于推动统一多模态模型的能力提升与规模化应用至关重要。 目前,已有多篇优秀综述聚焦于大语言模型 [40], [41]、多模态理解 [42], [43], [44] 以及图像生成 [45], [46]。而本工作专注于理解与生成任务的融合建模方向。我们鼓励读者参考这些补充性综述,以获取更广阔的视野。我们的目标是激发该快速发展领域的进一步研究,并为研究社区提供有价值的参考资料。本文所涉及的引用、数据集与基准将很快在 GitHub 上发布,并将持续更新以反映最新进展。

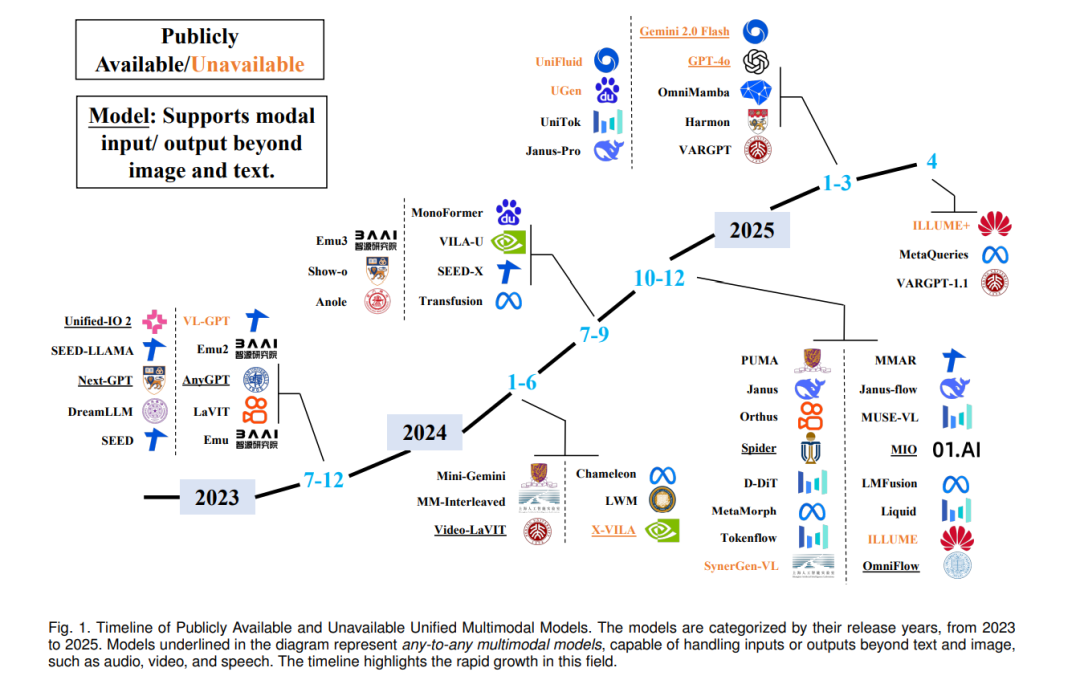

2.1 多模态理解模型

多模态理解模型指的是基于大语言模型(LLMs)的架构,能够处理多模态输入,执行推理任务,并生成相应输出的模型 [47]。这类模型将 LLM 在文本生成与推理方面的能力扩展至更广泛的信息模态,实现了丰富的语义理解 [42], [48]。现有方法的主要研究集中于视觉-语言理解(Vision-Language Understanding, VLU),即融合视觉(如图像与视频)与文本输入,以支持对空间关系、对象、场景和抽象概念等更全面的理解 [49], [50], [51]。图 2 展示了多模态理解模型的典型架构。 这类模型在混合输入空间中运行,其中文本数据以离散形式表示,而视觉信号则通过连续表示进行编码 [52]。与传统 LLM 类似,其输出以离散 token 的形式生成,通常采用基于分类的语言建模方式以及特定任务的解码策略 [8], [53]。 早期的 VLU 模型主要采用双编码器架构(dual-encoder),将图像与文本分别编码后,在对齐的潜在表示空间中联合进行推理,如 CLIP [22]、ViLBERT [54]、VisualBERT [55] 与 UNITER [56]。尽管这些先驱模型奠定了多模态推理的基础原理,但它们高度依赖区域级的视觉预处理以及独立编码器,限制了模型的可扩展性与通用性。 随着强大 LLM 的出现,VLU 模型逐渐过渡到纯解码器架构,采用冻结或仅轻微微调的语言模型主干。这些方法通常通过结构化的连接器将图像嵌入投射到语言模型的 token 空间中,如图 2 所示。例如,MiniGPT-4 [57] 使用单层可学习的线性映射,将 CLIP 提取的图像嵌入映射到 Vicuna [58] 的 token 空间;BLIP-2 [53] 提出了查询变换器(querying transformer),用于连接冻结的视觉编码器与冻结的 LLM(如 Flan-T5 [59] 或 Vicuna),在大幅减少可训练参数的同时,实现高效的视觉-语言对齐;Flamingo [60] 则引入门控跨模态注意力层(gated cross-attention),连接预训练的视觉编码器与冻结的 Chinchilla [61] 解码器。 近年来,VLU 的发展趋势正朝向更通用的多模态理解演进。GPT-4V [62] 将 GPT-4 框架扩展至图像输入分析,展示了出色的视觉推理、图像描述与多模态对话能力,尽管其具体机制仍为专有。Gemini [63] 构建在纯解码器架构之上,支持图像、视频与音频等多种模态,其中 Ultra 版本在多模态推理任务中创下新基准。Qwen 系列展示了可扩展的多模态设计:Qwen-VL [5] 引入视觉感知模块与语义对齐模块,Qwen2-VL [9] 则进一步加入动态分辨率处理机制与 M-RoPE,用于适应多样输入。LLaVA-1.5 [64] 与 LLaVA-Next [65] 均结合了 CLIP 视觉编码器与 Vicuna 风格的 LLM,在视觉问答(VQA)和指令跟随任务中取得优异性能。 InternVL 系列 [11], [66], [67] 探索了统一的多模态预训练策略,采用文本与图像的联合学习机制,在多项视觉-语言任务中显著提升表现。Ovis [12] 则通过可学习的视觉嵌入查找表引入结构化嵌入对齐机制,使视觉嵌入在结构上模拟文本 token。近期也有模型探索可扩展、统一的多模态架构,例如 DeepSeek-VL2 [68] 采用专家混合架构(Mixture-of-Experts, MoE)以增强跨模态推理能力。 总体而言,这些模型展现出向指令调优(instruction-tuned)和 token 为中心(token-centric)架构的明确转变,具备处理多样多模态任务的统一性与可扩展性。