摘要—人工智能(AI)的快速发展已彻底改变了众多领域,尤其是大规模语言模型(LLMs)和计算机视觉(CV)系统,分别推动了自然语言理解和视觉处理的进步。这些技术的融合催生了多模态人工智能,能够实现跨文本、视觉、音频和视频等模态的更丰富的跨模态理解。尤其是多模态大规模语言模型(MLLMs)作为一种强大的框架,展现了在图像-文本生成、视觉问答和跨模态检索等任务中的卓越能力。尽管取得了这些进展,MLLMs的复杂性和规模也带来了可解释性和可解释性方面的重大挑战,而这些挑战对于在高风险应用中建立透明性、可信度和可靠性至关重要。本文提供了关于MLLMs可解释性和可解释性的全面综述,提出了一个新颖的框架,将现有研究从以下三个角度进行分类:(I) 数据,(II) 模型,(III) 训练与推理。我们系统地分析了从词汇级到嵌入级表示的可解释性,评估了与架构分析和设计相关的方法,并探讨了增强透明度的训练和推理策略。通过比较各种方法论,我们识别了它们的优缺点,并提出了未来研究方向,以解决多模态可解释性中尚未解决的挑战。本文综述为推动MLLMs的可解释性和透明度提供了基础资源,旨在引导研究人员和实践者开发更加负责任和稳健的多模态人工智能系统。

关键词—多模态大规模语言模型、可解释性、可解释性、综述

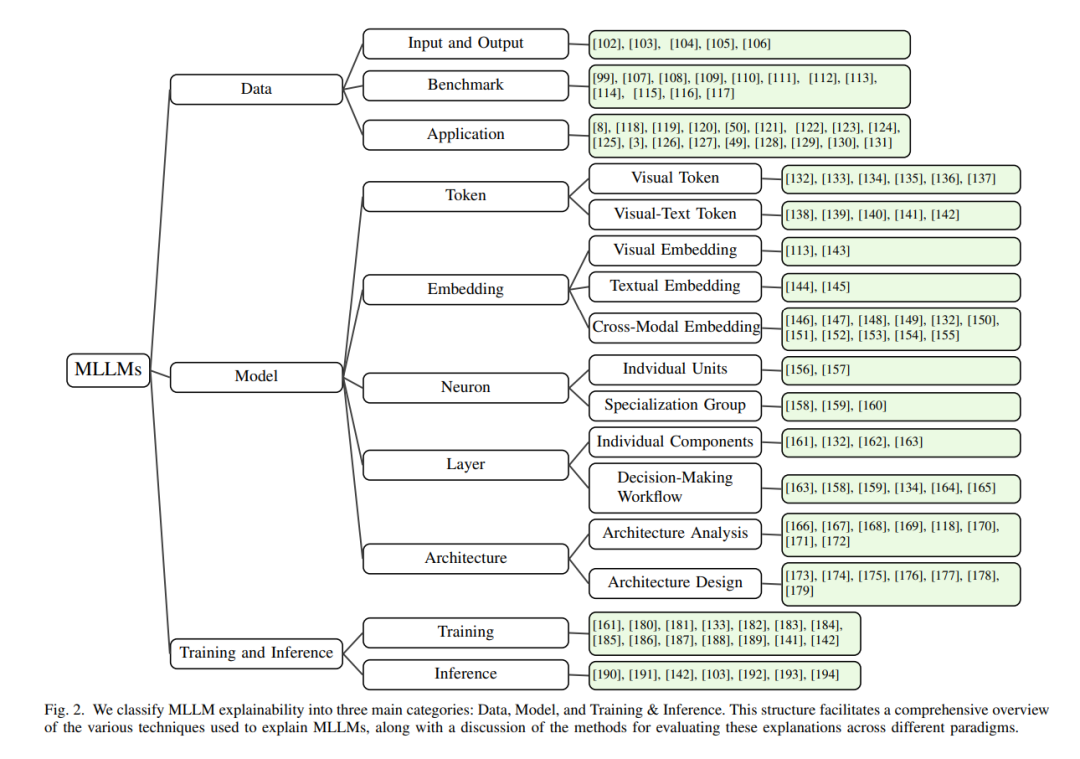

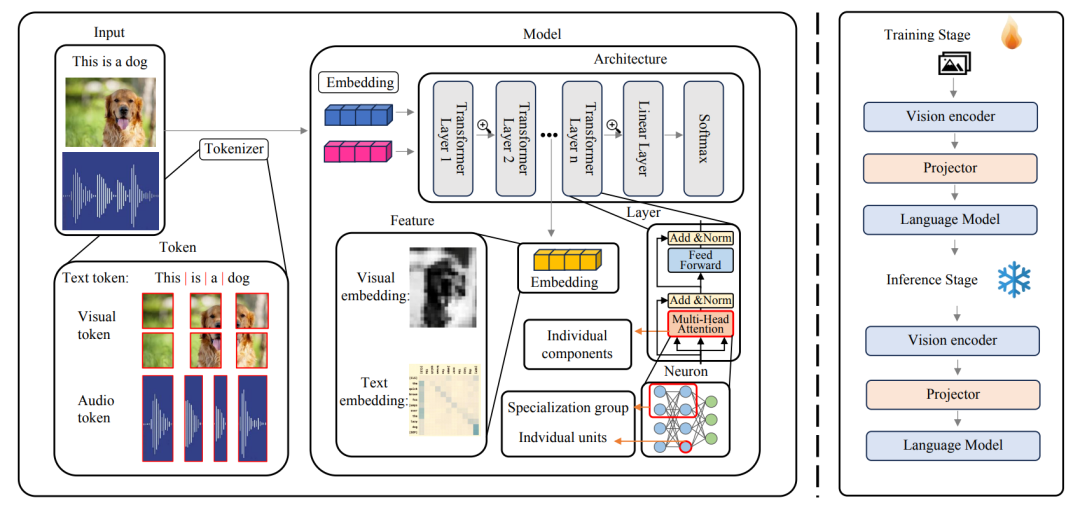

引言 人工智能(AI)的快速发展已经显著改变了众多领域。最近,AI领域最具影响力的进展之一是大规模语言模型(LLMs)的发展,这些模型在文本生成、翻译和对话式AI等一系列自然语言任务中表现出卓越的语言理解和生成能力[1]。同样,计算机视觉(CV)的进展使得系统能够有效处理和解释复杂的视觉数据,推动了物体检测、动作识别和语义分割等任务的高精度实现[2]。最近,这些技术的融合激发了对多模态人工智能的兴趣,它旨在整合文本、视觉、音频和视频等多种模态,实现更加丰富和全面的多模态理解[3, 4, 5, 6, 7, 8, 9, 10, 11]。多模态大规模语言模型(MLLMs)在深度学习技术的重大进展推动下,经历了快速的发展[12, 13, 14, 15, 16, 17]。通过整合多种数据源,MLLMs在一系列多模态任务中展示了先进的理解、推理和生成能力,包括图像-文本生成[18, 19, 20]、视觉问答[21, 22, 23, 24, 25, 26, 27, 28]、跨模态检索[29, 30, 31]、视频理解[32, 33, 34, 35, 36, 37, 38]。因此,MLLMs在多个领域找到了广泛的应用[39, 40, 41],包括自然语言处理(NLP)[42, 43]、计算机视觉(CV)[44, 45]、视频[15, 46, 47]、自动驾驶[3, 48, 49]、医学[50, 51, 52]和机器人技术[53, 54, 55, 56, 57, 58]。然而,随着MLLMs的复杂性和规模的增长,出现了一个关键挑战:解码MLLMs的决策过程[6, 59, 60]。 可解释人工智能(XAI)领域已经成为使复杂AI系统的决策过程更加透明和易于理解的关键[61, 62, 63]。可解释性和可解释性被定义为能够以人类可理解的方式解释或呈现[64, 65]。尽管在单模态的可解释性和可解释性方面已经取得了显著进展,例如在卷积神经网络(CNN)[66, 67]和变换器(transformers)[68]在图像上的应用,以及LLMs[69]在文本中的应用,但多模态领域存在独特的挑战,如不同模态的对齐和分解。此外,MLLMs的可解释性和可解释性对于确保透明性和可信度至关重要,特别是在人工智能决策对人类产生重大影响的高风险应用中,这涉及如何在模型中结合不同的数据类型,以及它们的相互作用如何影响输出。根据近期的研究[64, 70, 71],本文定义了在MLLMs中,可解释性指的是那些本质上易于理解的内部结构,使得输入如何转化为输出能够直观地理解。另一方面,MLLMs的可解释性涉及提供关于模型决策背后的外部分析的后置技术。 本文提出了一种新的视角来分类MLLMs的可解释性和可解释性,通过整合数据、模型、训练与推理的视角。正如图1所示,我们从三个角度考察MLLMs的可解释性和可解释性:数据(第III节)、模型(第IV节)、训练与推理(第V节)。继数据驱动的可解释性研究[72, 73, 74, 75]之后,我们探讨了数据视角(第III节),分析输入和输出数据如何归因于模型的决策。我们还分析了基准和应用,以评估各种任务中的可信度和可靠性,从而确保其在现实场景中的鲁棒性和适用性[76, 77]。在模型的可解释性和可解释性方面[78, 79, 80, 81, 82, 83, 84],从模型视角(第IV节),我们深入分析了从词汇级、嵌入级、神经元级、层级到架构级的各个层面。在词汇级[85, 86, 87, 88, 89],我们研究了单个词汇对模型输出的影响,并探索了增强可解释性的方法。在嵌入级[90],我们评估了多模态嵌入如何影响MLLMs的性能和可解释性,提供了对底层表示机制的更深刻理解。对于神经元级[91, 92, 93],我们分析了单个单元和特定神经元组的作用,以理解它们对整体模型行为的贡献。在层级级[67, 78, 94],我们研究了不同层次如何影响模型内的决策过程。在架构方面,我们区分了架构分析和架构设计[95, 96, 97, 98]的可解释性方法,强调了促进透明性和更好理解模型操作的策略。 此外,我们还探讨了增强模型透明性和可解释性的训练与推理策略(第V节)。在训练阶段[79],我们总结了各种训练机制和权重调整如何影响MLLMs的可解释性。我们讨论了旨在改善对齐、减少幻觉并促进核心知识和泛化能力获取的技术。在推理阶段,我们研究了如何在不需要重新训练的情况下,缓解诸如幻觉等问题,包括过度信任惩罚机制和链式推理技术。 通过整合这些视角[3, 99, 100],我们的综述提供了对MLLMs可解释性和可解释性挑战与进展的全面理解。我们相信,这一全面分析将为致力于开发更透明、可靠和可信的多模态模型的研究人员和实践者提供宝贵的资源。本研究的主要贡献总结如下: * 我们首次提供了对现有多模态大规模语言模型(MLLMs)可解释性和可解释性的深入和全面回顾。 * 我们展示了当前多模态大规模语言模型可解释性和可解释性方法的结构化和比较分析,提出了一种新颖的分类方法,将这些方法组织为数据、模型、训练与推理视角。 * 我们突出显示了可能推动该领域发展的研究方向,为研究人员进一步发展MLLMs的可解释性和可解释性方法提供了有价值的指导。

II. 综述框架

A. 综述范围 近年来,多模态模型和可解释人工智能(XAI)取得了显著进展,许多研究探索了使这些复杂模型更加透明和可解释的方法[72, 73, 74]。为了将本综述的范围缩小到一个可管理的范围,我们聚焦于多模态大规模语言模型(MLLMs)的可解释性和可解释性。MLLMs的可解释性指的是那些本质上易于理解的内部结构,能够为输入如何被处理并转化为输出提供直观的洞察[78, 79]。可解释的MLLMs使研究人员和实践者能够深入理解这些跨模态的动态,澄清每个模态如何影响和塑造模型的决策过程[90]。可解释性涉及使用外部技术来阐明模型决策背后的原因,这在MLLMs中对于理解多模态间复杂的交互作用至关重要[95]。这种重点不仅增强了我们对多模态集成的理解,也回应了对复杂AI系统透明度日益增长的需求[79]。 在本综述中,我们集中探讨MLLMs中四个主要维度的可解释性和可解释性: * 数据可解释性 —— 探讨来自不同模态的输入数据如何预处理、对齐和表示,以支持跨模态的可解释性,以及如何应用因果归因方法来增强对模型决策的理解[72, 75]。 * 模型可解释性 —— 阐明多模态模型本身的结构和功能,提供关于神经元、层次和架构如何贡献于可解释性的洞察[67, 78, 79, 80, 85, 86, 87, 90, 91, 95]。 * 训练与推理可解释性 —— 理解MLLMs的训练和推理过程如何影响可解释性,这对于在学习阶段和实际应用中提升透明度至关重要。

为了保持焦点,我们将单一模态的可解释性方法排除在本综述的主要范围之外,如变换器(Transformer)的可解释性、卷积神经网络(CNN)的可解释性或LLMs的可解释性,仅作为简要的背景信息进行介绍。类似地,一些不涉及多模态交互独特挑战的通用可解释性方法也不在本综述的主要范围之内。相反,我们将重点放在那些专门设计用于解释和阐明多模态之间交互作用的方法和模型上。 B. 综述方法论 为了提供对MLLMs可解释性和可解释性的全面概述,我们进行了广泛的文献回顾,涵盖了机器学习、自然语言处理(NLP)、计算机视觉(CV)和多模态系统等领域的研究论文。我们重点审查了过去十年(2010–2024)间发表的论文,特别是研究这些领域中可解释性和可解释性的不断增长的文献。我们的研究方法包括几个关键步骤。首先,我们使用“多模态大模型”、“可解释性”和“可解释性”等关键词,在Google Scholar等数据库中搜索相关论文,具体细节见表I。为了进一步确保综述的完整性,我们还审查了关键论文的参考文献,并包括了对该领域具有影响力的早期工作。 在收集候选论文后,我们进行了多步骤的筛选过程。首先通过标题筛选潜在相关的论文,然后进行摘要筛查以确认相关性。如果标题和摘要不足以做出决策,我们会进一步查阅完整的文本。如图2所示,最终选择的文献涵盖了应用于MLLMs的各种可解释性和可解释性技术,包括输入输出分析、模型组件和训练动态等。

结论

本综述系统地探讨了多模态大规模语言模型(MLLMs)的可解释性和可解释性,强调了决策过程透明性的重要性。我们将可解释性方法分为三个主要领域——数据、模型和训练与推理——提供了一个结构化框架来组织研究并指导未来的研究工作。尽管已经取得了显著进展,但在可解释性方法和确保广泛适用性方面仍然存在挑战。未来的努力应着眼于填补这些空白,构建对MLLMs的统一理解,推动创新,使多模态系统变得更加可靠和可信。