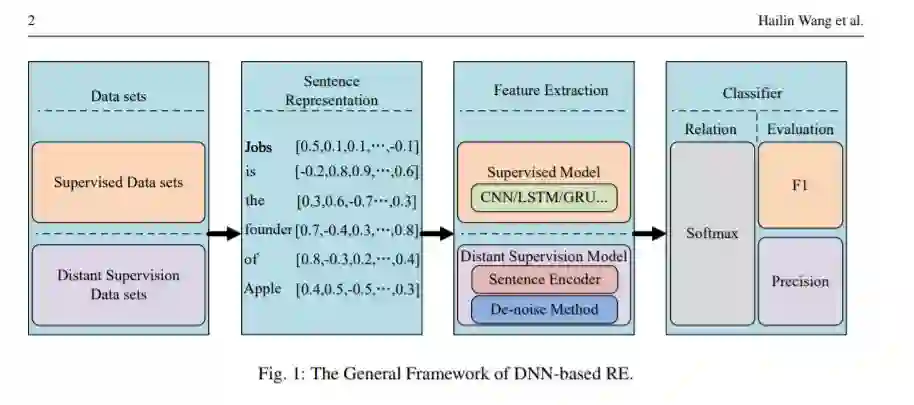

知识是理解世界的一种正式方式,为下一代人工智能(AI)提供人类水平的认知和智能。知识的表现形式之一是实体之间的结构关系。关系抽取(RE)是信息抽取的一个子任务,是自动获取这些重要知识的有效方法,在自然语言处理(NLP)中起着至关重要的作用。其目的是从自然语言文本中识别实体之间的语义关系。到目前为止,已有一些关于RE的研究,其中基于深度神经网络(DNNs)的技术已成为该研究的主流技术。其中,基于DNNs的监督式和远程监督是目前最流行、最可靠的两种关系提取方法。本文首先介绍了一些一般概念,然后从两个方面对关系提取中的DNNs进行了全面的概述:一是对标准关系提取系统进行改进的监督式,二是采用DNNs设计句子编码器和去噪方法的远程监督式。在此基础上,我们进一步介绍了一些新的研究方法,描述了一些最新的研究趋势,并讨论了未来可能的研究方向。

https://www.zhuanzhi.ai/paper/bce5fadda556d0501fd5b47127fc6c91

成为VIP会员查看完整内容