自编码表示学习 25页最新进展综述,90篇参考文献

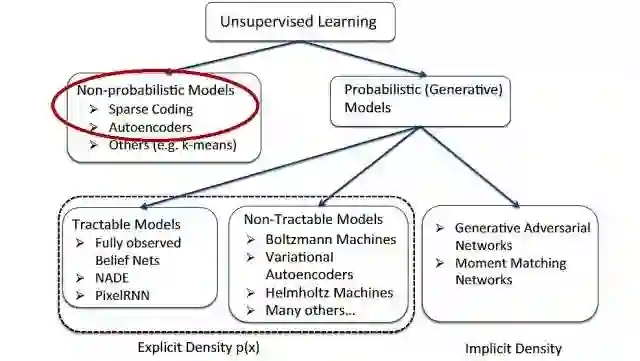

【导读】【无监督学习】(Unsupervised Learning)现在已经成为深度学习领域的热点。和「有监督学习」相比,这种方法的最大优势就在于其无须给系统进行明确的标注(label)也能够进行学习。而自编码器作为一种经典的无监督学习方法一直广受关注。 最近Goog Brain与苏黎世理工就带来了关于自编码表示学习的综述,详细介绍了从基本的自编码到最新的各种VAE变体的研究现状。

题目: Recent Advances in Autoencoder-Based Representation Learning

作者:Michael Tschannen, Olivier Bachem, Mario Lucic

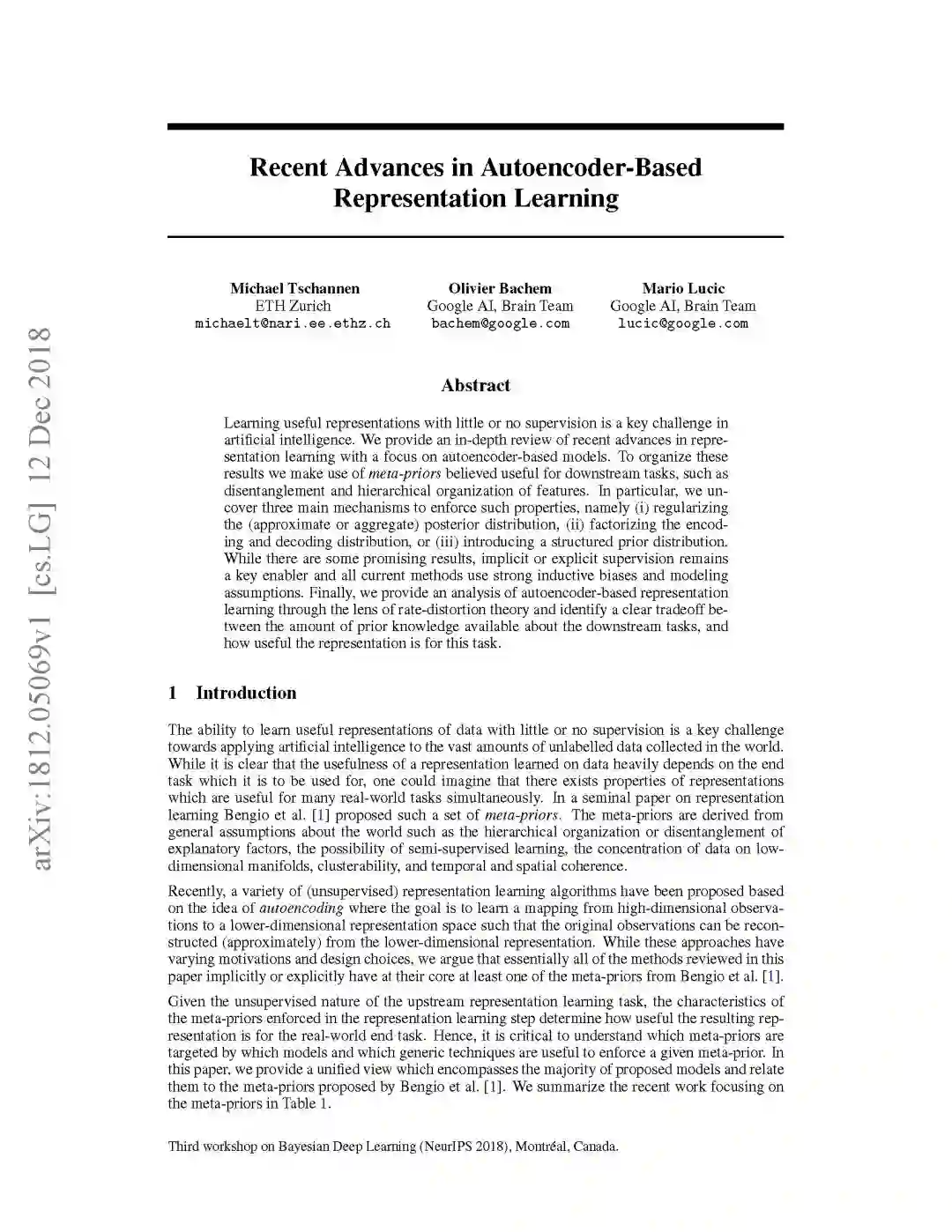

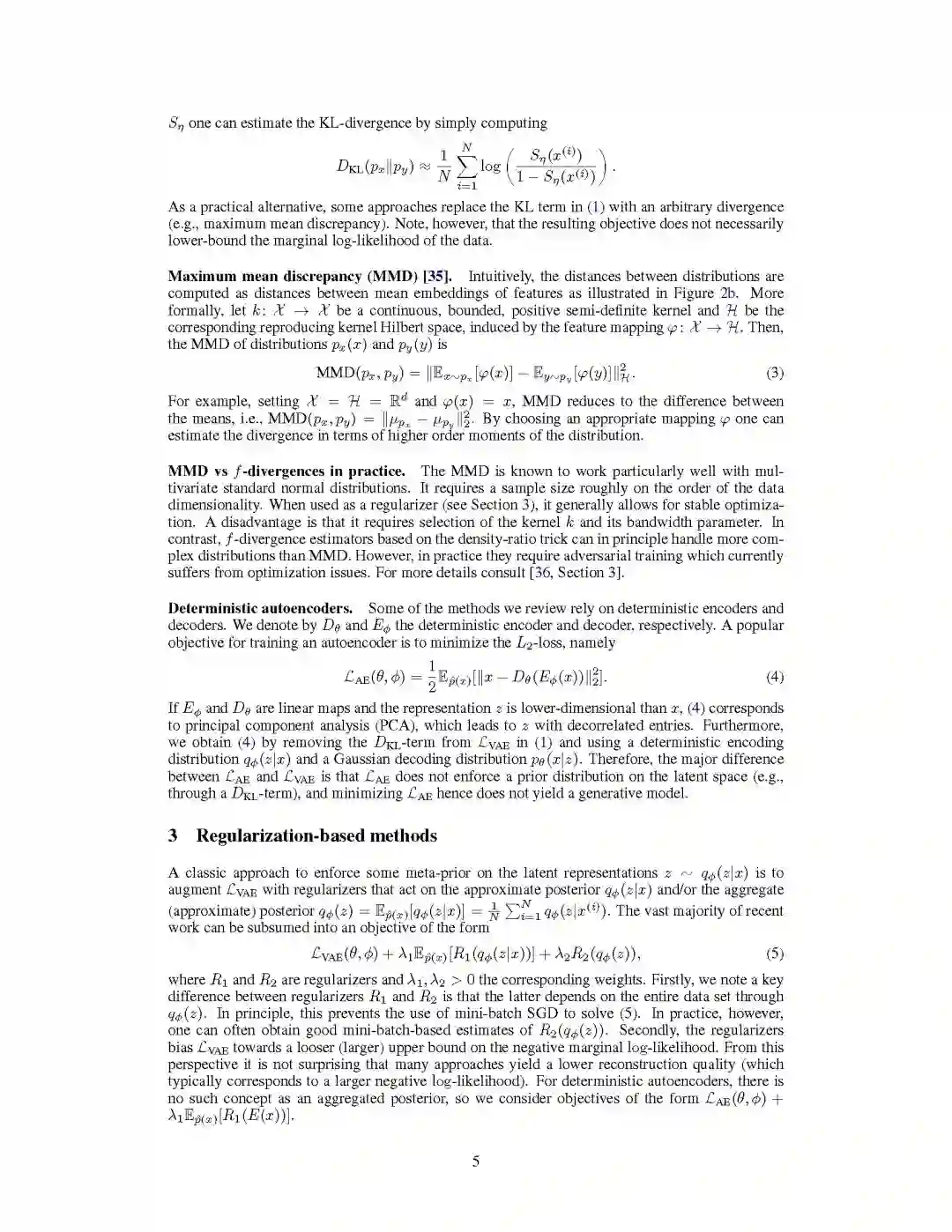

【摘要】在很少或者无监督的情况下学习有用的表示是人工智能的一个关键挑战。 我们对表示学习的最新进展进行了深入的回顾,重点是基于自编码的模型。为了组织这些,我们使用元先验(meta-priors),这些元先验被认为对下游任务有用,例如特征的分离和分层组织。 特别地,我们揭示了这些属性的三种主要机制,即(i)正则化(近似或聚合)后验分布,(ii)分解编解码分布, (iii)引入结构化的先验分布。虽然有一些有希望的结果,但隐性或显性监督仍然是一个关键推动因素,所有现有方法都使用强inductive biases和建模假设。最后,我们利用速率失真理论分析了基于自编码的表示学习。

参考链接:

https://arxiv.org/abs/1812.05069

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知)

后台回复“AERL2018” 就可以获取自编码表示学习综述的下载链接~

附教程内容

-END-

专 · 知

人工智能领域26个主题知识资料全集获取与加入专知人工智能服务群: 欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知