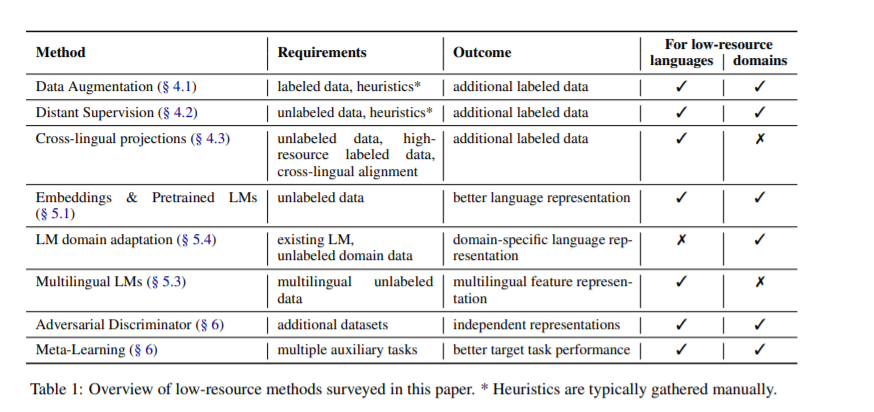

当前自然语言处理的发展为低资源语言和领域提供了挑战和机遇。众所周知,深度神经网络需要大量的训练数据,而这些数据在资源贫乏的情况下可能无法得到。然而,也有越来越多的工作来提高低资源环境下的性能。基于对神经模型的基本改变和目前流行的预训练和微调范式,我们概述了低资源自然语言处理的有前途的方法。在讨论了低资源场景的定义和数据可用性的不同维度之后,我们接着研究了在训练数据稀少时支持学习的方法。这包括创建附加标签数据的机制,如数据增强和远程监督,以及转移学习设置,以减少对目标监督的需要。调查结束时,简要地看了一下在非NLP机器学习社区中建议的方法,这些方法在资源少的情况下可能对NLP有益。

https://arxiv.org/abs/2010.12309

成为VIP会员查看完整内容