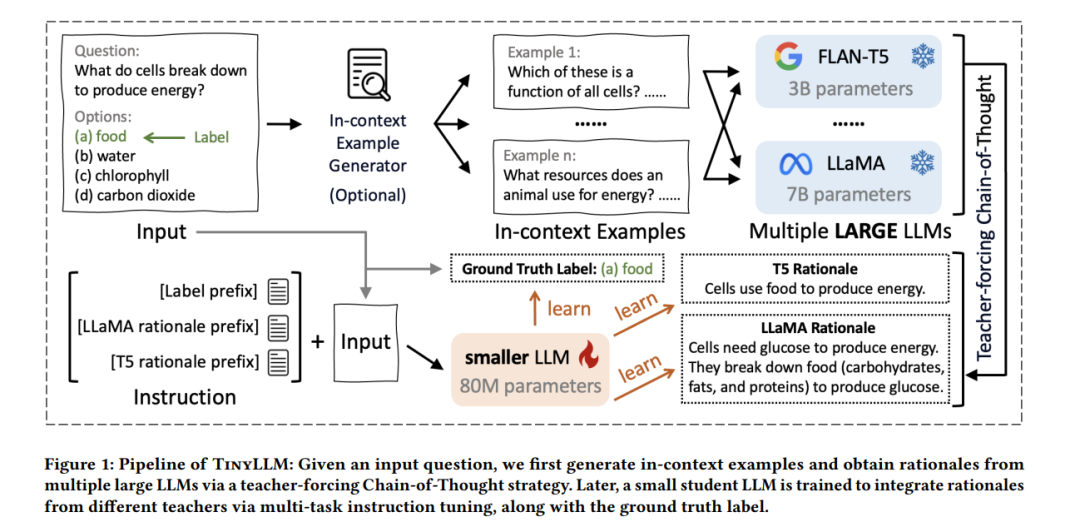

将推理能力从更强大的大型语言模型(LLMs)转移到较小模型一直具有很大的吸引力,因为较小的LLMs在部署时更加灵活且成本较低。在现有的解决方案中,知识蒸馏因其卓越的效率和泛化能力而脱颖而出。然而,现有的方法存在若干缺点,包括知识多样性有限和缺乏丰富的上下文信息。为了应对这些问题并促进紧凑语言模型的学习,我们提出了TinyLLM,一种新的知识蒸馏范式,用于从多个大型教师LLMs学习一个小型学生LLM。具体来说,我们鼓励学生LLM不仅生成正确的答案,还要理解这些答案背后的推理过程。鉴于不同的LLMs拥有多样的推理能力,我们引导学生模型从各种教师LLMs吸收知识。我们进一步引入了一个上下文示例生成器和一个教师引导的思维链策略,以确保推理过程准确并且在上下文中恰当。我们在六个数据集上的大量实验,涵盖了两个推理任务,证明了我们方法的优越性。结果表明,尽管模型规模较小,TinyLLM在性能上显著超越了大型教师LLMs。源代码可在以下网址获取:https://github.com/YikunHan42/TinyLLM。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日