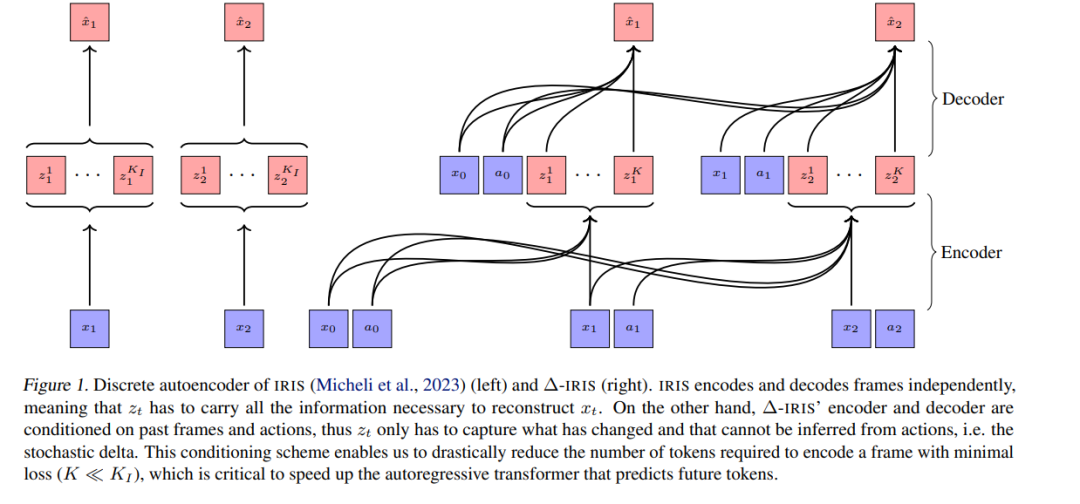

深度强化学习(RL)方法的扩展提出了一个显著的挑战。随着生成模型的发展,基于模型的RL成为一个有力的竞争者。最近在序列建模方面的进展带来了有效的基于Transformer的世界模型,尽管这些模型由于需要长序列的标记来准确模拟环境而导致计算量巨大。在这项工作中,我们提出了∆-IRIS,这是一种具有世界模型架构的新型智能体,该架构由一个离散自动编码器组成,该编码器对时间步之间的随机变化进行编码,以及一个自回归Transformer,该Transformer通过用连续标记总结当前世界状态来预测未来的变化。在Crafter基准测试中,∆-IRIS在多个帧预算中设立了新的状态标准,同时其训练速度比之前的基于注意力的方法快一个数量级。我们在https://github.com/vmicheli/delta-iris上发布了我们的代码和模型。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日