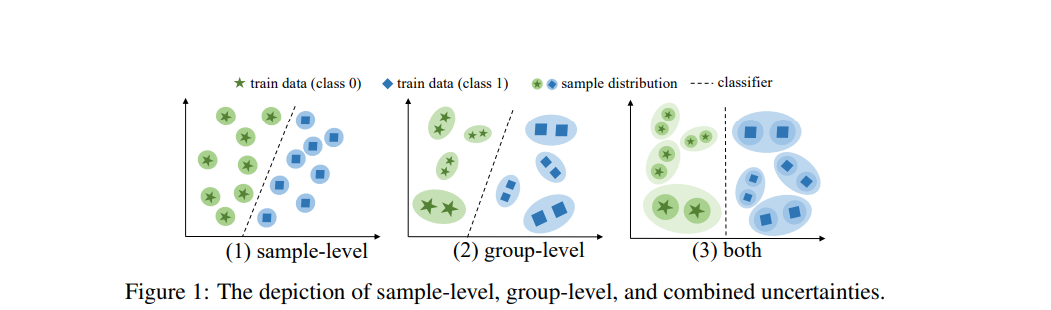

在机器学习中,分布外(Out-of-Distribution, OOD)泛化是一个快速发展的研究领域。其主要目标是增强机器学习模型在面对新的、未见过的、甚至是具有潜在对抗性的数据时的适应性和韧性,这些数据与模型的原始训练数据集存在显著差异。本文通过预训练的大型语言模型(LLMs)研究时间序列的OOD泛化。我们首先提出了一个用于时间序列OOD泛化的新颖三层学习框架,称为TTSO(Tri-level learning framework for Time Series OOD generalization),该框架同时考虑样本级和组级的不确定性。该框架为构建和分析OOD泛化问题提供了一种新的理论视角。此外,我们还进行了理论分析,以证明该方法的合理性。随后,我们开发了一种分层定位算法,以适应这一三层优化问题,并从理论上证明了所提出算法的收敛性保证。我们的分析还揭示了获得ϵ-驻点的迭代复杂度被限制在O(1/ϵ²)之内。基于真实世界数据集的大量实验已被开展,以阐明所提方法的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日