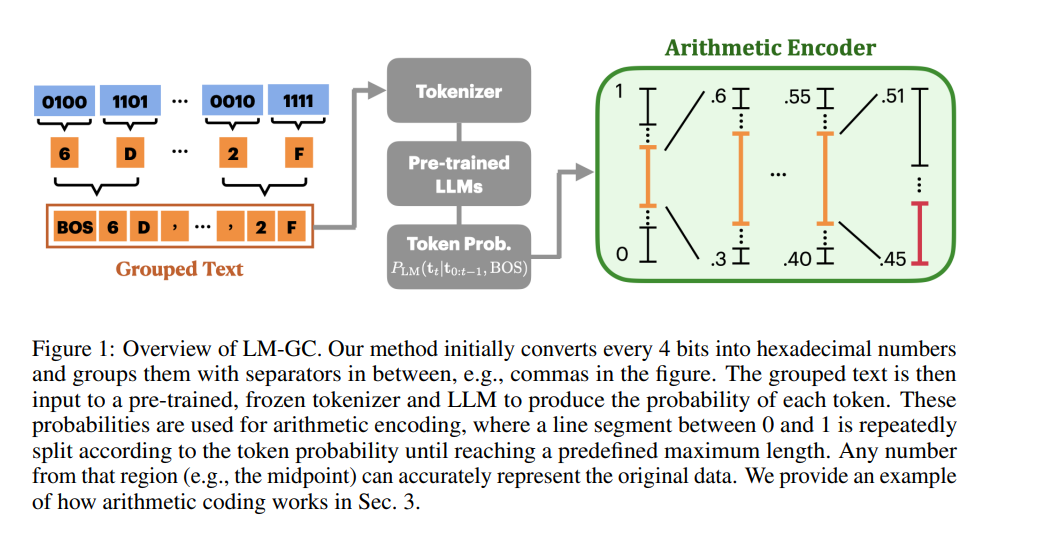

尽管统计先验模型在各个领域得到了广泛应用,但对于神经网络梯度的此类模型长期以来却被忽视。其固有的挑战在于高维结构和复杂的相互依赖性,使得有效建模变得复杂。在本研究中,我们展示了大型语言模型(LLMs)在零样本设置中作为梯度先验的潜力。我们通过考虑无损梯度压缩这一分布式学习中的关键应用来检验这一特性,该应用高度依赖于精确的概率建模。为此,我们引入了一种新的方法 LM-GC,它将 LLMs 与算术编码结合。我们的方法将普通梯度转换为类似文本的格式,相比原始表示,令符效率提高了多达 38 倍。我们确保这种数据转换与普通梯度的结构以及 LLMs 通常识别的符号保持紧密一致。实验表明,LM-GC 超越了现有的最先进的无损压缩方法,在各种数据集和架构中压缩率提升了 10% 到 17.2%。此外,我们的方法与有损压缩技术(如量化和稀疏化)表现出良好的兼容性。这些研究结果突显了 LLMs 在有效处理梯度方面的巨大潜力。源码将在论文发表后发布。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日