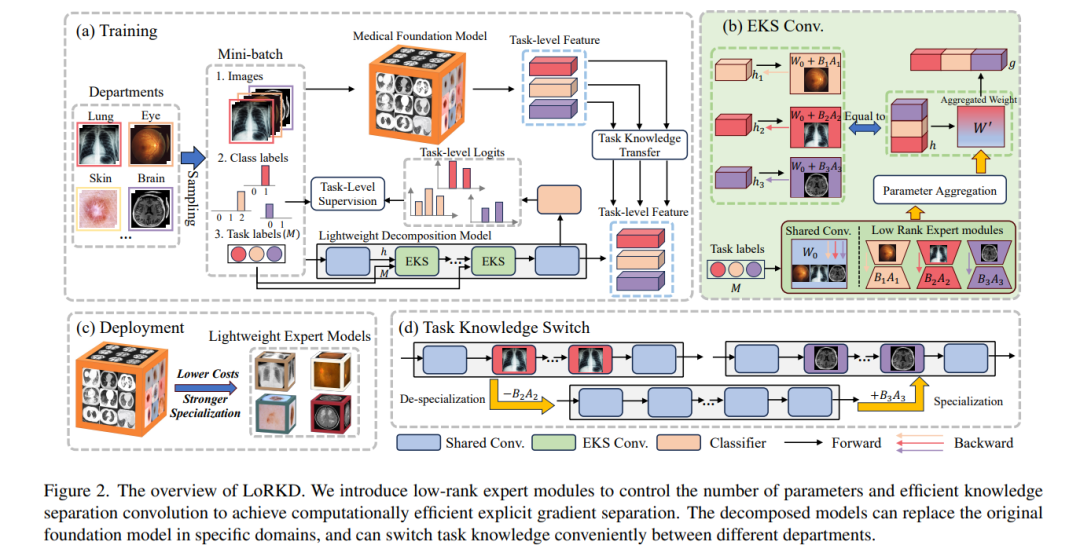

大规模预训练的普及促进了医学基础模型的发展。然而,一些研究表明,尽管基础模型具有较强的一般特征提取能力,但其在特定任务上的表现仍不如特定任务方法。在本文中,我们探索了一种称为“知识分解”的新视角来提高特定医疗任务的性能,该视角将基础模型解构为多个轻量级专家模型,每个模型致力于特定任务,目的是提高专业化,同时减少资源支出。为了实现上述目标,我们设计了一种新的低秩知识分解框架(LoRKD),该框架通过结合低秩专家模块和有效的知识分离卷积来明确地分离梯度。大量的实验结果表明,分解模型在性能和可移植性方面表现良好,甚至超过了原有的基础模型。源代码可从https://github.com/MediaBrainSJTU/LoRK获得

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日