![]()

随着大型语言模型(LLMs)的快速发展,基于LLM的智能体(Agents)和多智能体系统(MAS)显著扩展了LLM生态系统的能力。这一进展源于为LLM赋予了额外的模块,例如记忆、工具、环境,甚至其他智能体。然而,这种进步也带来了更为复杂的可信性问题,这是以往仅关注LLM的研究所无法涵盖的。

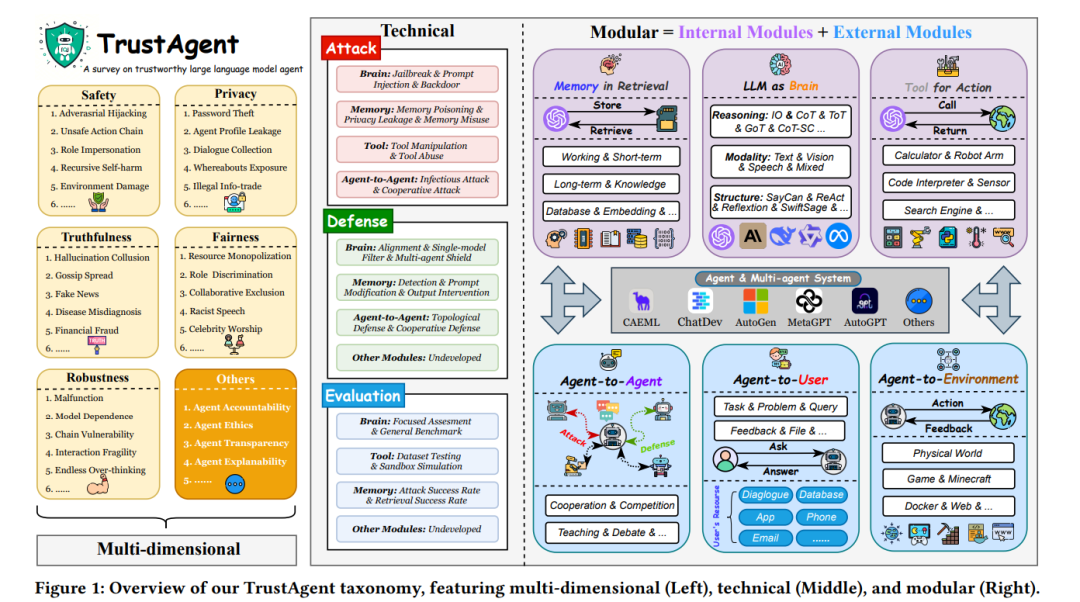

在本综述中,我们提出了TrustAgent框架,这是一个对智能体可信性进行全面研究的框架,其特点包括模块化分类、多维内涵和技术实现。通过深入研究和总结针对智能体及MAS的新兴攻击、防御和评估方法,我们将“可信赖LLM”的概念扩展到了新兴的“可信赖智能体”范式。在TrustAgent中,我们首先解构并介绍了智能体和MAS的各个组成部分。随后,我们将它们的可信性分为内在(大脑、记忆和工具)和外在(用户、智能体和环境)两个方面。接着,我们详细阐述了可信性的多层面含义,并深入探讨了与这些内外模块相关的现有研究的实现技术。最后,我们提出了对该领域的见解和展望,旨在为未来的研究提供指导。为便于参考,我们根据分类法对本综述中提到的所有研究进行了分类,相关资源可在以下链接获取:https://github.com/Ymm-cll/TrustAgent。

**

![]() 大型语言模型(LLMs)的出现推动了人工智能系统的范式转变[9, 66, 93, 137]。将LLM作为核心,并结合额外模块(如记忆[130]、工具[65, 75]和环境[109])作为扩展,催生了“基于LLM的智能体”这一概念,将静态的神经网络转变为能够进行记忆检索、工具利用和环境交互的动态认知主体。此外,智能体间通信的引入进一步催生了更高级的“多智能体系统(MAS)”概念,使得“超级LLM生态系统”变得更加复杂、互动和智能[36, 94, 106, 118, 124, 125]。广泛的学术研究和行业实践已经验证了这一性能层次:MAS > 单智能体 > LLM[8, 54, 84, 100]。然而,额外模块的引入是一把双刃剑,它在多个维度上引发了新的可信性问题,包括安全性、隐私性、公平性和真实性[38, 96, 102]。从风险角度来看,引入新模块扩大了系统的攻击面,可能导致不可预见的漏洞[31, 86, 116]。另一方面,这种整合对现有的防御机制和可信性评估提出了新的挑战,需要扩展和升级以往仅关注LLM或单智能体可信性的研究[40, 131]。以往的研究综述已经深入探讨了可信赖LLM的领域。Liu等人[62]将可信性分解为七大类,特别关注LLM对齐的标准和指南。类似地,Huang等人[41]从六个角度解读可信性,但主要集中在创建评估可信性的基准。然而,这些研究在智能体场景中仅部分有效,突显了解决因引入额外模块而产生的新可信性问题的迫切需求。其他关于智能体可信性的专门综述主要集中在安全和隐私等子领域,且与可信赖LLM的内容存在较大重叠[31, 96, 96]。事实上,一些研究仅解决了LLM作为智能体“大脑”模块所引发的新问题[38, 57],而忽略了其他额外模块带来的未探索挑战。为突出我们的创新,我们在表1中将TrustAgent与其他综述进行了对比。为此,我们提出了TrustAgent框架,如图1所示,将以往可信性研究的领域扩展到智能体和MAS的新背景中。我们的分类法具有以下特点:(I)模块化。TrustAgent严格根据智能体的内部和外部组件对可信性问题进行分类,具体分为内在和外在两个方面。前者包括大脑、记忆和工具的可信性,而后者涵盖与用户、其他智能体和环境相关的部分。(II)技术性。TrustAgent关注可信赖智能体的实现,从攻击、防御和评估三个方面对相关技术栈进行了全面总结和展望(附录B提供了完整图示)。(III)多维度。TrustAgent将LLM可信性的维度扩展到单智能体和MAS的背景下,具体分为:安全性、隐私性、真实性、公平性和鲁棒性(具体定义见附录A),并涵盖了这些维度的现有研究。在每个小节中,我们首先概述当前模块在智能体系统中的机制和作用,然后从攻击、防御和评估等分类角度探讨其可信性问题。最后,我们提供启发性的见解并勾勒出未来潜在的研究方向。总结而言,我们的贡献如下:全面且最新的综述。 我们对基于LLM的智能体系统的可信性进行了全面且当代的分析,涵盖了包括单LLM、单智能体和MAS框架在内的广泛架构。以新技术为导向的分类法。 我们的分类法以破坏、实现和评估可信性的技术为核心,将旧范式更新到智能体背景中,并勾勒出智能体框架内的新技术范式。富有洞察力的未来方向。 针对每个模块的可信性,我们识别了当前的漏洞并勾勒了未来方向,呼吁研究人员深入探索这一领域。

大型语言模型(LLMs)的出现推动了人工智能系统的范式转变[9, 66, 93, 137]。将LLM作为核心,并结合额外模块(如记忆[130]、工具[65, 75]和环境[109])作为扩展,催生了“基于LLM的智能体”这一概念,将静态的神经网络转变为能够进行记忆检索、工具利用和环境交互的动态认知主体。此外,智能体间通信的引入进一步催生了更高级的“多智能体系统(MAS)”概念,使得“超级LLM生态系统”变得更加复杂、互动和智能[36, 94, 106, 118, 124, 125]。广泛的学术研究和行业实践已经验证了这一性能层次:MAS > 单智能体 > LLM[8, 54, 84, 100]。然而,额外模块的引入是一把双刃剑,它在多个维度上引发了新的可信性问题,包括安全性、隐私性、公平性和真实性[38, 96, 102]。从风险角度来看,引入新模块扩大了系统的攻击面,可能导致不可预见的漏洞[31, 86, 116]。另一方面,这种整合对现有的防御机制和可信性评估提出了新的挑战,需要扩展和升级以往仅关注LLM或单智能体可信性的研究[40, 131]。以往的研究综述已经深入探讨了可信赖LLM的领域。Liu等人[62]将可信性分解为七大类,特别关注LLM对齐的标准和指南。类似地,Huang等人[41]从六个角度解读可信性,但主要集中在创建评估可信性的基准。然而,这些研究在智能体场景中仅部分有效,突显了解决因引入额外模块而产生的新可信性问题的迫切需求。其他关于智能体可信性的专门综述主要集中在安全和隐私等子领域,且与可信赖LLM的内容存在较大重叠[31, 96, 96]。事实上,一些研究仅解决了LLM作为智能体“大脑”模块所引发的新问题[38, 57],而忽略了其他额外模块带来的未探索挑战。为突出我们的创新,我们在表1中将TrustAgent与其他综述进行了对比。为此,我们提出了TrustAgent框架,如图1所示,将以往可信性研究的领域扩展到智能体和MAS的新背景中。我们的分类法具有以下特点:(I)模块化。TrustAgent严格根据智能体的内部和外部组件对可信性问题进行分类,具体分为内在和外在两个方面。前者包括大脑、记忆和工具的可信性,而后者涵盖与用户、其他智能体和环境相关的部分。(II)技术性。TrustAgent关注可信赖智能体的实现,从攻击、防御和评估三个方面对相关技术栈进行了全面总结和展望(附录B提供了完整图示)。(III)多维度。TrustAgent将LLM可信性的维度扩展到单智能体和MAS的背景下,具体分为:安全性、隐私性、真实性、公平性和鲁棒性(具体定义见附录A),并涵盖了这些维度的现有研究。在每个小节中,我们首先概述当前模块在智能体系统中的机制和作用,然后从攻击、防御和评估等分类角度探讨其可信性问题。最后,我们提供启发性的见解并勾勒出未来潜在的研究方向。总结而言,我们的贡献如下:全面且最新的综述。 我们对基于LLM的智能体系统的可信性进行了全面且当代的分析,涵盖了包括单LLM、单智能体和MAS框架在内的广泛架构。以新技术为导向的分类法。 我们的分类法以破坏、实现和评估可信性的技术为核心,将旧范式更新到智能体背景中,并勾勒出智能体框架内的新技术范式。富有洞察力的未来方向。 针对每个模块的可信性,我们识别了当前的漏洞并勾勒了未来方向,呼吁研究人员深入探索这一领域。