推荐!《可解释人工智能及其军事意义》【译文】印智库ORF2022最新报告

引言

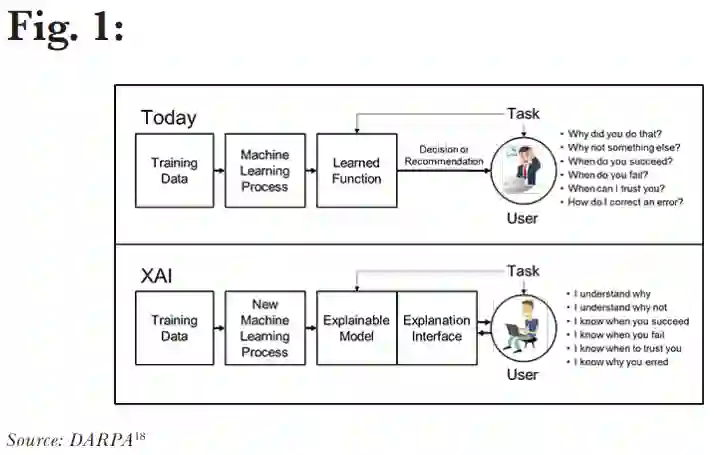

对 XAI 的需求

XAI 实验

探索 XAI 的应用

来自 XAI 的期望

结论

【中英文版请上专知查阅】

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方关注)

点击“发消息” 回复 “XAIMI” 就可以获取《推荐!《可解释人工智能及其军事意义》【译文】印智库ORF2022最新报告》专知下载链接

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“R223” 就可以获取《【牛津大学博士论文】深度多智能体强化学习中的协调与沟通,223页pdf》专知下载链接

登录查看更多