多模态大语言模型(Multimodal Large Language Model, MLLM)当前正处于快速发展阶段,这一进展主要得益于基于语言的大模型(LLM)的先进能力。不同于以往的专用型模型,现有的MLLM正朝着“多模态通才”的范式演进。从最初仅具备多模态理解能力,这些模型已发展到不仅能够理解,还能够跨模态生成内容。其能力已从粗粒度的多模态理解扩展到细粒度层面,同时也从支持单一模态拓展到支持广泛甚至任意模态。

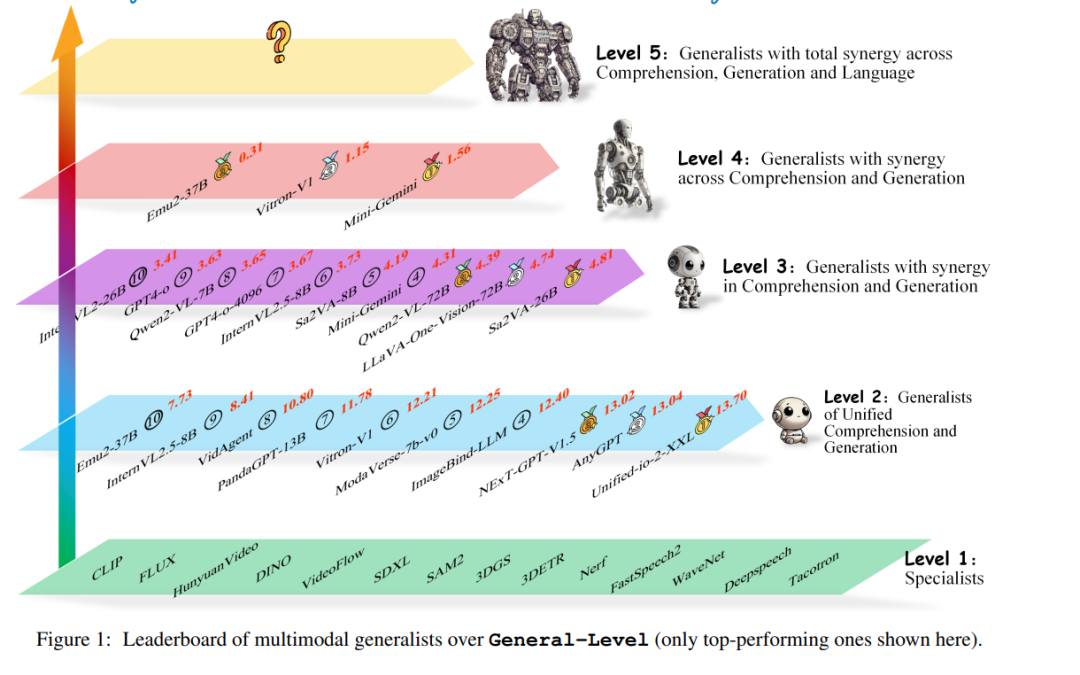

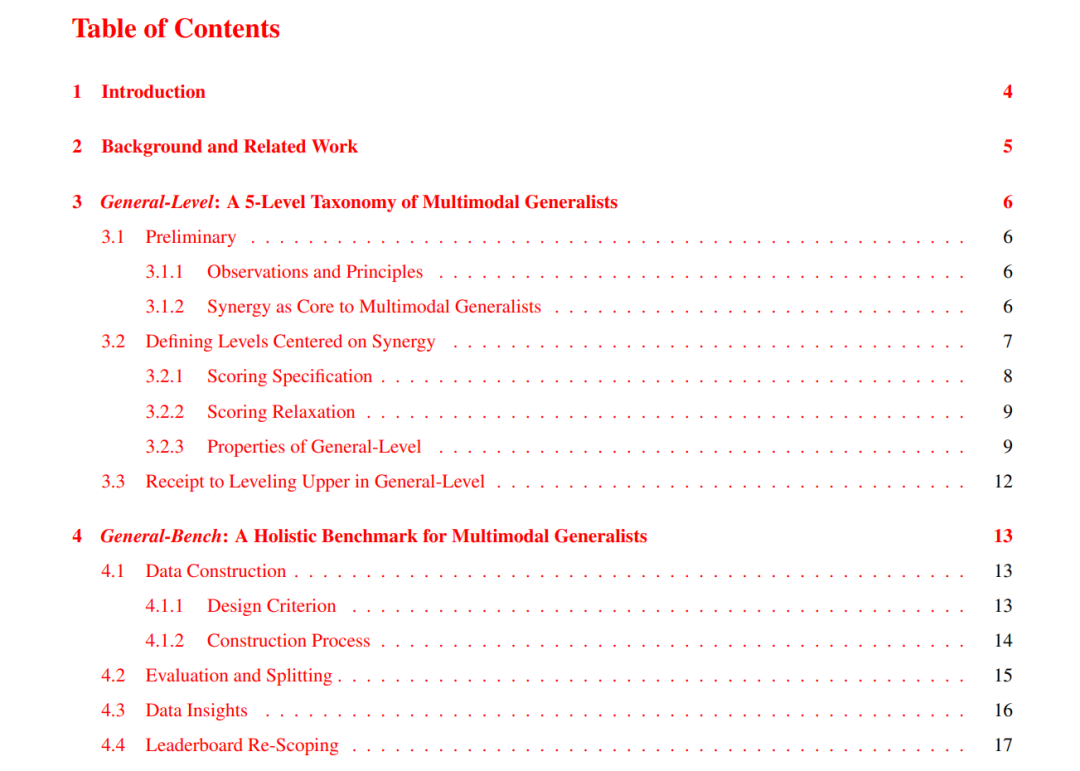

为了评估各类MLLM的能力,研究者提出了多样化的基准测试集。这引出了一个关键问题:我们是否可以简单地认为,在多个任务上取得更高性能就意味着更强的MLLM能力,从而更接近人类级别的人工智能?我们认为,答案远没有那么简单。在本项目中,我们提出了一个评估框架,用以描绘当前多模态通才模型的能力和行为。该框架被称为“通用级别(General-Level)”,建立了一个涵盖五个等级的MLLM性能与通用性评估体系,提供了一种比较不同MLLM的方法论,并用于衡量现有系统向更强大多模态通才,乃至通用人工智能(AGI)演进的进展。

该框架的核心是以“协同效应(Synergy)”作为评估标准,依据模型是否在理解与生成之间,以及在多模态交互中保持协同关系,对其能力进行分类。为了全面评估不同通才模型的综合能力,我们构建了一个大规模的多模态基准测试集——General-Bench。该基准覆盖了更广泛的技能、模态、格式与能力,包含超过700个任务和325,800个实例。通过对100多个当前最先进的MLLM进行评估,结果揭示了各通才模型的能力排名,凸显了实现真正人工智能所面临的挑战。我们希望本项目能够为下一代多模态基础模型的研究铺平道路,提供稳健的基础设施,以加速AGI的实现进程。

1 引言

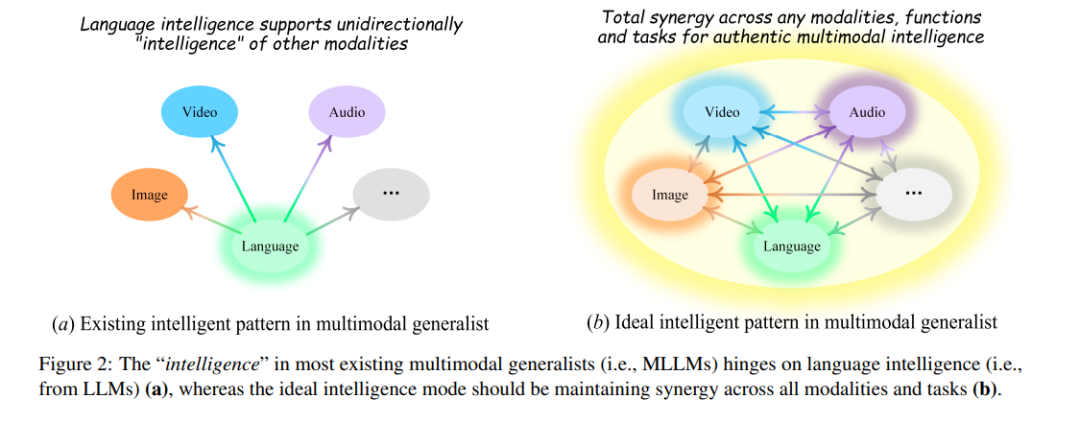

大型语言模型(Large Language Models, LLMs,例如 ChatGPT(OpenAI, 2022a)和 LLaMA(Touvron 等,2023))通过以通才身份应对广泛的自然语言处理(NLP)任务,彻底变革了该领域。这种能力的广度,使人类在实现通用人工智能(Artificial General Intelligence, AGI)的道路上更进一步。然而,人类智能本质上是多模态的,而不仅仅依赖语言。这一认知推动了多模态大语言模型(Multimodal Large Language Models, MLLMs)的发展(Alayrac 等, 2022;Li 等, 2023a;Liu 等, 2023a;OpenAI, 2022b),即“多模态通才”,目前正迅速发展,并逐步向 AGI 靠近。 MLLM 的最新进展表现为多个重要突破。例如,最初的多模态智能体中,LLMs 仅作为任务调度器出现,后来逐步演化为联合训练的基础型多模态模型(Zhu 等, 2023a;Liu 等, 2023a;Zhang 等, 2023a;OpenAI, 2022b;Wu 等, 2024a;Chen 等, 2024a;Sun 等, 2024)。此外,MLLM 的能力已从仅能理解多模态信号,发展到可同时进行理解与生成,甚至具备编辑能力(Wang 等, 2023a;Munasinghe 等, 2023;Zhang 等, 2024a;Fei 等, 2024a)。模型的理解能力也从粗粒度跨模态理解,提升到细粒度层级,例如像素级视觉建模(Ren 等, 2023;Yuan 等, 2023a;Rasheed 等, 2023)。更为关键的是,这些模型已从只支持单一非文本模态,扩展到能同时理解和生成多种模态,甚至能够处理任意模态的输入(Wu 等, 2024a;Zhan 等, 2024;Lu 等, 2024a)。 因此,研究社区相继提出了多种用于评估 MLLM 的基准测试集(Wu 等, 2023a;Xia 等, 2024a;Yue 等, 2024a;Meng 等, 2024a;Liu 等, 2025;Li 等, 2024a;Ying 等, 2024a;Li 等, 2024b)。然而,当前主流的评估观念可能已经滞后,往往简单地假设:在多个任务上获得更高性能,就代表具备更强的通才能力,也就更接近 AGI(Xu 等, 2023a;Yu 等, 2023;Fu 等, 2024a;Chen 等, 2024b)。我们认为这种观点过于简化了“真实多模态泛化能力”背后的深层含义。理论上,我们可以将多个任务上表现最好的 SoTA 专家模型拼接在一起,构建一个“超级智能体”,看似也可达成类似目标,但这种简单堆叠式整合远不能实现真正的 AGI。 我们认为,迈向 AGI 的关键在于“协同效应(Synergy Effect)”——即一种能力,能够使模型在某一模态或任务中学到的知识迁移并增强对其他模态或任务的掌握,实现不同模态和任务之间的互促与提升。 如图 2 所示,目前大多数 MLLM 主要建立在语言模型的智能基础上,模拟出一种“间接的多模态智能”,本质上是将语言智能延伸用于多模态理解。尽管某些 LLM(如 ChatGPT)已在 NLP 任务中展示出跨任务的协同效应,反映了语言智能的潜力,但多数 MLLM 并未真正实现在模态之间或任务之间的协同。 在本项目中,我们提出了一个更为精细的评估框架——General-Level,以更准确地定位并评估当前多模态通才模型的能力,为实现真正的多模态 AGI 指明路径。受到自动驾驶领域分级标准的启发(Yurtsever 等, 2020),General-Level 建立了五个主要性能与通用性等级的划分标准。该框架以“协同能力”作为核心评估准则,依据模型在多模态理解与生成、以及模态交互中的协同表现,对其能力进行分级。从最低到最高等级,所要求的协同能力范围依次从单一任务或模态扩展到“完全协同”,并且等级越高,模型所需跨模态整合与泛化的能力也越高,晋升难度也随之增加。 要在 General-Level 框架中进行有效评估,一个合适的基准体系至关重要。尽管已有多个 MLLM 评估基准,例如 LVLM-eHub(Xu 等, 2023a)、MME(Fu 等, 2024a)、MMMU(Yue 等, 2024a)、SEED-Bench(Li 等, 2024a)、MMT-Bench(Ying 等, 2024a)和 MEGA-Bench(Chen 等, 2024b),但它们往往存在以下局限: 1. 多数现有基准将所有任务统一转换为多选题格式(Fu 等, 2024a;Ying 等, 2024a),虽然简化了评估流程,却局限在“多模态理解”能力评估上,忽略了生成、编辑等关键能力; 1. 多数基准集中于图像模态,忽视了视频、音频、三维等其他关键模态(Wu 等, 2023a;Liu 等, 2025;Li 等, 2024a); 1. 当前评估体系主要停留在粗粒度理解层面,无法评估如像素级图像理解与生成等细粒度能力(Fei 等, 2024a;Zhang 等, 2024a)。

为应对上述挑战,我们提出了一个大规模多模态评估基准——General-Bench,覆盖图像、视频、音频、三维、语言等多种原生模态格式,涵盖范围广泛的任务,全面评估一个多模态通才应具备的核心能力。 我们对 100 多个当前最先进的 LLM/MLLM 系统进行了评估,揭示了它们作为多模态通才的能力与排名。其中一个显著发现是:绝大多数 MLLM 缺乏“跨任务”或“跨模态”的协同能力,因此难以达到较高等级评估标准,甚至 GPT-4V 和 GPT-4o 等先进模型也未能获得顶级排名。这表明在迈向真正多模态 AGI 的道路上仍存在明显差距。同时,大多数模型只能完成少数基本的多模态任务与技能,这也拉低了其综合评分。更关键的是,当前尚无模型能够通过非语言模态提升语言智能,这一现象凸显了实现 AGI 所面临的重大挑战。 主要贡献:

1)我们提出了一个多模态通才的分级标准体系——General-Level,为 MLLM 研究提供了严谨的评估规范与标准; 2)我们构建了一个全新的多模态评估基准——General-Bench,提供了当前最广泛的模态与任务覆盖。 我们希望本项目能够作为推动下一代多模态基础模型发展的基础设施,助力构建更强大、通用的多模态智能系统,进一步迈向 AGI。