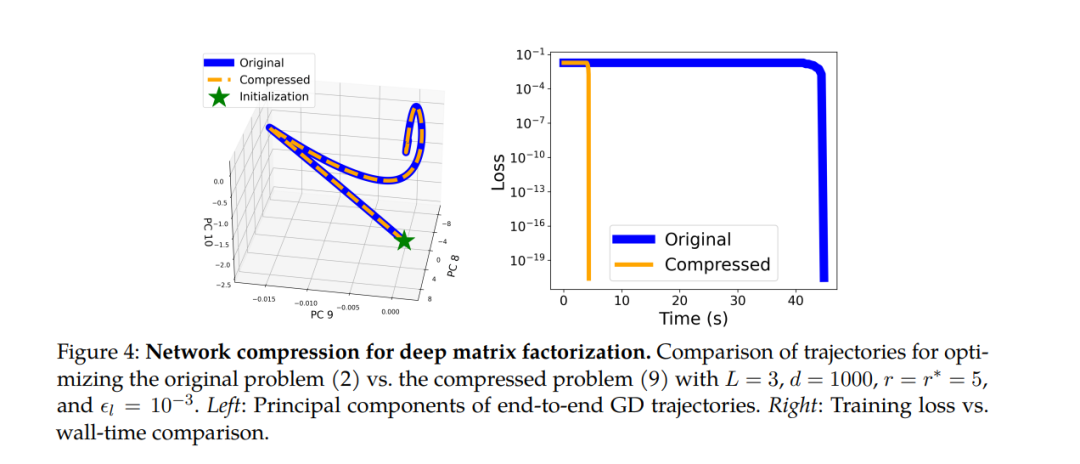

尽管机器学习模型中的过参数化在优化和泛化方面带来了极大的好处,但随着模型规模的增长,也导致了计算需求的增加。在这项工作中,我们展示了通过利用数据和模型参数内在的低维结构和可压缩动力学,我们可以在不增加计算负担的情况下享受过参数化的好处。在实践中,我们证明了这种方法在深度低秩矩阵补全以及微调语言模型方面的有效性。我们的方法基于深度过参数化低秩矩阵恢复的理论发现,我们证明了每个权重矩阵的学习动力学被限制在一个不变的低维子空间中。因此,我们可以构建和训练紧凑的高度压缩的分解,同时具有与其过参数化对应物相同的优势。在深度矩阵补全的背景下,我们的技术在保持过参数化优势的同时,大大提高了训练效率。对于语言模型的微调,我们提出了一种称为“Deep LoRA”的方法,这种方法改进了现有的低秩适应(LoRA)技术,减少了过拟合并简化了超参数设置,同时保持了相当的效率。我们在自然语言任务中验证了Deep LoRA的有效性,特别是在有限数据下进行微调时。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日