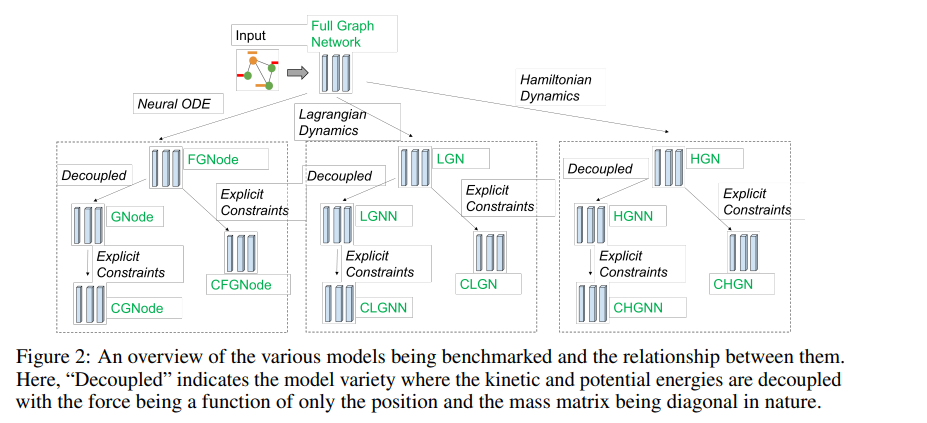

最近,图神经网络在模拟动态系统方面获得了很多关注,因为其归纳性导致了零样本泛化。同样,深度学习框架中基于物理学的归纳偏差已被证明在学习物理系统的动力学方面具有卓越的性能。越来越多的文献试图将这两种方法结合起来**。本文评估了13种不同的图神经网络的性能,即哈密顿和拉格朗日图神经网络、图神经ODE及其具有显式约束和不同架构的变体。我们简要解释了理论公式,强调了这些系统在归纳偏差和图架构方面的异同**。在弹簧、摆、引力和3D可变形固体系统上评估了这些模型,以在推出误差、能量和动量等守恒量以及对未见系统尺寸的通用化方面比较性能。我们的研究表明,带有附加归纳偏差的gnn,如显式约束和动能和势能的解耦,表现出显著增强的性能。此外,所有基于物理学的GNNs对比训练系统大一个数量级的系统大小表现出零样本泛化能力,从而为模拟大规模现实系统提供了一条有希望的路线。 https://www.zhuanzhi.ai/paper/4c44f7858ecd1ef3985cfb582ccf7f30

成为VIP会员查看完整内容

相关内容

Arxiv

20+阅读 · 2021年12月27日

Arxiv

20+阅读 · 2021年5月27日