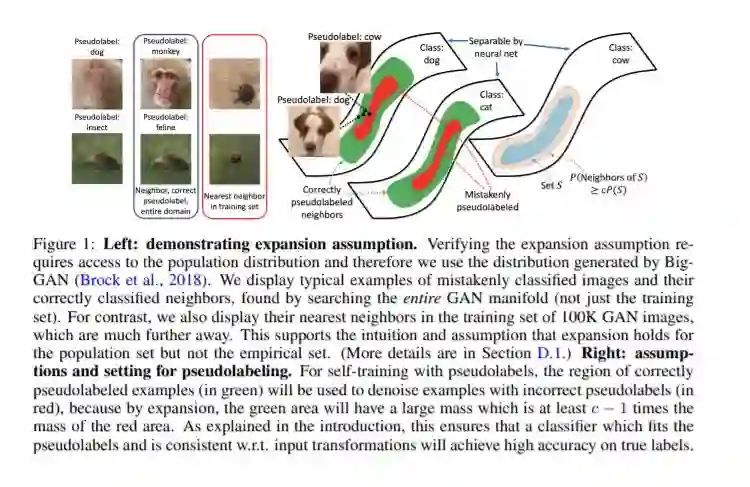

自训练算法训练模型以适应另一个先前学习的模型预测的伪标签,对于使用神经网络对未标记的数据进行学习非常成功。但是,当前对自训练的理论理解仅适用于线性模型。这项工作为半监督学习,无监督领域适应和无监督学习提供了深度网络自训练的统一理论分析。我们分析的核心是一个简单但现实的“扩展”假设,该假设指出,数据的低概率子集必须扩展到相对于子集而言具有较大概率的邻域。我们还假设不同类别中的示例邻域具有最小的重叠。我们证明在这些假设下,基于自训练和输入一致性正则化的人口目标最小化方法将在地面真相标签方面实现高精度。通过使用现成的泛化边界,我们立即将此结果转换为在边际和Lipschitzness中为多项式的神经网络的样本复杂度保证。我们的结果有助于解释最近提出的使用输入一致性正则化的自训练算法的经验成功。

https://www.zhuanzhi.ai/paper/dd480967a4f15984429301bca4c6cc92

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2021年4月13日

Arxiv

5+阅读 · 2020年12月21日