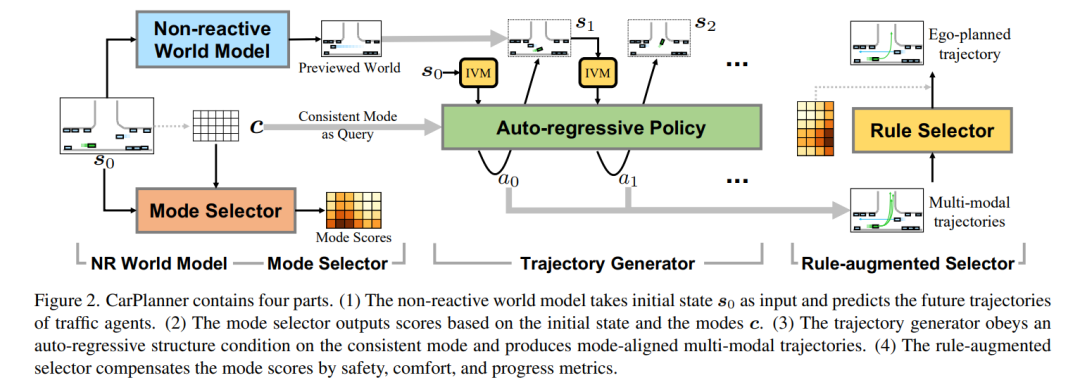

![]() 轨迹规划对于自动驾驶至关重要,确保在复杂环境中实现安全高效的导航。尽管最近基于学习的方法,特别是强化学习(RL),在特定场景中展现了潜力,但RL规划器在训练效率和处理大规模现实驾驶场景方面仍面临挑战。在本文中,我们提出了CarPlanner,一种基于一致性的自回归规划器,利用RL生成多模态轨迹。自回归结构实现了高效的大规模RL训练,而一致性的引入通过保持时间步之间的一致性,确保了稳定的策略学习。此外,CarPlanner采用了一种生成-选择框架,结合专家引导的奖励函数和不变视角模块,简化了RL训练并提升了策略性能。大量分析表明,我们提出的RL框架有效解决了训练效率和性能提升的挑战,使CarPlanner成为自动驾驶轨迹规划的有前景的解决方案。据我们所知,我们是首个证明基于RL的规划器能够在具有挑战性的大规模现实数据集nuPlan上超越基于模仿学习(IL)和基于规则的最先进方法(SOTAs)的研究。我们提出的CarPlanner在这一高要求数据集中超越了基于RL、IL和规则的SOTA方法。

轨迹规划对于自动驾驶至关重要,确保在复杂环境中实现安全高效的导航。尽管最近基于学习的方法,特别是强化学习(RL),在特定场景中展现了潜力,但RL规划器在训练效率和处理大规模现实驾驶场景方面仍面临挑战。在本文中,我们提出了CarPlanner,一种基于一致性的自回归规划器,利用RL生成多模态轨迹。自回归结构实现了高效的大规模RL训练,而一致性的引入通过保持时间步之间的一致性,确保了稳定的策略学习。此外,CarPlanner采用了一种生成-选择框架,结合专家引导的奖励函数和不变视角模块,简化了RL训练并提升了策略性能。大量分析表明,我们提出的RL框架有效解决了训练效率和性能提升的挑战,使CarPlanner成为自动驾驶轨迹规划的有前景的解决方案。据我们所知,我们是首个证明基于RL的规划器能够在具有挑战性的大规模现实数据集nuPlan上超越基于模仿学习(IL)和基于规则的最先进方法(SOTAs)的研究。我们提出的CarPlanner在这一高要求数据集中超越了基于RL、IL和规则的SOTA方法。

![]()