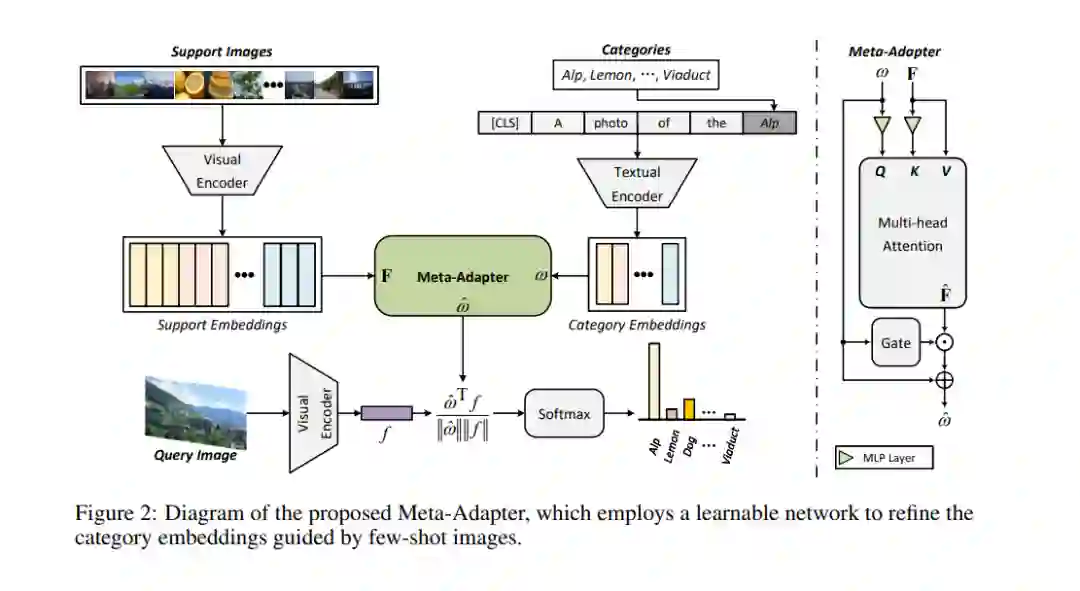

对比视觉-语言预训练,即CLIP,展现了在感知开放世界视觉概念方面的显著潜力,实现了有效的零样本图像识别。然而,基于CLIP的小样本学习方法通常需要在少量样本上进行离线微调参数,这导致了更长的推理时间和在某些领域过拟合的风险。为了应对这些挑战,我们提出了Meta-Adapter,一种轻量级的残差风格适配器,用以指导少样本在线细化CLIP特征。通过少量的训练样本,我们的方法可以实现有效的小样本学习能力,并且在没有额外微调的情况下泛化到未见过的数据或任务,达到了具有竞争力的性能和高效率。我们的方法不需要复杂的附加功能,就在八个图像分类数据集上平均超过了最新的在线小样本学习方法3.6%的性能,并且具有更高的推理速度。此外,我们的模型简单灵活,可作为直接适用于下游任务的即插即用模块。在无需进一步微调的情况下,Meta-Adapter在开放词汇的对象检测和分割任务中取得了显著的性能提升。

https://www.zhuanzhi.ai/paper/988c88672e1bfafaceee944b23e8228e

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

225+阅读 · 2023年4月7日