BEHAVIOR是一个以人为中心的仿真基准测试,用于评估具身AI解决方案。具身人工智能(EAI)正在进步。但我们现在处于何种状态呢?我们提议用物理挑战测试EAI代理,这些挑战是人们在日常生活中需要解决的:家庭活动如洗衣服、捡玩具、摆桌子或清洁地板。BEHAVIOR是一个仿真中的基准测试,在这里EAI代理需要根据传感器信息规划和执行导航与操作策略,以完成多达1000个家庭活动。BEHAVIOR测试代理感知环境、规划和执行复杂的长期活动的能力,这些活动涉及多个对象、房间和状态变化,所有这些都通过逼真的物理仿真提供可重现性、安全性和可观察性。

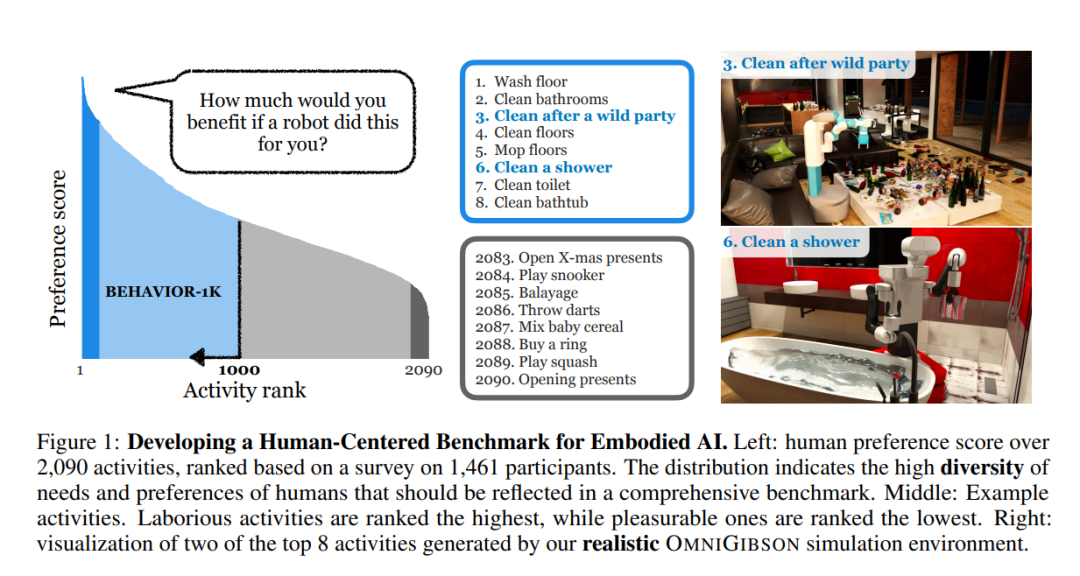

BEHAVIOR的更广泛目标是促进通用、有效的EAI的发展,为人们的日常生活带来重大好处——以人为中心的AI,服务于人类的需求、目标和价值观。BEHAVIOR通过从人类时间使用调查中选择活动,并进行大规模偏好调查来实现这一点,询问人们:“你希望机器人为你做哪些日常活动?”此外,这些活动是基于参与式设计原则定义的:一支由众包工作者和研究人员组成的团队共同工作,为BEHAVIOR活动提供知识和定义。

我们提出了BEHAVIOR-1K,这是一个针对以人为中心的机器人学的综合模拟基准测试。BEHAVIOR-1K包括两个部分,这两部分的设计受到了关于“你希望机器人为你做什么?”的广泛综述的指导和激励。第一个部分是定义1000种日常活动,这些活动基于50个场景(如房屋、花园、餐厅、办公室等),涉及9000多个物体,这些物体带有丰富的物理和语义属性的注解。第二部分是OMNIGIBSON,一个新颖的模拟环境,支持通过真实物理模拟和刚体、可变形体及液体的渲染来进行这些活动。我们的实验表明,BEHAVIOR-1K中的活动具有长时间跨度且依赖于复杂的操控技能,这两点都是即使是最先进的机器人学习解决方案仍然面临的挑战。为了校准BEHAVIOR-1K的模拟与现实之间的差距,我们提供了一个初步研究,研究了在模拟公寓中用移动操控器学习到的解决方案转移到其现实世界对应物的情况。我们希望BEHAVIOR-1K的以人为本的特性、多样性和现实性使其成为具身AI和机器人学习研究的宝贵资源。

项目网站:https://behavior.stanford.edu。

受到计算机视觉[1-11]和自然语言处理[12-16]中基准测试带来的进步的启发,机器人学界已经开发了多个模拟基准[17-30]。这些基准的更广泛目标是推动通用、高效机器人的发展,这些机器人能为人们的日常生活带来重大益处——即以人为中心的AI,“服务于人类的需求、目标和价值观”[31-34]。虽然这些基准令人鼓舞,但其中的任务和活动是由研究者设计的;它们是否真正满足了人类的实际需求,这一点仍然不明确。 **我们观察到,以人为中心的机器人基准不仅应该为人类需求而设计,而且还应该源于人类需求:人们希望机器人为他们做哪些日常活动?**为此,我们进行了一项广泛的调查,调查对象为1461名参与者(见第2节),以对基于参与者希望将这些活动委托给机器人的愿望对各种日常活动进行排序。我们还要求普通人标注员为这些活动提供定义。调查揭示了人们希望机器人做哪些活动的系统性,但更重要的是,突出了我们在设计机器人基准时应优先考虑的两个关键因素:场景、物体和活动类型的多样性,以及底层模拟环境的真实性。 调查指出最需要的活动范围从“洗地板”到“清洁浴缸”。显然,这些活动的多样性远远超出了现实世界机器人挑战所能提供的[35-42]。开发模拟环境是一个自然的替代方案:人们可以在多种活动、场景、物体和条件下高效、安全地训练和测试机器人代理。然而,要使这一范式工作,必须真实地模拟这些活动,准确地再现机器人在现实世界中可能遇到的情况。虽然在特定领域取得了真实性方面的重大进展[43-45],但要实现一组多样化活动的真实性仍然是一个巨大挑战,因为提供真实模型和模拟特性需要巨大的努力。

在这项工作中,我们介绍了BEHAVIOR-1K,即在虚拟、交互式和生态环境中的1000种日常家庭活动的基准——BEHAVIOR-100[27]的下一代。BEHAVIOR-1K包括两个新颖组成部分,以满足多样性和真实性的需求:多样的BEHAVIOR-1K数据集和真实的OMNIGIBSON模拟环境。BEHAVIOR-1K数据集是一个大规模数据集,包含1)1000个活动的常识知识库,用谓词逻辑定义(初始条件和目标条件),以及涉及的物体、它们的属性和状态转换;2)包括50个场景和9000多个物体模型的高质量3D资产,带有丰富的物理和语义注释。 BEHAVIOR-1K数据集中的所有活动都在一个新颖的模拟环境OMNIGIBSON中实例化,我们在Nvidia的Omniverse和PhysX 5[46]之上构建了OMNIGIBSON,以提供真实的物理模拟和刚体、可变形体和流体的渲染。OMNIGIBSON通过一组扩展的物体状态(如温度、切换、浸湿和脏污)超越了Omniverse的能力,还包括生成有效初始活动配置和根据活动定义鉴别有效目标解决方案的能力。凭借所有这些真实的模拟特性,OMNIGIBSON支持BEHAVIOR-1K数据集中的1000种多样活动。

我们在BEHAVIOR-1K的几项活动中评估了最先进的强化学习算法[47,48],既有在原始动作空间中的视觉运动控制,也有利用基于采样的运动规划[49]的动作原语。我们的分析表明,即使是BEHAVIOR-1K中的单一活动对当前的AI算法来说也是极其具有挑战性的,且基线只能在注入大量领域知识的情况下解决它。具体来说,困难部分源于BEHAVIOR-1K活动的长度和所需的物理操控复杂性。为了校准BEHAVIOR-1K的模拟与现实的差距,我们提供了一个初步研究,研究了在模拟公寓中用移动操控器学习到的解决方案转移到其现实世界对应物的情况。我们希望BEHAVIOR-1K基准、我们的调查和我们的分析将有助于支持和指导未来具身AI智能和机器人的开发。