近年来,大型推理模型(Large Reasoning Models,LRMs)在诸如 DeepSeek-R1 等代表性模型的“慢思维”推理过程中取得了显著进展。尽管这些模型在推理能力上表现出色,但其巨大的计算开销也带来了诸多挑战。相比之下,小型推理模型(Small Reasoning Models,SRMs)通常由大型模型蒸馏而来,在效率方面具有明显优势,并可能呈现出不同于 LRM 的能力表现和认知路径。

本研究对约 170 篇近期发表的关于 SRMs 的论文进行了综述,涵盖了其在处理各类复杂推理任务中的应用。我们系统回顾了当前 SRMs 的研究现状,深入分析了其训练与推理方面的多种技术方法。同时,我们还对 SRMs 在特定领域中的应用进行了全面梳理,并探讨了未来可能的研究方向。 本综述为研究人员提供了一个重要的参考框架,助力其高效地利用或构建 SRMs,实现先进的推理功能。

1 引言

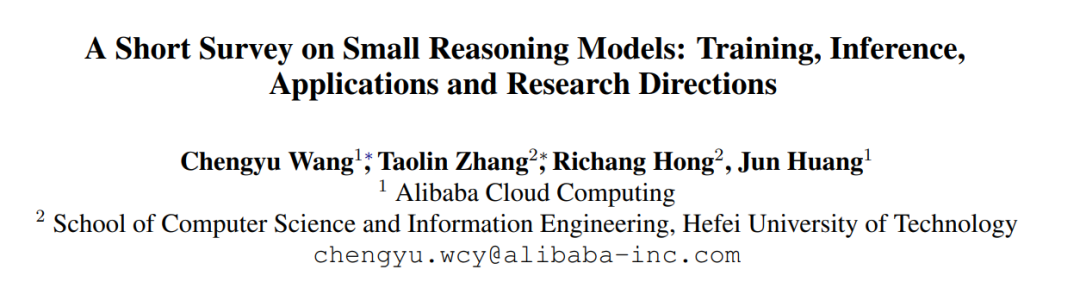

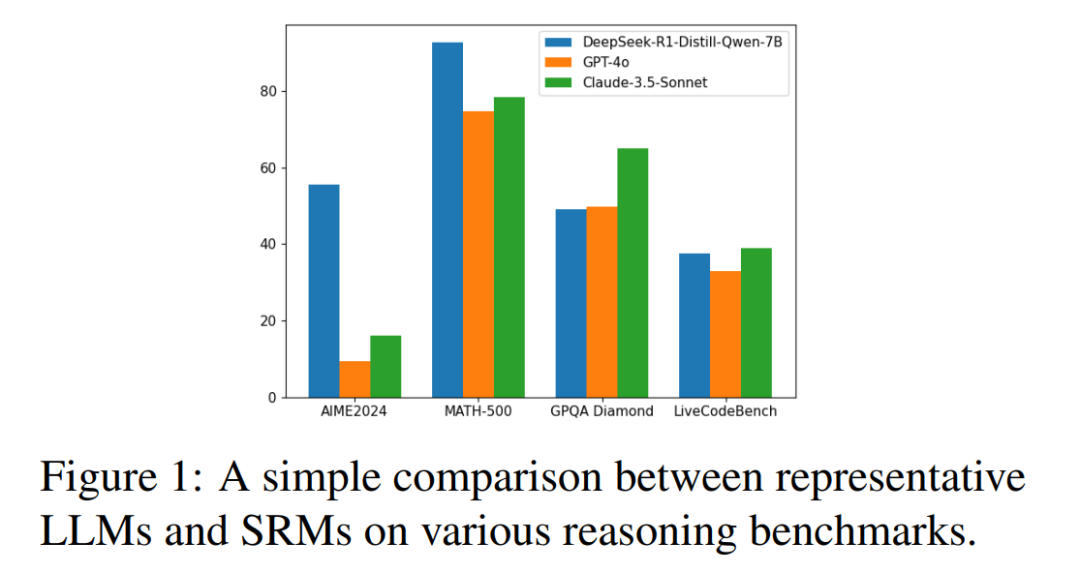

“要在小事上忠实,因为你的力量正是在其中显现。” ——特蕾莎修女 近年来,自然语言处理(NLP)领域因大型语言模型(Large Language Models,LLMs)的广泛应用而发生了深刻变革(Zhao 等,2023)。这些模型在多种下游任务中展现出卓越的能力。其中,专注于推理任务的大型推理模型(Large Reasoning Models,LRMs)(Xu 等,2025),如 DeepSeek-R1(DeepSeek-AI,2025)与 QwQ-32B1,尤为引人注目。这些模型通过模拟“慢思维”(slow thinking)过程,擅长解决诸如数学问题、代码生成、逻辑推理等复杂任务。 然而,这些模型卓越性能的背后是巨大的计算开销,无论是在训练还是推理阶段。例如,DeepSeek-R1 拥有 6710 亿参数,其在线部署至少需要配备八块 A100(80GB)GPU 的服务器或更高规格的硬件配置。 因此,研究社区日益关注更小规模模型的潜力(Fu 等,2023b;Magister 等,2023;Shridhar 等,2023;Zhang 等,2025a),期望在不显著牺牲性能的前提下,寻求更高效的替代方案。自 DeepSeek-R1 发布以来,开源社区涌现出大量成果,显示出具备“慢思维”能力的小型推理模型(Small Reasoning Models,SRMs)(即采用长链式思维过程(chain-of-thought,Wei 等,2022))在部分推理任务中甚至能超越规模更大的 LLM,如图 1 所示。 此外,SRMs 相较于 LRMs 通常表现出不同的能力特征与认知轨迹(Yan 等,2023;Zhang 等,2024a;Hu 等,2024b),因此其训练与推理方法在本质上也有所区别。当前已有大量研究致力于构建性能强劲的 SRMs,力图使其在效果上接近甚至超越 LRM。 尽管已有一些综述聚焦于 LLM 在推理任务中的应用(Plaat 等,2024;Xu 等,2025;Huang 和 Chang,2023;Giadikiaroglou 等,2024;Ahn 等,2024),但专门围绕 SRMs 的综述和系统性研究仍显不足。 为此,本文将对 SRMs 进行简明而全面的综述。我们系统梳理了近三年内公开或发表的约 170 篇相关研究论文,旨在整合关于 SRMs 的技术方法、应用实践与未来研究方向等方面的知识。图 2 展示了本综述的整体结构。

**本综述涵盖内容:

对当前开源社区中主流的 SRMs 进行简要回顾; * 探讨多种旨在增强预训练模型推理能力的训练与推理方法; * 梳理 SRMs 在特定领域的应用实践; * 分析未来研究的可能方向,并提出相应建议。

**不涵盖内容:

本综述不涉及整个 LLM 架构的设计或通用算法,也不讨论与复杂推理无关的任务;此外,诸如模型压缩(如剪枝、量化)或大规模预训练等通用小模型构建技术也不在本综述范围内。我们的关注点集中于 SRMs 在推理任务中的特定技术与应用。 总之,SRMs 的研究为 NLP 社区带来了一个重要且契合当下趋势的方向。通过进一步挖掘其高效与强大推理能力,研究人员有望推动更加高性能、可持续的真实世界智能系统的构建与落地。