https://www.zhuanzhi.ai/paper/4c2e685ea8f431dcb1d1b398d5726b04

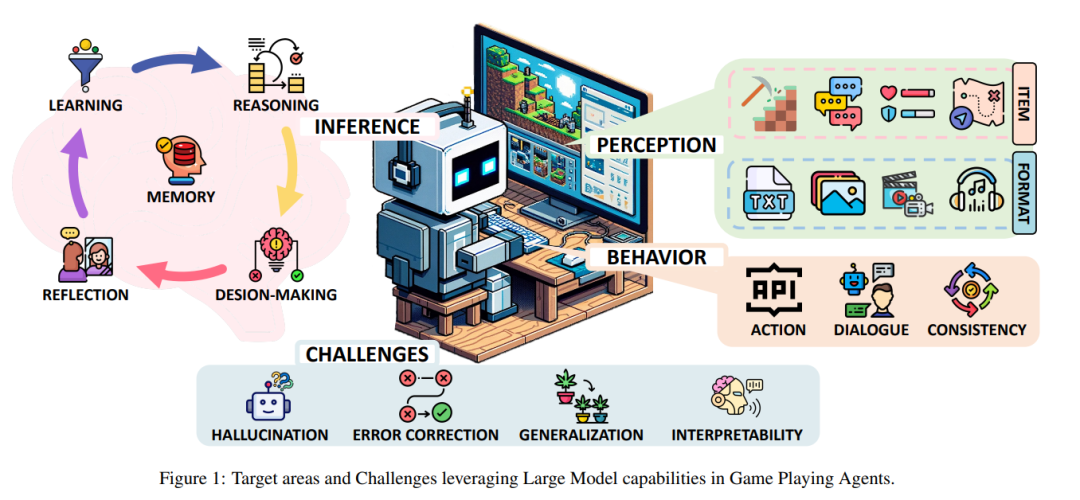

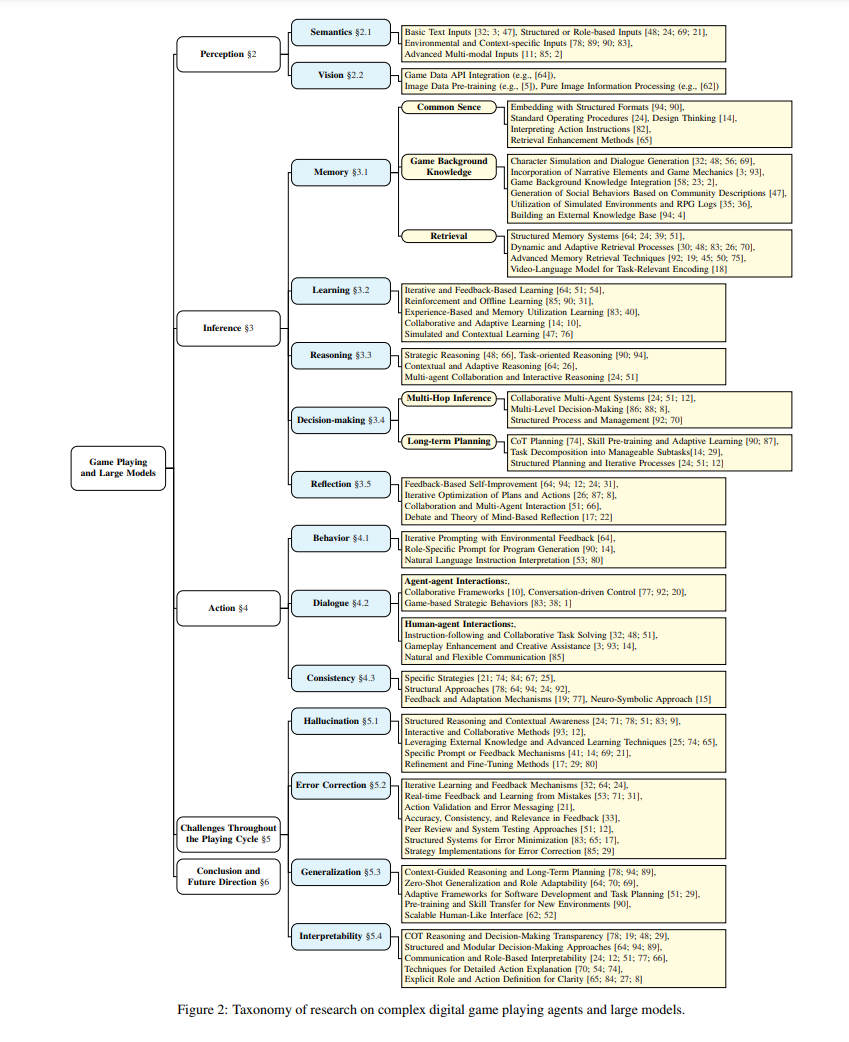

大规模模型(LMs)的发展,包括语言和多模态模型,在自然语言处理和计算机视觉领域是一个重要的进步。最近在LMs方面的进步导致了在各种应用中的显著成就,包括文本生成[93]、图像理解[91]和机器人技术[16]。这些进展促使研究人员探索使用LMs“作为”执行复杂任务的代理,其中许多基于LM的代理(LMAs)在很多情况下展示出与传统训练方法相比有趣的泛化能力[61;70]。LMs所展现的能力导致了人们对其在游戏玩法应用中的浓厚兴趣。这种兴趣在像Minecraft[37]这样的流行游戏中尤为明显,其中LMs处理复杂、动态环境的潜力正在被积极探索。在追求人工通用智能(AGI)研究的背景下,数字游戏因其提供需要高级推理和认知能力的复杂挑战而被认为是重要的,作为评估代理和系统能力的理想基准[79;6]。在游戏环境中的数据获取过程在成本效益、可控性、安全性和多样性方面相比真实世界的实验具有优势,同时保留了重大挑战。尽管即便在学术界之外尝试分析或形式化游戏AI代理及其组件并非最近的现象[42;43;44],但研究LMAs在复杂游戏环境中的表现对于界定它们当前的局限性和评估朝着自主性、泛化能力的进步、指导新架构的设计以及更接近潜在AGI的方向非常关键。此外,这篇综述代表了对游戏玩家代理和大模型的首次全面考察,旨在通过提供对最近将LMAs与游戏玩法应用集成的尝试(例如,作为主玩家、协助人类玩家、控制NPCs)的概览,以及对它们进行情境化和对比,并识别剩余的开放挑战,以催化该领域的后续研究。 人脑功能作为一个复杂的信息处理系统,首先将感官信息转化为感知表征,然后使用这些表征来构建对世界的了解并做出决策,最后通过行动实施决策[13]。由于这一抽象序列反映了在游戏玩法代理中观察到的典型迭代周期,即感知(§2)、推理(§3)和行动(§4),我们在这篇综述中采用了类似的组织结构。图1展示了核心综述结构,覆盖了如何将感官信息转化为行动的本质,以及LMs在每一步骤中可以扮演的角色。感知涉及将游戏过程中的原始观察信息转化为可行的见解,支持后续的交互。最初的研究集中在通过文本理解语义信息[64;83],而更近期的工作集中在整合视觉信息(例如,[91])。推理涵盖了游戏代理的关键能力,包括记忆、学习、推理、反思和决策;通常建立在一个全面的认知框架上。这个框架适应于各种应用背景,这意味着并非每个场景都需要所有个别组件。特别是,记忆是关于有效存储和检索学习知识以增强常识和游戏特定见解的[94;24]。学习通常涉及通过经验和多代理系统中的协作努力获得技能和策略适应[14]。推理是处理和综合信息以解决问题的过程[48]。在复杂游戏中的决策要求多跳推理[34]和长期规划[24],结合序列任务分解和协作决策,以有效应对动态游戏。而反思意味着自我改进的过程,代理基于反馈评估和调整它们的策略[64]。这些组件使得LMs赋能的代理能够在现代数字游戏的动态和演化环境中有效行动。行动涵盖了与游戏环境的互动回馈,即代理响应游戏状态和环境反馈执行的操作。使用生成式编码执行行为,采用技术如迭代提示[64]、角色特定工程[14]或代码生成[64;62]。对话互动涵盖代理-代理和人-代理通信,采用协作框架[12],和对动态互动的对话驱动控制[77]。通过例如使用有向无环图(DAG)的结构方法来强调代理的行为一致性,用于逻辑行动进程[78],结合反馈机制以适应环境[94],并通过策略如强化学习(RL)来加强一致的行动选择[84]。这些方法使LMAs不仅能够处理复杂任务,还能适应行为以保持与游戏目标在动态游戏环境中的一致性和对齐。 尽管如此,在所有阶段(以及在其他游戏场景中)仍然存在挑战。在LMAs中尤其重要的四个挑战包括:i)解决在批判代理和结构化推理中的幻觉问题[24;78];ii)通过迭代学习或反馈(例如,[32])纠正错误;iii)将学习到的知识泛化到未见任务,可能使用零射学习或结构化适应性[64;90];以及iv)可解释性,这要求透明的决策过程。虽然这些在多样化的AI系统中得到展示,它们也突显了LMs针对游戏环境的特定需求的内在限制的影响。 这篇综述的结构概览如图2所示。在§2、§3和§4中,我们回顾现有基于LM的游戏代理如何处理感知、推理和行为。在§5中,我们分析在这三个阶段中遇到的共同挑战。最后,在§6中,我们讨论进一步发展通用游戏玩法代理的未来开放研究方向。

**感知 **

从游戏世界中感知原始观察并提取信息对于后续的反思和行动选择至关重要。感知的主要功能是将多模态空间转化为代理的输入,这包括视觉(§2.2)、语义(§2.1)和音频。基于文本的游戏主要侧重于玩家之间的沟通和互动,通常通过文本或口语来解谜、揭示隐藏信息或识别角色身份,像狼人杀[83;84]和阿瓦隆[66;38;31]这样的游戏是典型的例子。数字游戏[64;7],通过整合多模态感知渠道,提供了更丰富和更沉浸式的体验,使玩家能够更深入地参与到游戏世界中。然而,不幸的是,现有文献中很少有努力致力于将音频数据整合到LMs的训练中或优化游戏代理。这仍然是未来探索的一个话题(§6)。 **推理 **

由于其在支持自主性、反应性、主动性和社交功能[81]方面的潜力,LMs被认为是智能代理认知框架的核心组成部分。 不同的游戏阶段呈现出不同的需求。 在游戏的初始阶段,代理需要吸收基本的常识和游戏特定的背景知识(通过预训练或即时感知)。在游戏过程中,代理的角色扩展到综合过去的游戏事件、管理知识存储和检索(§3.1),以及承担核心认知功能,如信息学习(§3.2)、推理(§3.3)、决策制定(§3.4)和反思(§3.5)。此外,代理不断更新或改善其知识库以应对未来的挑战。 **行动 **

在这一节中,我们将探讨LMs如何在游戏环境中展现出类似人类的行动,包括特定行为的执行(§4.1)、与人类或其他代理的交流(§4.2),以及如何确保这些行动的一致性(§4.3)。这些代理利用生成式编程技术、与环境的互动反馈以及与其他代理或人类玩家的复杂对话交换来执行任务和解决游戏中的挑战。 LMAs在游戏中操作的行动空间可以大致分为三种不同的类型,每种类型都有其独特的挑战和交互与控制的机会。这些类别范围从纯粹的语言参与到直接操纵游戏控制,不仅定义了LMAs可用的行动范围,也塑造了用于导航它们的策略和技术。i) 文本基础交互。第一个类别包括纯粹的语言交互,主要关注玩家之间的语言沟通和互动。这些游戏,如狼人杀(例如,[83])和阿瓦隆(例如,[66]),围绕对话、决策制定和文本信息的解释。在这些环境中,LMAs需要理解和生成自然语言,通过文本与玩家和游戏叙事进行交流。这要求对语言细微差别、玩家意图的深刻理解,以及制定可以影响游戏结果的响应能力。ii) API或预定义行动。第二个类别涉及通过APIs或预定义行动操纵游戏环境,提供了一种更结构化的游戏机制方法。示例包括在Voyager中使用Mineflayer JavaScript API进行动作控制[64],以及GITM选择通过手写脚本实现的结构化动作[94]。这种方法需要理解游戏的机制,并能够策略性地选择和序列化行动以实现期望的结果,但受益于游戏特定API提供的额外语义和控制。iii) 通过IO操作的直接控制。第三个类别代表了最沉浸式的交互形式:仅通过输入设备,如鼠标和键盘的直接控制。VPT[5]和Cradle[62]使用与用户相同的IO设备操作,例如,鼠标和键盘,其输入空间在视觉观察(§2.2)中讨论。这种方法最接近模拟人类游戏体验,LMAs在更高的抽象层级执行行动,导航菜单,和操纵物品,就像人类玩家一样。这代表了一种更通用的交互形式,需要大量的认知处理和运动技能的整合。这些类别展示了LMAs在游戏中的多功能性和潜力,从文本游戏的纯认知和语言挑战到直接控制的物理和战术需求。