图怎么用强化学习?东北大学最新《图强化学习》综述论文,54页pdf阐述GRL方法、数据与应用

【导读】图学习与强化学习如何结合是个重要的问题,来自东北大学的学者最近发布了《图强化学习》综述,总结了GRL方法的方法描述、开源代码和基准数据集,非常值得关注!

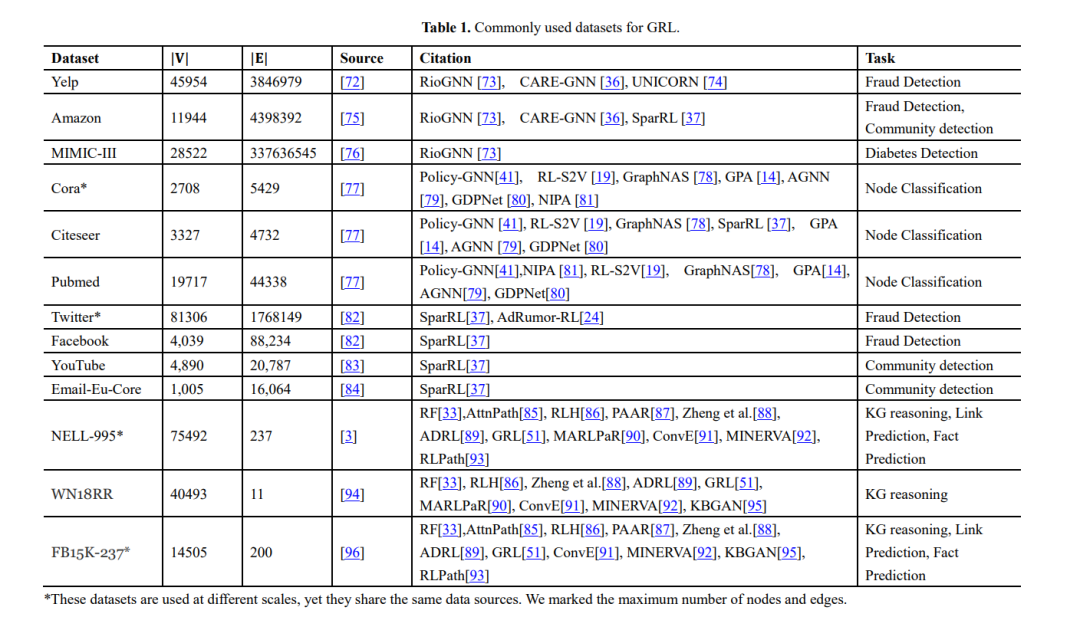

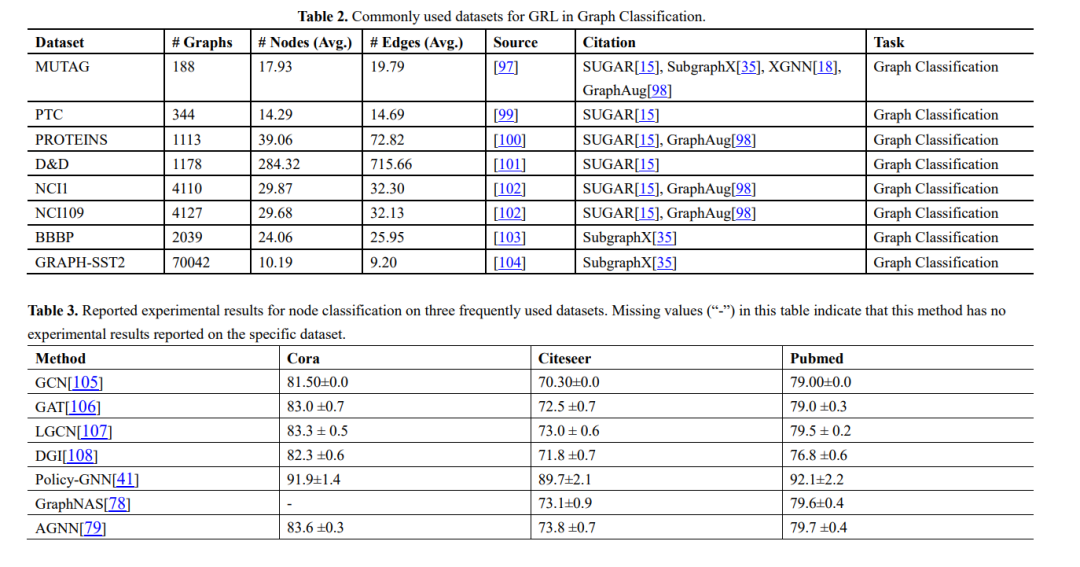

图挖掘任务产生于许多不同的应用领域,包括社交网络、交通运输、电子商务等,近年来受到了理论和算法设计界的极大关注。在图数据挖掘任务中,使用正在研究中的强化学习(RL)技术进行了一些开创性的工作。然而,这些图挖掘算法和RL模型分散在不同的研究领域,难以对不同的算法进行比较。在本综述中,我们提供了RL模型和图挖掘的全面概述,并将这些算法推广到图强化学习(GRL)作为一个统一形式化。我们进一步讨论了GRL方法在各个领域的应用,并总结了GRL方法的方法描述、开源代码和基准数据集。最后,提出了未来可能需要解决的重要方向和挑战。这是对GRL文献进行全面考察的最新成果,为学者提供了一个全球视野,也为该领域以外的学者提供了学习资源。此外,我们为想要进入这个快速发展的领域的感兴趣的学者和想要比较GRL方法的专家创建了一个在线开源软件。

https://www.zhuanzhi.ai/paper/19dae52fbe743dda12652a7f8348f790

引言

本文的主要贡献如下:

-

全面综述 。本文对现代图数据的GRL技术进行了系统和全面的综述,并根据RL方法的研究领域和特点对GRL文献进行了分类,这些方法专注于用RL解决图数据挖掘问题。 -

最近的文献 。我们总结了最近关于GRL的工作,并对现实世界的应用进行了研究。通过此次综述,我们希望能为图挖掘和RL社区提供一个有用的资源和全局视角。 -

未来的发展方向 。讨论了GRL研究的新方向,并提出了六个可能的未来研究方向:自动化RL、分层RL、多智能体RL、子图模式挖掘、可解释性和评价指标。 -

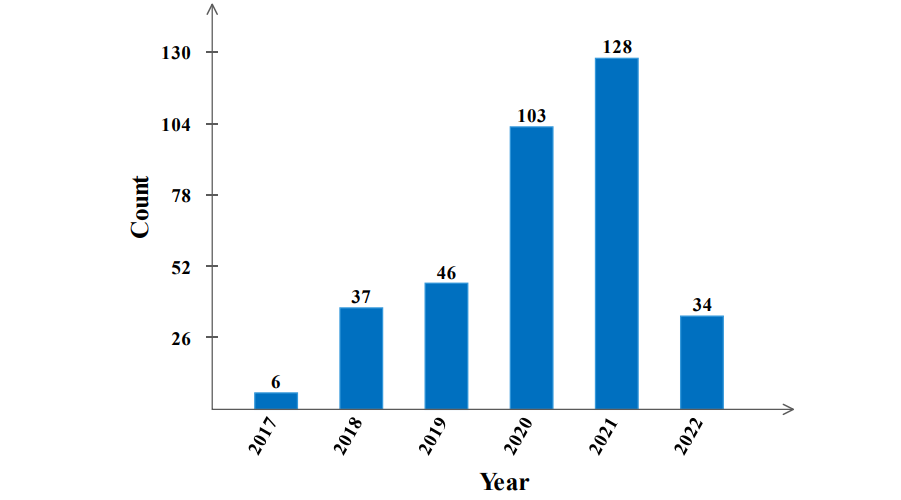

资源丰富 。我们收集了关于GRL的丰富资源,包括最先进的模型、基准数据集和开源代码。我们为GRL创建了一个开源的资源库,其中包含了近年来关于GRL的大量论文,按出版年份进行分类。在这个开源的资源库中,我们提供了论文和代码的链接(可选),让学者们更快的了解研究进展和方法,并为GRL的研究提供更多的灵感。

本综述的其余部分组织如下。第二节简要介绍了本文讨论的图数据挖掘概念,并简要回顾了GRL研究中常用的关键算法。在第三节中,我们回顾了目前关于GRL的一些研究,并列出了该研究的状态、行动、奖励、终止、RL算法和评价指标。在第四部分,我们讨论并提出了一些未来的研究方向和挑战。最后,我们在第5节对本文进行了总结。

图挖掘强化学习

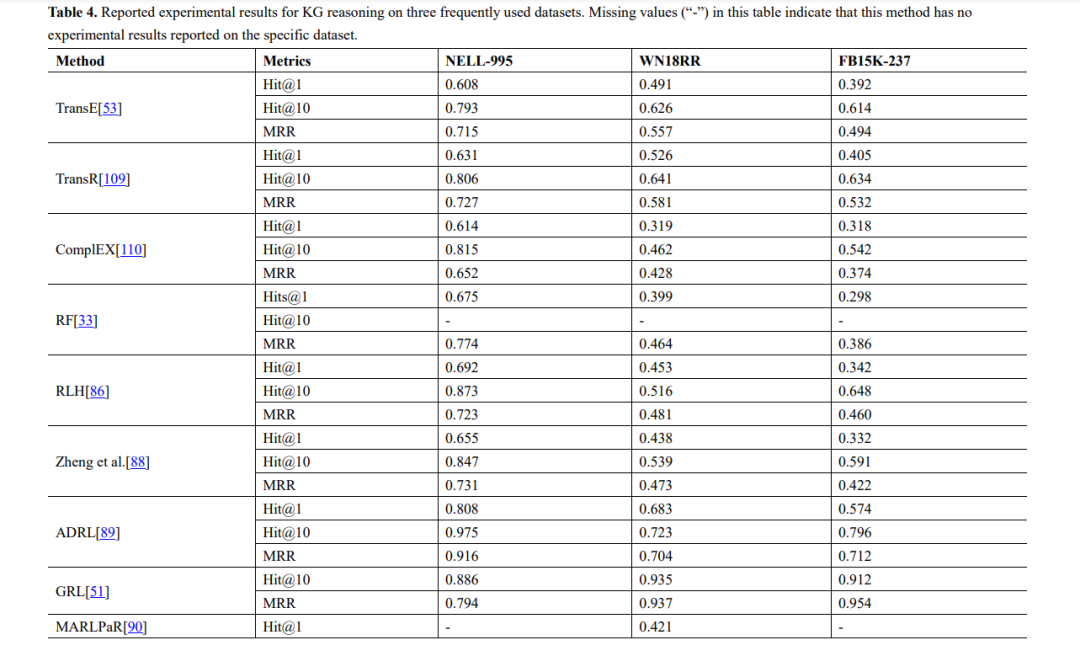

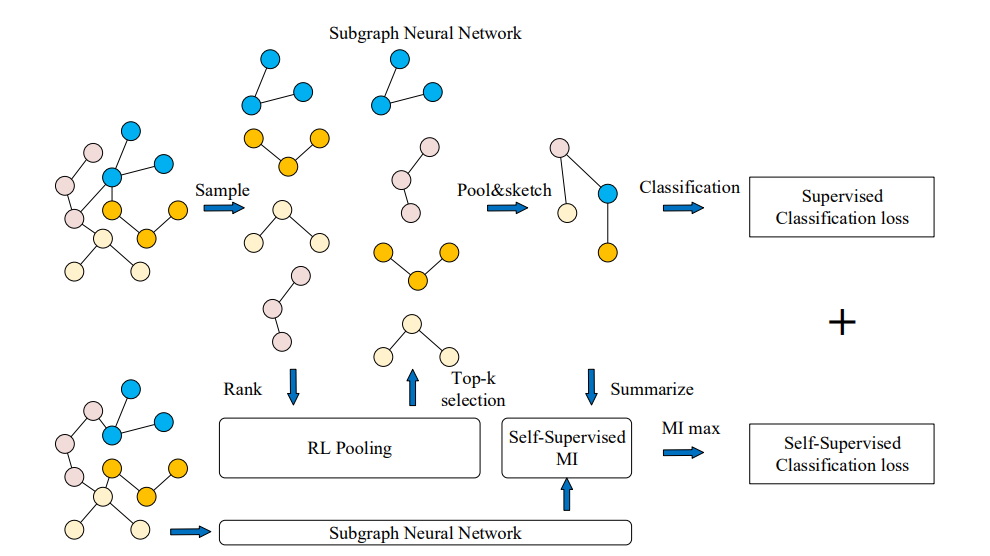

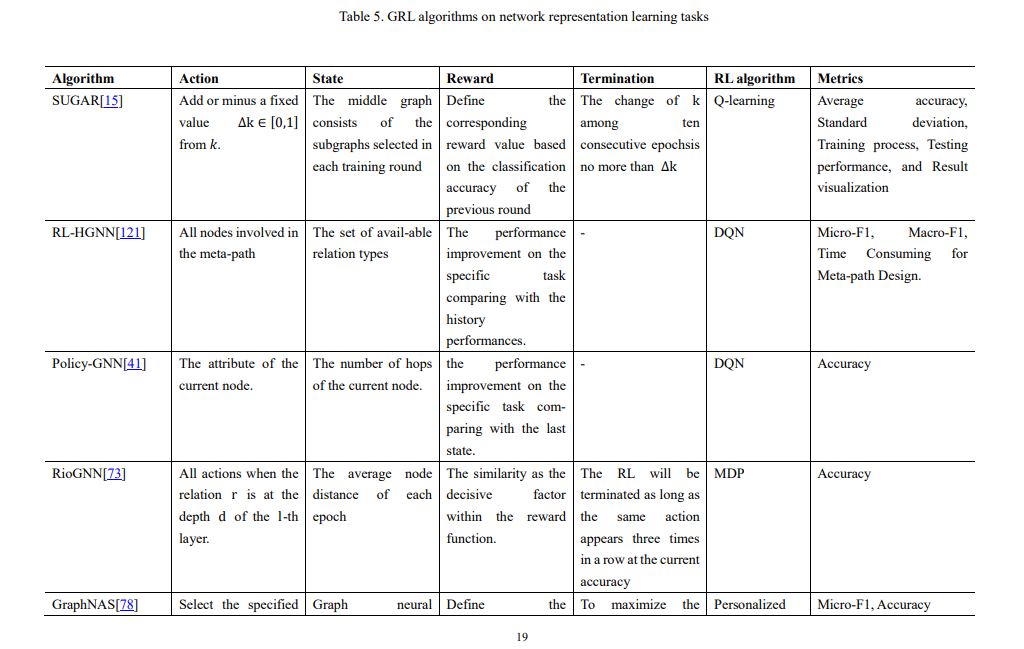

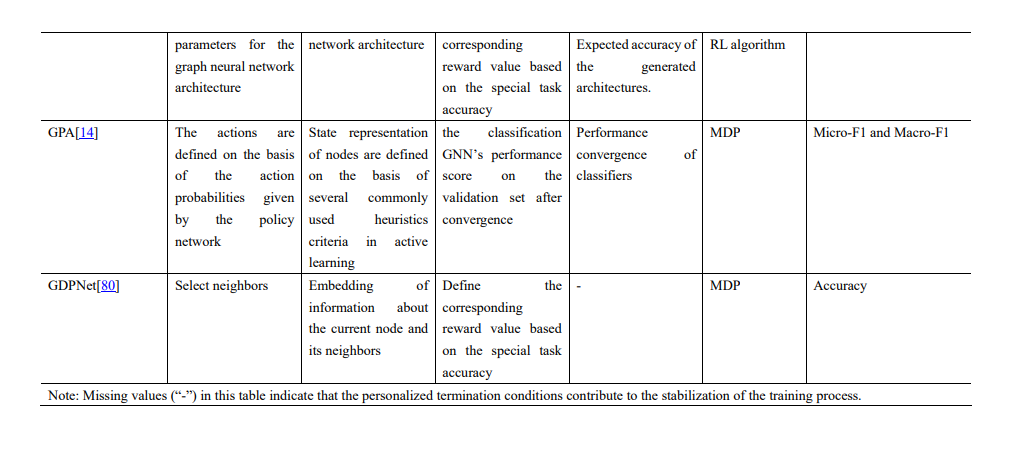

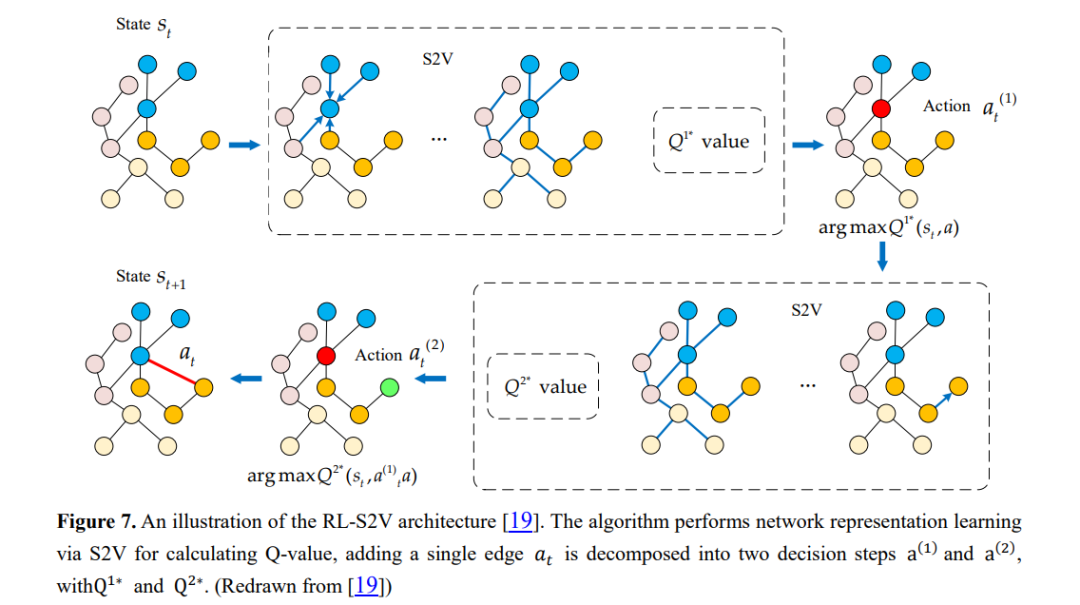

网络表示学习是学习一种映射,将图的节点嵌入为低维向量,同时编码各种结构和语义信息。这些方法旨在优化表示,使嵌入空间中的几何关系保持原始图的结构[111,112]。得到的向量表示可以有效支持节点分类、节点聚类、链接预测和图分类等广泛任务[113,114]。现有的网络嵌入方法[15]普遍存在三个问题: (1) 特征识别能力差。融合所有的特征和关系来获得一个总体的网络表示,往往会带来过度平滑的潜在问题,导致图的特征难以区分。(2) 对先验知识的需求。以相似度量或主题的形式保存结构特征总是基于启发式,并需要大量的先验知识。(3) 低explainability。许多方法通过逐步池化来利用子结构,这会丢失大量详细的结构信息,并导致下游任务缺乏足够的可解释性。为了解决上述问题,SUGAR[15]通过Q-learning自适应地选择有意义的子图来表示图的区别性信息,从而保留了“节点-子图-图”级别的结构信息,这种分层学习方法提供了强大的表示、泛化和可解释性。

RL方法在从观测数据中发现因果关系方面取得了良好的效果,但在有向无环图空间中搜索因果关系或发现因果关系的隐含条件往往具有较高的复杂性。发现和理解因果机制可以定义为寻找能够最小化已定义分数函数的DAG。具有随机策略的智能体可以在学习策略的不确定性信息的基础上自动定义搜索策略,并利用奖励信号进行快速更新。因此,Zhu等[123]提出利用RL从图空间中寻找底层的DAG,而不需要平滑的评分函数。该算法采用Actor-Critic作为搜索算法,输出训练过程中生成的所有图中,得到奖励最好的图。然而,该方法存在计算分数较差的问题,由有向图组成的动作空间通常难以完全探索。Wang等人[124]通过将RL方法整合到基于排序的范式中,提出了基于排序的强化学习(CORL)方法的因果发现。该方法将排序搜索问题描述为一个多步骤MDP,并采用编码器-解码器结构实现排序生成过程,最后基于对每个排序设计的奖励机制,使用RL对所提出的模型进行优化。然后使用变量选择对生成的排序进行处理,以获得最终的因果图。

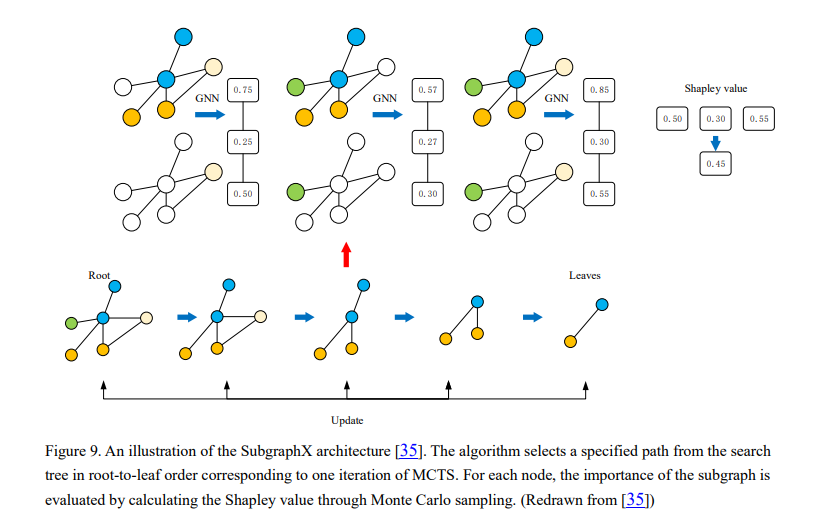

可解释性

城市服务

传染病控制

组合优化

医药

虽然目前学者们已经探索并提出了几种GRL方法,但我们认为该领域仍处于起步阶段,具有很大的探索空间和研究价值,并提出了该领域学者可能感兴趣的一些未来研究方向。

自动强化学习

层次强化学习

多智能体强化学习

子图模式挖掘

图强化学习可解释性

图强化学习评估

结论

网络科学已经发展成为一个跨学科的领域,跨越了物理学、经济学、生物学和计算机科学,具有许多关键的现实世界的应用,并使复杂系统中的实体交互的建模和分析成为可能[170]。在本次综述中,我们对GRL中最先进的方法进行了全面的概述,提出了针对不同图数据挖掘任务的各种解决策略,其中RL方法可以结合起来更好地解决现有的挑战。虽然GRL方法已经在很多领域得到了应用,但更高效的RL与优秀的图神经网络模型的深入结合,有望提供更好的泛化和可解释性,提高对样本复杂度的处理能力。我们希望这次综述能够帮助学者们理解GRL的关键概念,并推动该领域在未来的发展。我们认为,GRL方法可以在日益增长的图结构数据中揭示有价值的信息,使学者和工程师能够更清晰地分析和利用图结构数据。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GRL54” 就可以获取《图怎么用强化学习?东北大学最新《图强化学习》综述论文,54页pdf阐述GRL方法、数据与应用》专知下载链接