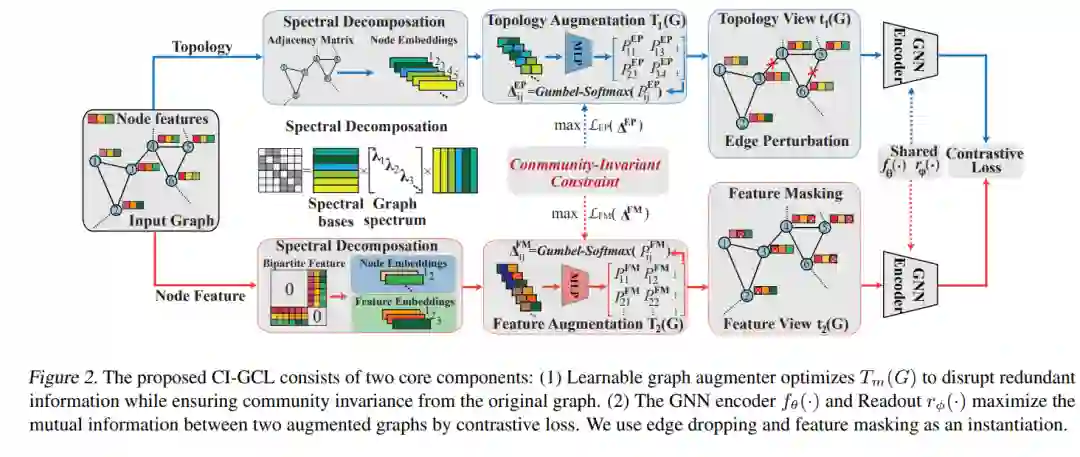

近年来,图增强在图对比学习(GCL)中受到了广泛关注,以学习具有良好泛化性的节点/图表示。然而,主流的GCL方法常常偏爱随机破坏图进行增强,这种方法的泛化能力有限,并且不可避免地会破坏高级图信息,即图社区。此外,当前基于知识的图增强方法只能关注拓扑或节点特征之一,导致模型对各种类型的噪声缺乏鲁棒性。为了解决这些限制,本研究探讨了图社区在图增强中的作用,并发现了其对可学习图增强的关键优势。基于我们的观察,我们提出了一个社区不变的GCL框架,以在可学习的图增强过程中保持图社区结构。通过最大化光谱变化,该框架统一了拓扑和特征增强的约束,增强了模型的鲁棒性。在21个基准数据集上的实证证据展示了我们框架的独特优势。代码已在Github上发布[https://github.com/CI-GCL.git]。

成为VIP会员查看完整内容