【UCLA】动态图表示学习,40页ppt,Dynamic Graph Representation Learning

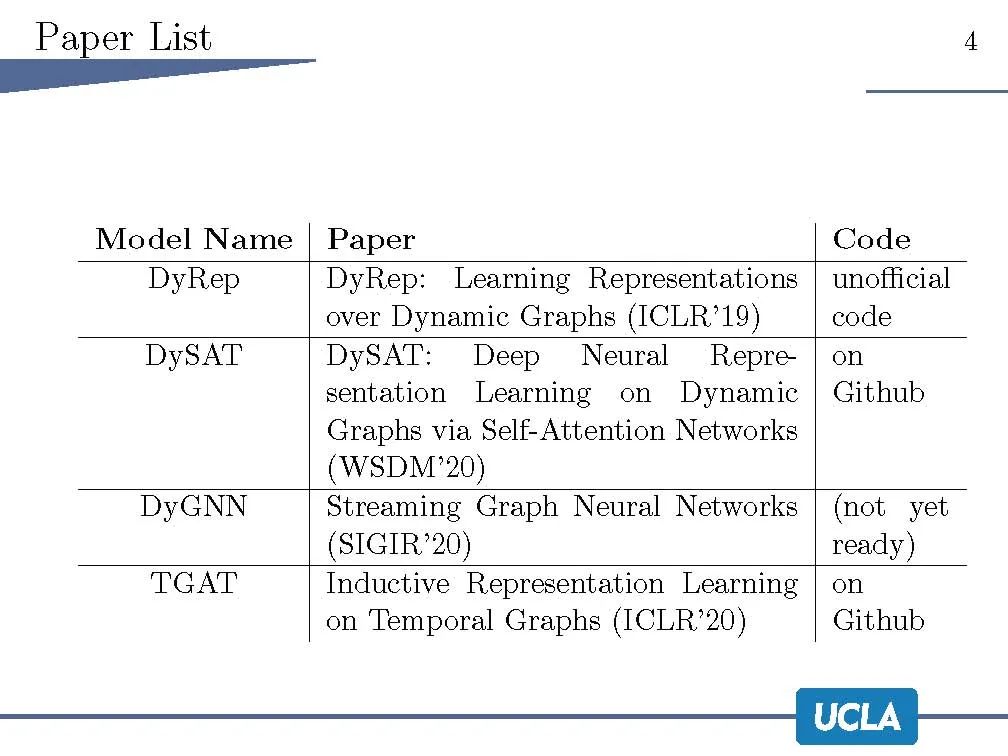

在许多现实世界的应用中,包括社交网络、推荐系统、本体论、生物学和计算金融,图表自然地出现了。传统上,图的机器学习模型大多是为静态图设计的。然而,许多应用程序都涉及到图形的演变。这为学习和推理带来了重要的挑战,因为节点、属性和边会随着时间而变化。在这一报告中,我们回顾了最近的进展表示学习动态图,包括动态知识图谱。我们从编码器和解码器的角度来描述现有的模型,根据它们所使用的技术对这些编码器和解码器进行分类,并对每一类的方法进行分析。我们也回顾了几个突出的应用和广泛使用的数据集,并强调了未来的研究方向。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DGRL” 就可以获取《【UCLA】动态图表示学习,40页ppt,Dynamic Graph Representation Learning》专知下载链接

登录查看更多

相关内容

表示学习是通过利用训练数据来学习得到向量表示,这可以克服人工方法的局限性。 表示学习通常可分为两大类,无监督和有监督表示学习。大多数无监督表示学习方法利用自动编码器(如去噪自动编码器和稀疏自动编码器等)中的隐变量作为表示。 目前出现的变分自动编码器能够更好的容忍噪声和异常值。 然而,推断给定数据的潜在结构几乎是不可能的。 目前有一些近似推断的策略。 此外,一些无监督表示学习方法旨在近似某种特定的相似性度量。提出了一种无监督的相似性保持表示学习框架,该框架使用矩阵分解来保持成对的DTW相似性。 通过学习保持DTW的shaplets,即在转换后的空间中的欧式距离近似原始数据的真实DTW距离。有监督表示学习方法可以利用数据的标签信息,更好地捕获数据的语义结构。 孪生网络和三元组网络是目前两种比较流行的模型,它们的目标是最大化类别之间的距离并最小化了类别内部的距离。

专知会员服务

147+阅读 · 2019年12月16日