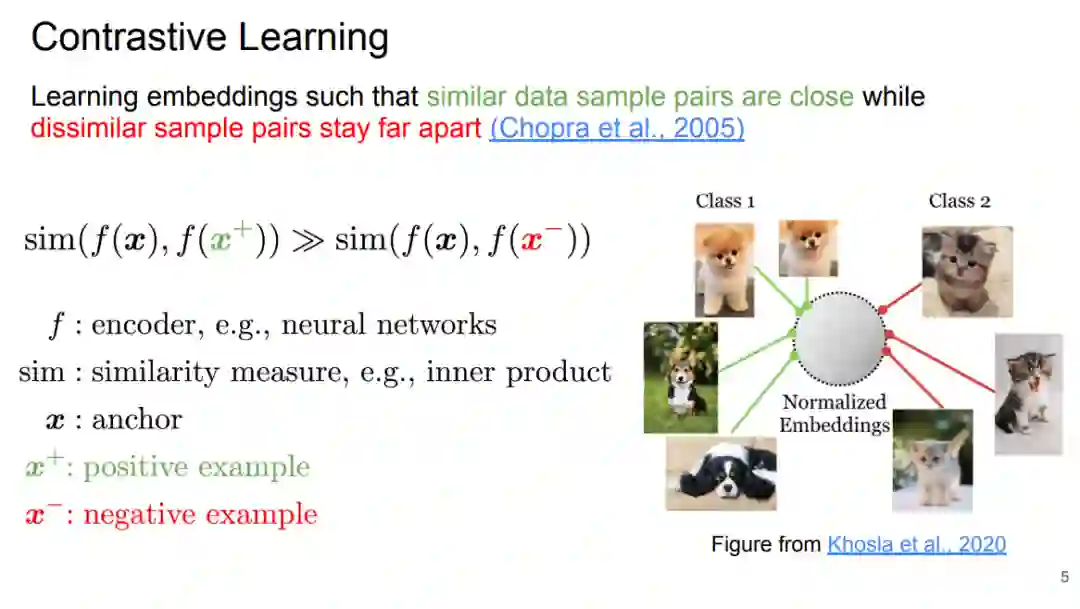

目前的自然语言处理模型严重依赖有效的表示学习算法。对比学习就是这样一种学习嵌入空间的技术,它使相似的数据样本对具有相近的表示,而不同的样本彼此相距遥远。它可以用于监督或非监督设置,使用不同的损失函数来产生特定于任务的或通用的表示。虽然它最初使视觉任务的成功成为可能,但近年来,关于对比NLP的工作越来越多。这一第一行的工作不仅在各种NLP任务中提供了有前景的性能改进,而且还提供了所需的特性,如任务不可知的句子表示、忠实的文本生成、零样本和少样本设置下的数据高效学习和可解释性。

在本教程中,我们将温柔地介绍对比学习方法的基本原理及其背后的理论。然后,我们调研了对比学习对各种下游NLP应用的好处和最佳实践,包括文本分类、问题回答、摘要、文本生成、可解释性和可解释性、常识知识和推理、视觉和语言。

本教程旨在帮助自然语言处理和计算语言学领域的研究人员理解这一新兴主题,并推动将对比学习用于自然语言处理应用的未来研究方向。

https://contrastive-nlp-tutorial.github.io/

对比学习基础 Part 1: Foundations of Contrastive Learning Contrastive Learning Objectives Contrastive Data Sampling and Augmentation Strategies Successful Applications Analysis of Contrastive Learning NLP对比学习 Part 2: Contrastive Learning for NLP Contrastive Learning in NLP Tasks Task-agnostics Representation Faithful Text Generation Data-efficient Learning Interpretability and Explainability

经验教训与未来 Part 3: Lessons Learned, Practical Advice, and Future Directions Lessons Learned Practical Advice Future Directions

讲者: