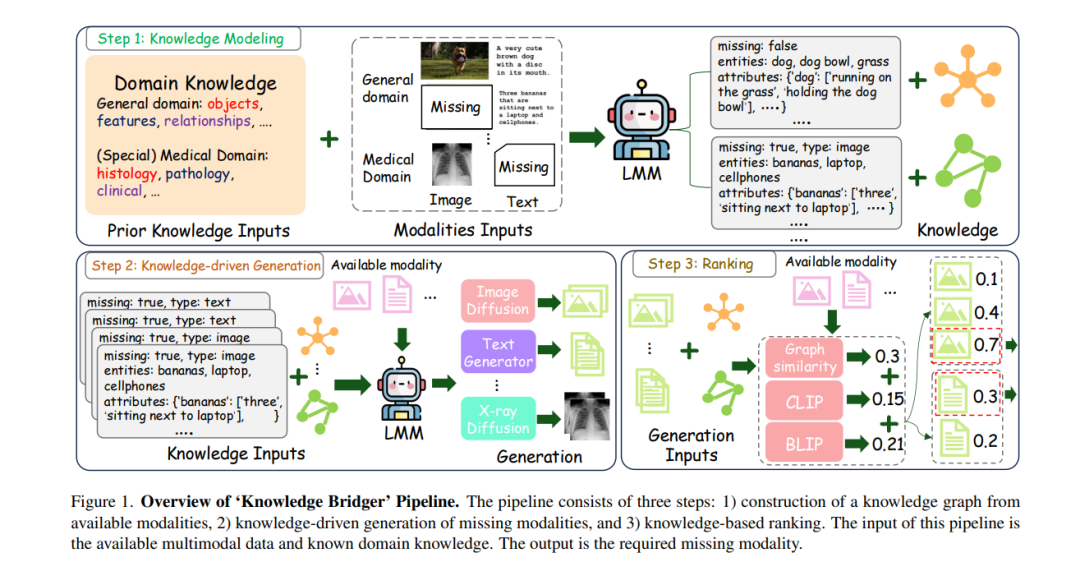

![]() **以往成功的缺失模态补全方法依赖于精心设计的融合技术和在完整数据上的大量预训练,这可能限制其在领域外(OOD)场景中的泛化能力。**在本研究中,我们提出了一个新的挑战:我们能否开发出一种既高效又能应对OOD泛化的缺失模态补全模型?为了解决这一问题,我们提出了一种无需训练的缺失模态补全框架,该框架利用大型多模态模型(LMM)。我们的方法被称为“知识桥接器”(Knowledge Bridger),具有模态不可知性,并结合了缺失模态的生成与排序。通过定义领域特定的先验知识,我们的方法能够自动从现有模态中提取结构化信息,并构建知识图谱。这些提取的图谱通过LMM连接缺失模态的生成与排序模块,从而实现高质量的缺失模态插补。在一般领域和医学领域的实验结果表明,我们的方法始终优于其他竞争方法,尤其在OOD泛化方面表现突出。此外,我们基于知识的生成与排序技术在生成和排序方面优于直接使用LMM的变体,为其他领域的应用提供了有价值的见解。

**以往成功的缺失模态补全方法依赖于精心设计的融合技术和在完整数据上的大量预训练,这可能限制其在领域外(OOD)场景中的泛化能力。**在本研究中,我们提出了一个新的挑战:我们能否开发出一种既高效又能应对OOD泛化的缺失模态补全模型?为了解决这一问题,我们提出了一种无需训练的缺失模态补全框架,该框架利用大型多模态模型(LMM)。我们的方法被称为“知识桥接器”(Knowledge Bridger),具有模态不可知性,并结合了缺失模态的生成与排序。通过定义领域特定的先验知识,我们的方法能够自动从现有模态中提取结构化信息,并构建知识图谱。这些提取的图谱通过LMM连接缺失模态的生成与排序模块,从而实现高质量的缺失模态插补。在一般领域和医学领域的实验结果表明,我们的方法始终优于其他竞争方法,尤其在OOD泛化方面表现突出。此外,我们基于知识的生成与排序技术在生成和排序方面优于直接使用LMM的变体,为其他领域的应用提供了有价值的见解。

![]()