历史趋势无法完全决定AI的未来走向。尽管本系列报告首篇强调历史经验的重要性,但仍可通过主动选择塑造未来。期望《应对AI合规挑战(下篇):防范未来风险》能指导决策者在避免重蹈覆辙的同时,培育社会对AI系统的信任。

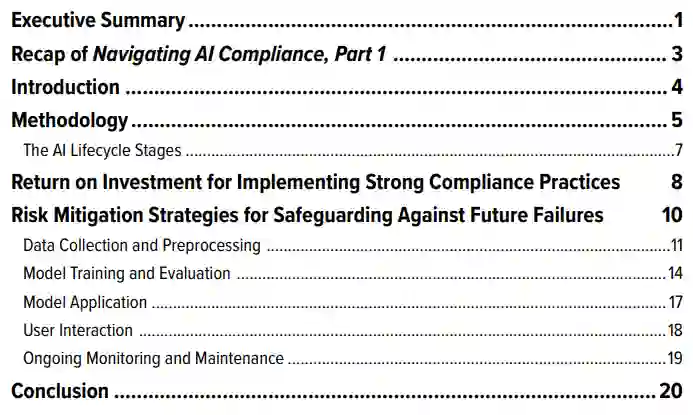

作为系列报告的第二部分,本文提出39项风险缓解策略(详见《防范未来风险的缓解策略》),旨在规避AI系统的制度性、流程性与性能性故障。这些策略致力于增强用户对AI系统的信任并最大化产品效用。AI构建者与使用者(包括AI实验室、部署AI系统的企业及州与地方政府)可根据需求与风险承受度,选择性实施22项技术导向与17项政策导向的策略。

通过落实这些实践,相关机构不仅能降低监管风险、构建产品信任度,还将获得吸引顶尖人才、提升竞争优势、改善财务表现与延长方案生命周期的综合效益。基于研究及利益相关方调研结果,我们向AI构建者与使用者重点推荐39项策略中的以下九项核心建议:

» 实施分级合规措施应对高影响AI应用:AI构建者与使用者需针对敏感或高影响领域(如国家安全、医疗、金融等关键行业)的AI系统开发部署,根据预期用途、潜在风险与应用场景(从娱乐至关键领域)的差异,制定分级的合规方案。

» 认知并管控AI开发部署的可接受风险:应将意外后果与合规失败区别对待。开发方、构建者与监管机构需在考量攻击面扩大及AI未知特性引发的风险阈值时,明确承认非预期影响的客观存在。

» 优先落实数据管理与隐私保护实践:采用隐私保护技术、内容溯源功能与用户授权机制等措施,可缓解流程性故障,在遵守数据法规的同时维护用户权益与信任。

» 部署强健网络安全防护体系:通过网络安全控制、红队测试、故障保护机制等手段,抵御针对AI系统的攻击,并在多元场景中提升系统可靠性。安全护栏设计可同步预防性能性与流程性故障。

» 运用安全风险评估机制前瞻性规避危害:建立涵盖事件报告框架与全生命周期AI安全基准的评估流程,在危害发生前识别并缓解风险,有效应对流程性与性能性双重故障。

» 开展全员合规与AI素养培训:从数据供应商至模型开发者与部署者的全AI供应链员工,均需接受强制性培训。所有涉及AI工具使用的员工应通过培训掌握基础AI素养技能。

» 构建透明度机制强化信任基础:采用模型卡片、数据卡片与信息披露框架等透明化与可解释性工具,是建立用户/利益相关方信任、落实问责机制与支撑知情决策的必要条件。

» 优化AI可解释性与披露框架:通过强化系统可解释性并配套模型评估披露机制,使构建者与使用者深入理解AI行为模式与输出逻辑,从而防范性能性故障。

» 推行非歧视性AI保障策略:在模型训练、数据采集与持续监测环节实施偏差缓解策略,结合对抗性去偏技术,可预防性能性故障,确保系统公平性并消除歧视性结果。