【新书】分布式强化学习,280页pdf

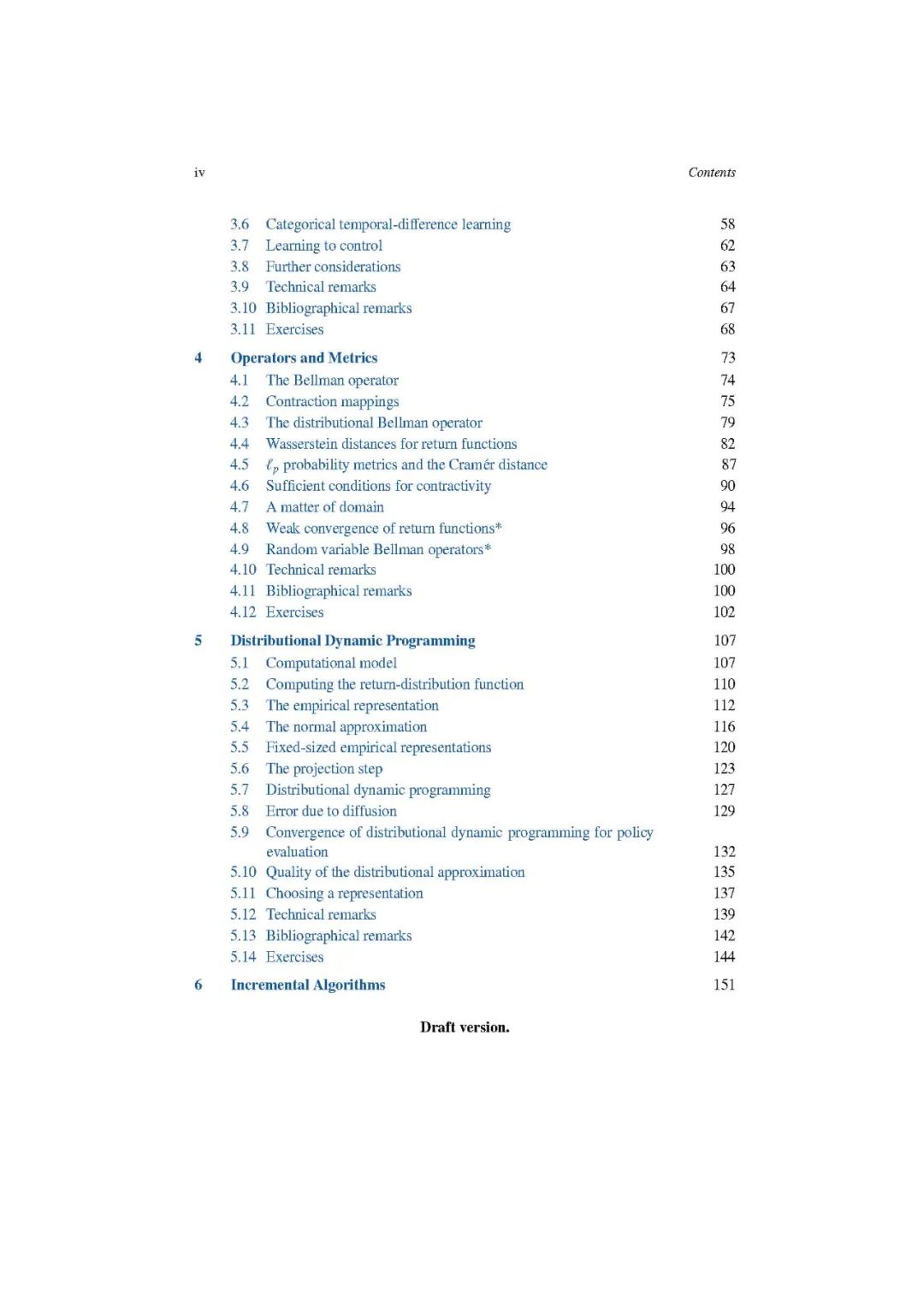

本书分为三个部分。第一部分介绍了分布式强化学习的构建模块。我们首先介绍了我们的基本研究对象,收益分布和分布Bellman方程(第二章)。第三章介绍了分类时间差分学习,一种简单的学习收益分布的算法。在第三章结束时,读者应该理解分布式强化学习的基本原则,并且应该能够在简单的实际设置中使用它。

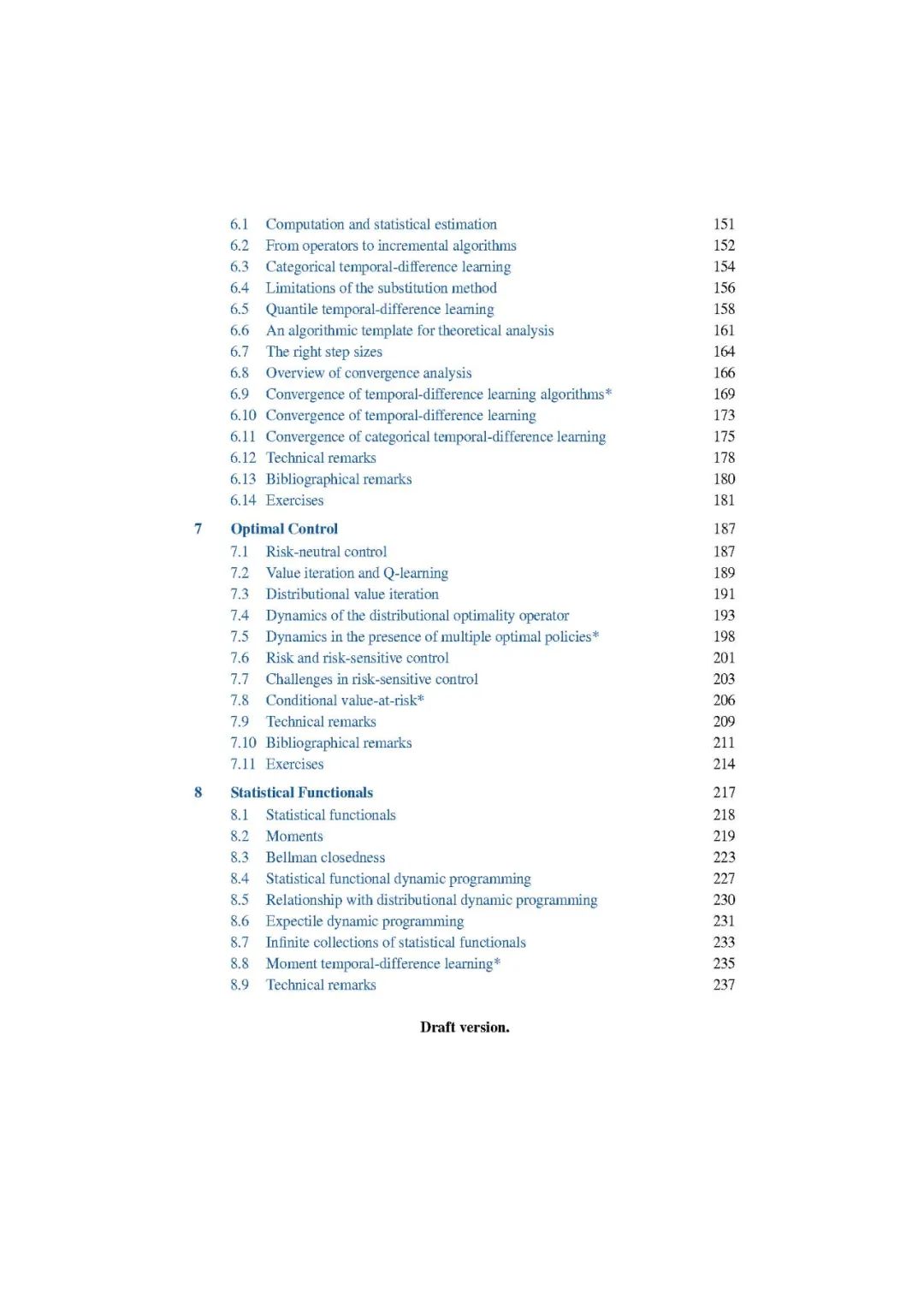

第二部分是对分布式强化学习理论的发展。第4章介绍了一种用于测量返回分布之间距离的语言,以及与这些分布交互的操作符。第5章介绍了实现分布式强化学习所需的概率表示的概念;在此基础上,研究了用这种表示来计算和近似收益分布的问题,并引入了分布动态规划的框架。第6章研究了如何从样本中以增量的方式学习返回分布,给出了类别时间差分学习的正式结构,以及其他算法,如分位数时间差异学习。第7章将这些思想扩展到最优决策的设置(也称为控制设置)。最后,第8章介绍了基于统计泛函概念的分布强化学习的不同视角。在第二部分结束时,读者应该理解在设计分布式强化学习算法时出现的挑战,以及解决这些挑战的可用工具。

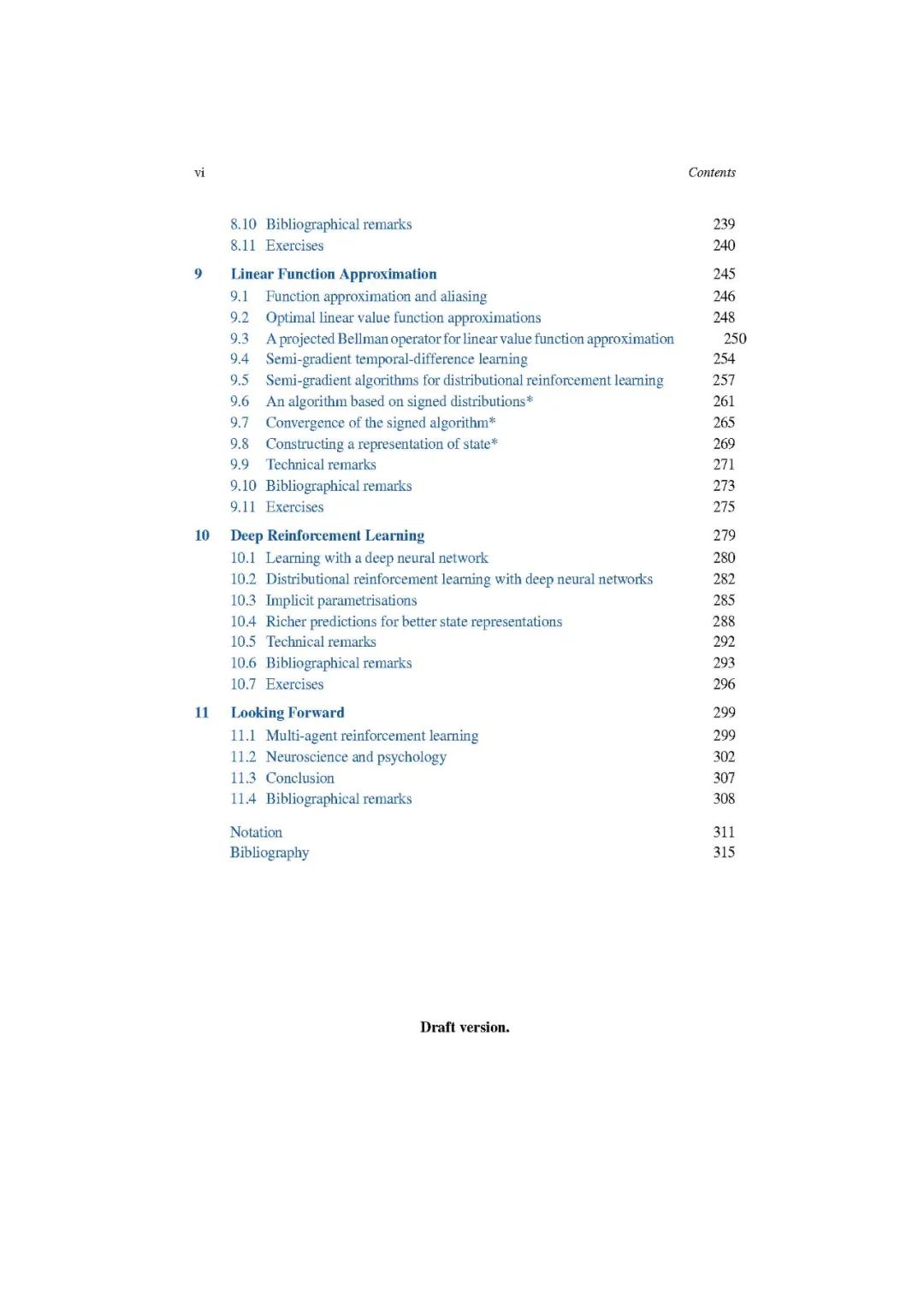

第三部分和最后一部分为实际场景ios开发了分布式强化学习。第九章回顾了线性值函数逼近的原理,并将这些思想推广到分布环境中。第10章讨论了如何将分布方法与深度神经网络相结合来获得深度强化学习的算法,并提出了一个模型来研究这种结合所产生的现象。第11章讨论了分布式强化学习在两个进一步研究领域(多主体学习和神经科学)的新兴应用,并得出结论。

https://www.distributional-rl.org/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“D280” 就可以获取《【新书】分布式强化学习,280页pdf》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月20日

Arxiv

0+阅读 · 2022年4月19日

Arxiv

17+阅读 · 2021年7月10日