先进人工智能(AI)与当代各部门和各行业的融合不仅仅是技术升级,更是一场具有深远影响的变革。本文探讨了与先进人工智能在社会、经济和政治系统中的快速融合相关的结构性风险概念。这一框架挑战了主要关注人工智能直接威胁(如事故和误用)的传统观点,并提出这些更近似的风险是相互关联的,并受到更大的社会技术系统的影响。通过分析技术进步与社会动态之间的复杂互动,本研究确定了结构性风险的三个主要类别:前因结构、前因人工智能系统和有害反馈回路。我们提出了一个全面的框架来理解驱动这些风险的因果链,强调了社会规模的结构性力量与误用、系统故障和错位系统扩散等更近似的风险之间的相互依存关系。本文阐述了不加控制的人工智能进步如何重塑权力动态、信任和激励结构,从而导致深刻且往往不可预测的社会变革。介绍了绘制、模拟和推演这些动态的方法论研究议程,旨在让政策制定者和国家安全专业人员做好准备,应对下一代人工智能技术带来的挑战。本文最后提出了政策建议,通过将对人工智能-社会技术关系的细致理解纳入战略规划和国际治理,来降低这些风险。

结构性风险的定义和概念化

技术的开发和应用不是孤立的,而是与人类的需求、动机和环境紧密联系在一起的。人工智能系统尤其如此--经过训练的适应性学习技术,能够与社会和物理世界融合互动。这种社会技术生态通过人机互动不断发展,在改变社会结构(文化、经济和政治)的同时推动技术加速发展(Valverde,2016 年)。因此,研究人员越来越多地从复杂系统的角度来评估人工智能,重点关注其结构、功能以及与平行系统的关系如何影响风险动态(Lazar & Nelson, 2023; Weidinger et al.) 越来越多的文献研究了人工智能在技术、人类和系统层面的安全性,指出了反馈回路(Weidinger 等,2023 年;Anwar 等,2024 年)和社会适应(Bernardi 等,2024 年)的重要性。人工智能治理研究人员将这类风险称为结构性风险:技术如何塑造或被更广泛的环境塑造(Zwetsloot 等人,2019 年;Dafoe,2020 年)。尽管如此,对人工智能结构性风险动态的研究仍然有限,只有战略武器和威慑(Avin & Amadae, 2019; Flournoy et al., 2020; Wong et al., 2020; Johnson et al., 2023)和快速社会变革(Ward, 2022)领域有明显的例外。

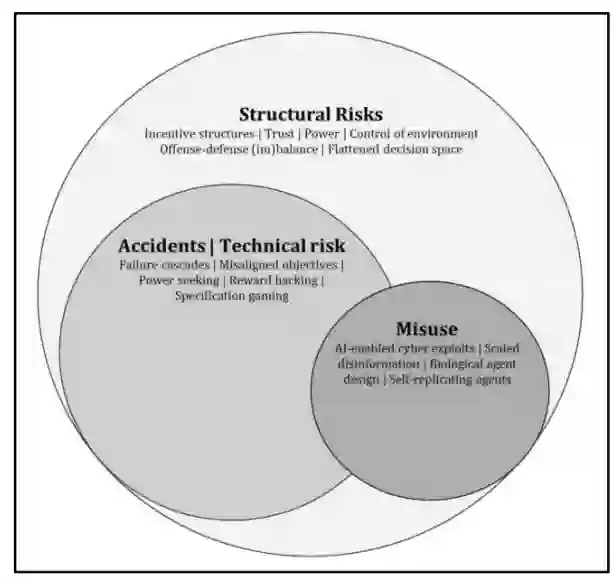

图 1. 人工智能风险格局。事故风险和误用都与自我强化动态有着广泛的重叠。误用人工智能系统会让技术安全问题显现出来,而结构性力量(如经济或地缘政治)会促使未经测试的系统过早发布,改变权力动态(改变攻防平衡),或降低进入门槛。

结构性风险可定义为在更广泛的社会技术系统中开发和部署先进人工智能技术所产生的动态变化,包括互为因果的事件链、激励结构和权力不对称。对结构性风险的研究将分析重点从因果链末端的威胁--近因和事件,如无法控制的美国空军人工智能无人机系统--转移到潜在的结构性力量、它们之间的相互作用以及意想不到的后果。因此,虽然结构性风险有别于人工智能带来的其他更直接的威胁(如目标错位或网络威胁),但它们是其特征和严重性的基础。因此,大多数人工智能风险都具有间接因果途径的结构性基础(图 1)。例如,过早部署一个功能强大、潜在不安全的系统可能会对事故产生直接影响,如系统故障,或部署错位系统,或间接改变进攻-防御力量的对称性(如增强进攻性网络能力),导致国家间关系紧张,甚至冲突。事实上,新能力的提升会影响到更广泛的社会和政治环境,同时也会受其影响。这种框架导致一些研究人员认为,大多数人工智能风险本质上都是结构性的(Krueger,2023 年;Clarke,2022 年)。

为了进一步阐明间接风险这一点,可以考虑采用化石燃料的历史例子。虽然人类使用化石燃料已有数千年的历史,但在 19 世纪,化石燃料的广泛传播造成了人口和工业的爆炸性增长,推动了工业革命的空前发展(Jianfen,2021;Wrigley,2013)。化石燃料使用的外部效应导致了广泛的健康影响(如污染、工厂作业)、城市和国防工业基地的快速扩张以及大气中二氧化碳的持续增加。因此,从第一批燃煤发电厂和铁路到内燃机以及二战前线军事装备的开发和运输,都可以追溯到间接的因果联系(布莱克,2017;达福,2020)。技术如何改变支撑发展和国际安全的结构性力量,推动社会组织和冲突的特征进入二十世纪。

权力动态和对对手的不信任会推动新技术快速融入全球军事,导致以前无法想象的冲突形式,如一战中的无限制潜艇战、闪电战战术,以及二战中第一颗原子弹的使用。虽然技术进步与冲突之间没有直接的因果关系,但惊人的能力确实改变了可能的平衡,而权力不平衡、不信任和维持统治地位的动机又加剧了这种平衡。这些力量会形成危险的反馈循环,扭曲价值结构,加速竞争,增加事故和滥用的风险。在德国决定在一战中实施无限制潜艇战之前,各方都认为在战争中使用这种战术是不可想象的(Gompert,2014);然而,首次使用引发了各方参与,导致美国卷入一战。今天,关于完全自主武器系统的伦理和禁止问题也有类似的讨论(Kallenborn, 2020)。然而,历史的教训表明,新的能力与正确的激励措施相结合,可以从根本上改变可允许性的结构动态。

这些动态的一个当代例子是围绕人工智能发展的经济和地缘政治竞赛动态,推动公司和国家加快部署时间表。另一个例子是社交媒体算法对人类社会组织和决策的影响,导致整个政治制度和个人伤害的转变。此外,对武器系统(战略、战术或指挥控制系统)自主性的信任螺旋式上升,导致紧张局势加剧和技术升级(Avin & Amadea, 2019)。随着系统越来越强大,社会和技术世界变得越来越相互依存,结构性风险可能会出现新的表现形式。事实上,人工智能内容选择算法对青少年自杀或投票行为的影响,在达到人工智能复杂性的特定门槛之前,并没有人注意到。在一些尚未考虑的领域,情况可能也是如此。正如在 1945 年北卡罗来纳州洛斯阿拉莫斯的特尼狄核弹试验之前,核辐射的影响还相对遥远一样,人工智能的结构性风险也存在着一个巨大的、不确定的问题空间,目前还在视线之外。