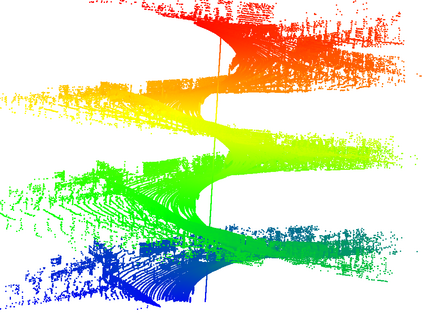

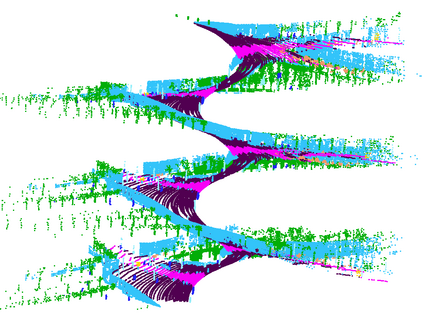

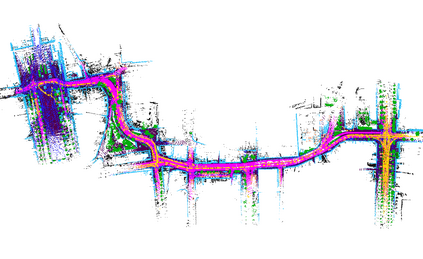

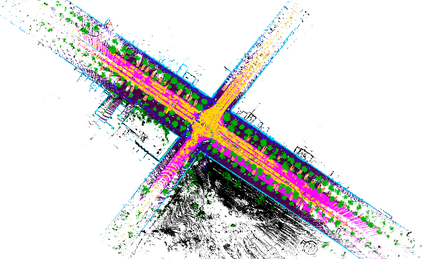

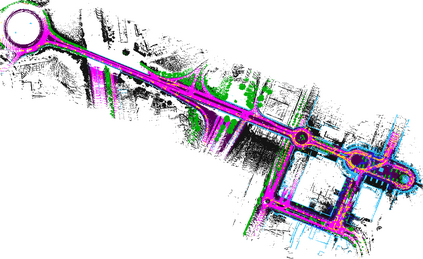

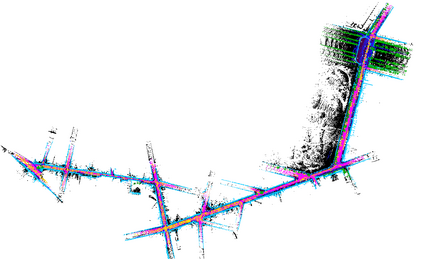

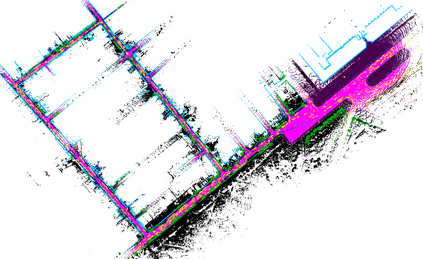

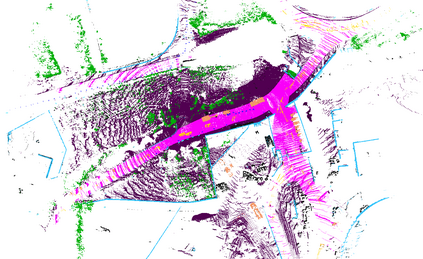

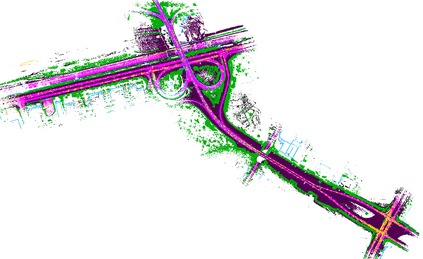

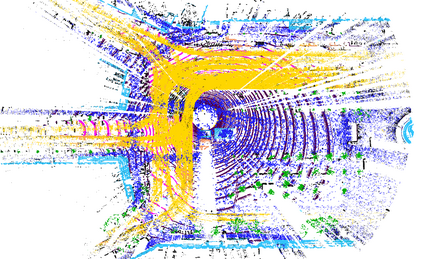

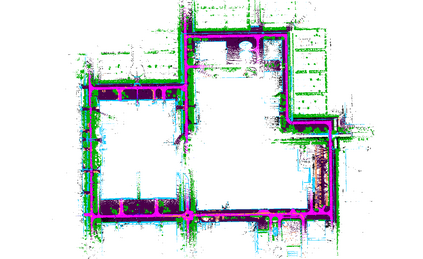

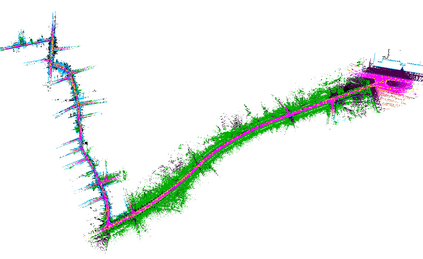

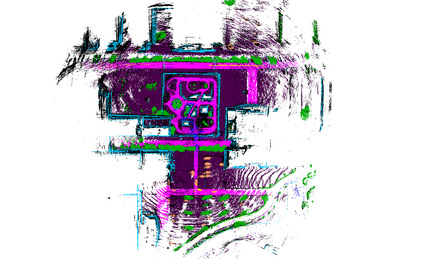

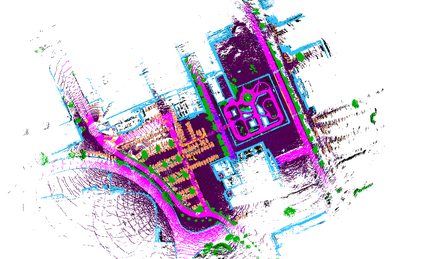

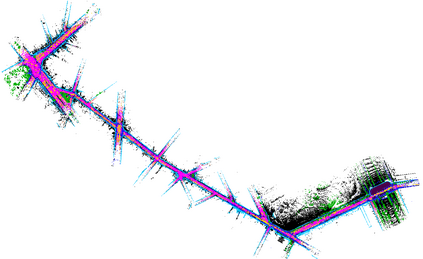

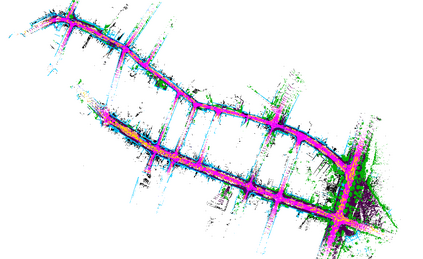

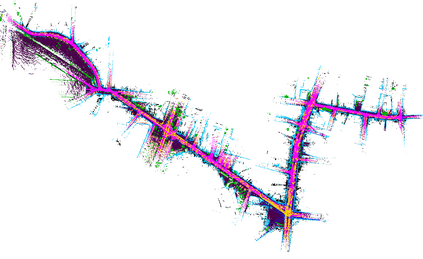

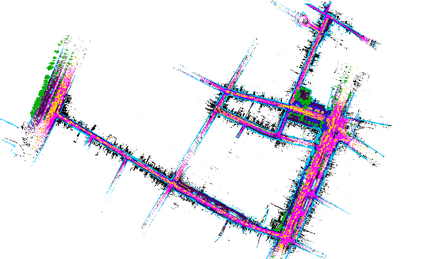

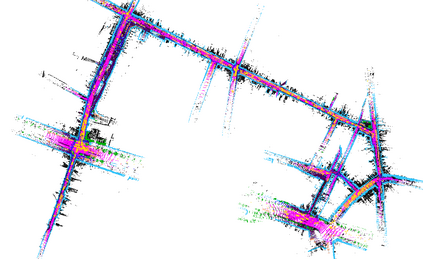

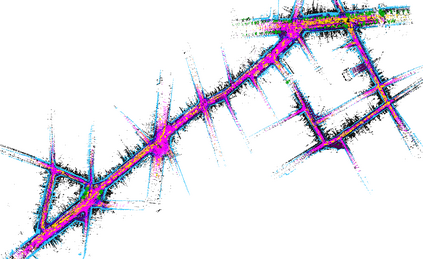

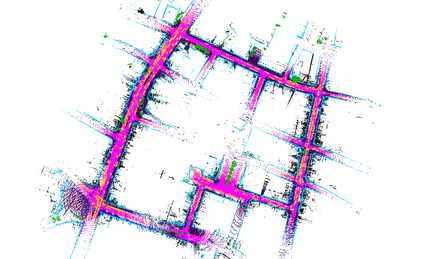

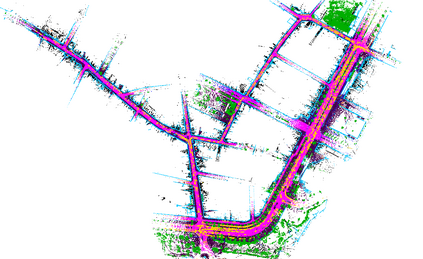

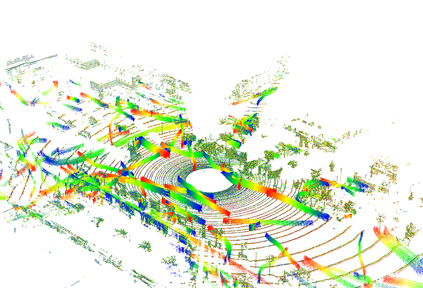

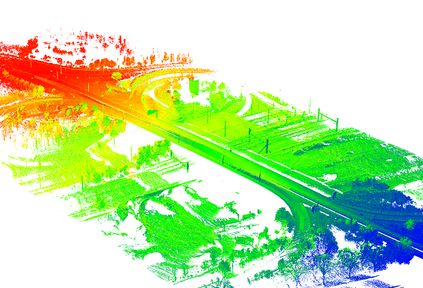

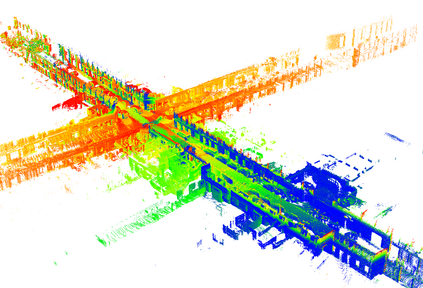

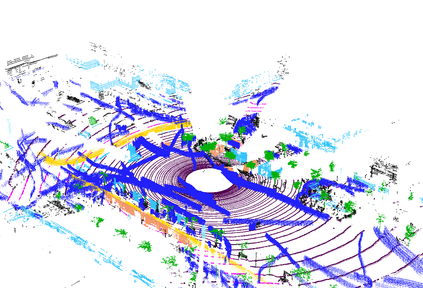

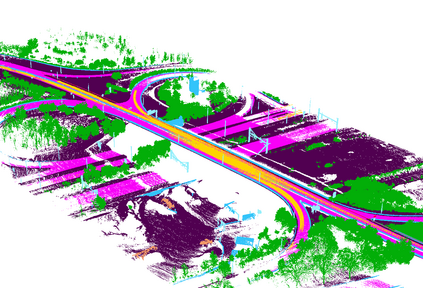

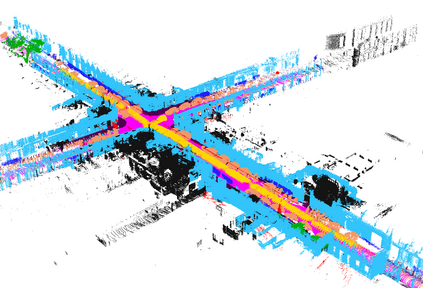

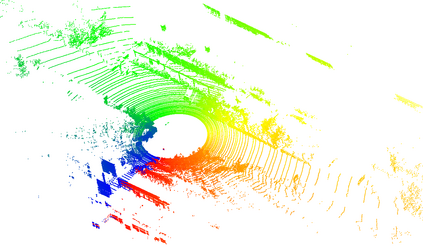

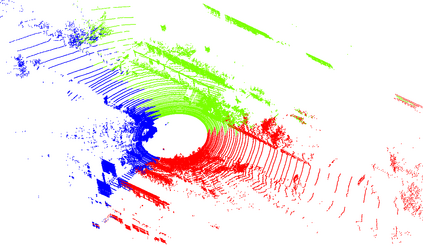

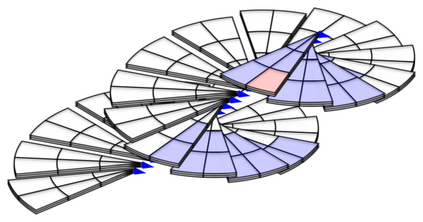

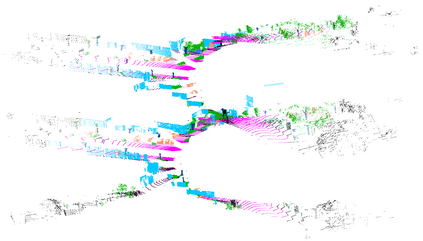

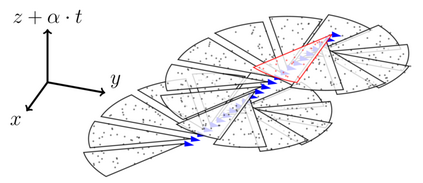

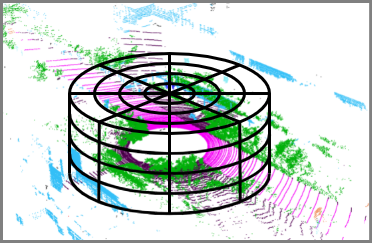

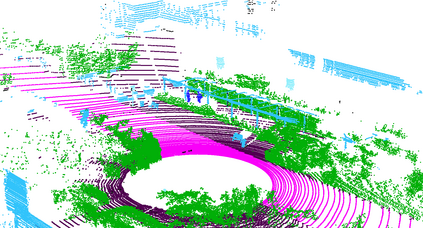

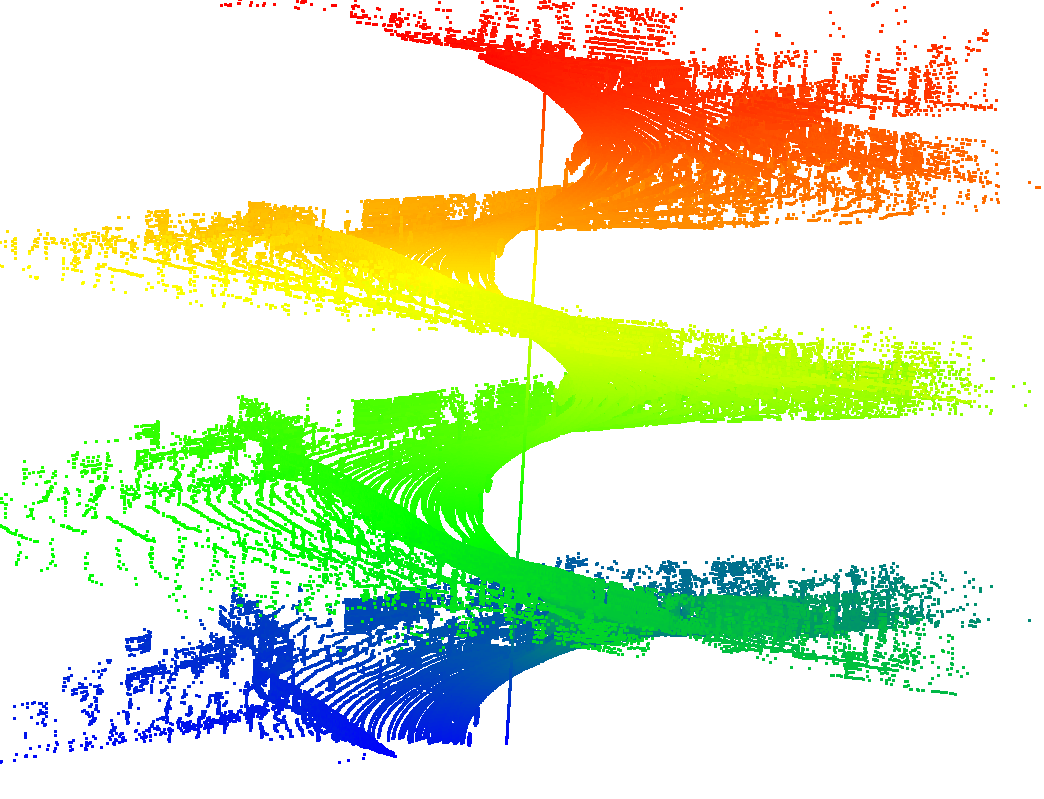

Roof-mounted spinning LiDAR sensors are widely used by autonomous vehicles, driving the need for real-time processing of 3D point sequences. However, most LiDAR semantic segmentation datasets and algorithms split these acquisitions into $360^\circ$ frames, leading to acquisition latency that is incompatible with realistic real-time applications and evaluations. We address this issue with two key contributions. First, we introduce HelixNet, a $10$ billion point dataset with fine-grained labels, timestamps, and sensor rotation information that allows an accurate assessment of real-time readiness of segmentation algorithms. Second, we propose Helix4D, a compact and efficient spatio-temporal transformer architecture specifically designed for rotating LiDAR point sequences. Helix4D operates on acquisition slices that correspond to a fraction of a full rotation of the sensor, significantly reducing the total latency. We present an extensive benchmark of the performance and real-time readiness of several state-of-the-art models on HelixNet and SemanticKITTI. Helix4D reaches accuracy on par with the best segmentation algorithms with a reduction of more than $5\times$ in terms of latency and $50\times$ in model size. Code and data are available at: https://romainloiseau.fr/helixnet

翻译:自动车辆广泛使用Roof- Rood 旋转的LiDAR 传感器。 但是,大多数LiDAR 语义分割数据集和算法将这些获取的数据集分割成360 ⁇ circ$框架,导致获取延迟,与现实的实时应用和评估不相容。 我们用两种关键贡献来解决这个问题。 首先,我们引入HelixNet,一个价值100亿美元的点数据集,配有精细标记、时间印和传感器旋转信息,以便准确评估断段算法的实时准备状态。 其次,我们提议Helix4D,一个专门为旋转LiDAR点序列而设计的紧凑和高效的波段-瞬间变异器结构。 Helix4D 运行于获取切片,与传感器完全旋转的一小部分相对应,大大降低了总亮度。我们提出了HelixNet和Semantictal模型中几个状态模型的性能和实时准备状态的广泛基准。 我们提议Helix4D是最佳断段的精确度,在50D值中,在最大平段内,在最大平段内可以使用。