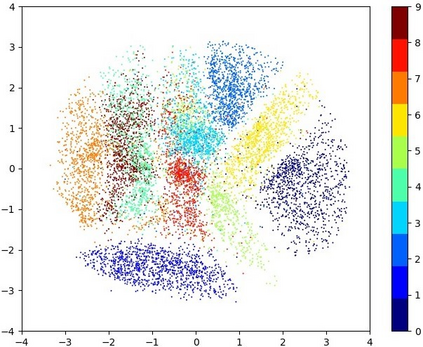

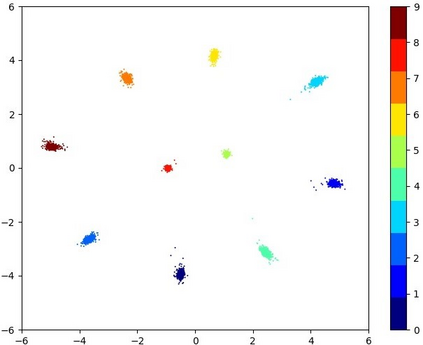

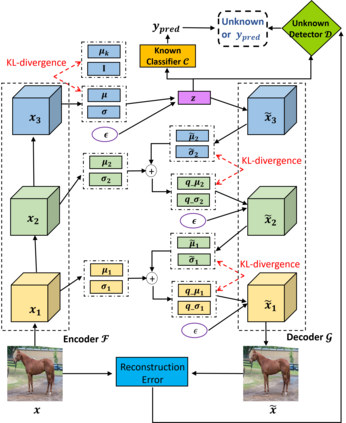

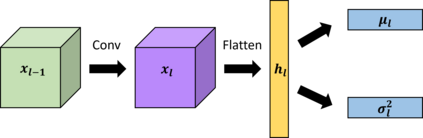

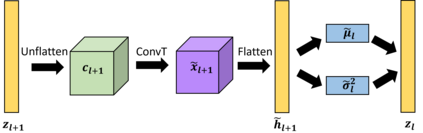

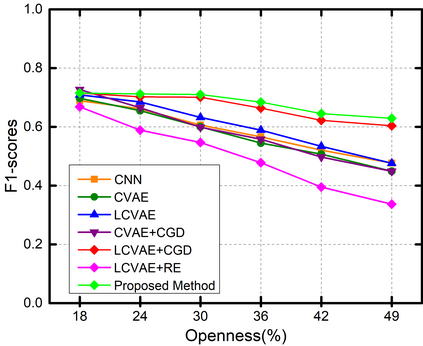

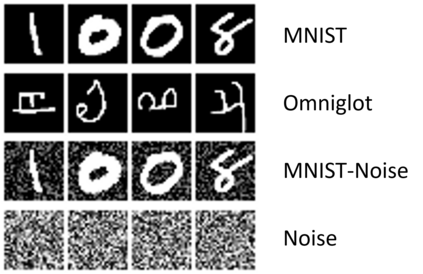

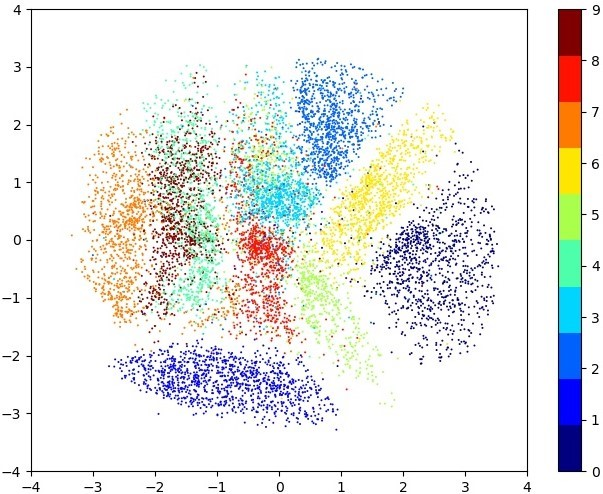

Deep neural networks have achieved state-of-the-art performance in a wide range of recognition/classification tasks. However, when applying deep learning to real-world applications, there are still multiple challenges. A typical challenge is that unknown samples may be fed into the system during the testing phase and traditional deep neural networks will wrongly recognize the unknown sample as one of the known classes. Open set recognition is a potential solution to overcome this problem, where the open set classifier should have the ability to reject unknown samples as well as maintain high classification accuracy on known classes. The variational auto-encoder (VAE) is a popular model to detect unknowns, but it cannot provide discriminative representations for known classification. In this paper, we propose a novel method, Conditional Gaussian Distribution Learning (CGDL), for open set recognition. In addition to detecting unknown samples, this method can also classify known samples by forcing different latent features to approximate different Gaussian models. Meanwhile, to avoid information hidden in the input vanishing in the middle layers, we also adopt the probabilistic ladder architecture to extract high-level abstract features. Experiments on several standard image datasets reveal that the proposed method significantly outperforms the baseline method and achieves new state-of-the-art results.

翻译:深心神经网络在一系列广泛的识别/分类任务中取得了最先进的性能。然而,在对现实世界应用应用深度学习时,仍然存在着多重挑战。一个典型的挑战是,在测试阶段将未知样本输入系统,而传统的深心神经网络错误地承认未知样本是已知类别之一。开放数据集识别是解决这一问题的一个潜在解决办法,开放数据集分类器应有能力拒绝未知样本,并保持已知类别中的高分类精确度。变式自动编码器(VAE)是发现未知物的流行模型,但不能为已知分类提供歧视性的表述。在本文中,我们提出了一种新方法,即 " 有条件高斯分布学习 " (CGDL),以公开确认。除了探测未知样本外,这种方法还可以通过将不同潜伏特征逼近不同的高斯模型来对已知样本进行分类。同时,为了避免输入中层时隐藏的信息,我们还采用了稳定梯结构架构来提取高层次的抽象特征,但不能为已知分类提供有区别的特征。在本文件中,我们提出了一种新的方法,通过实验方法将一些标准图像显示新的方法。