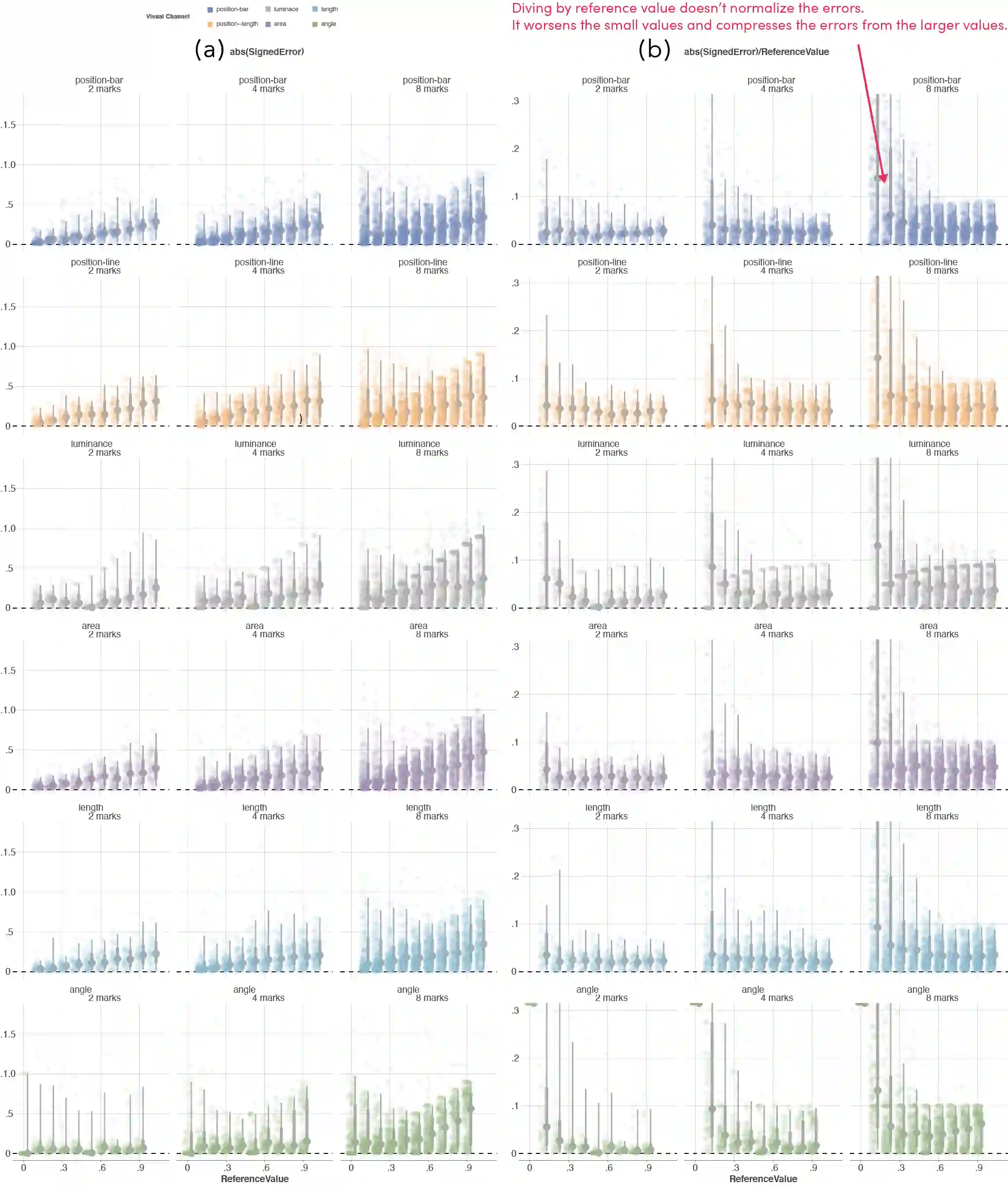

Data can be visually represented using visual channels like position, length or luminance. An existing ranking of these visual channels is based on how accurately participants could report the ratio between two depicted values. There is an assumption that this ranking should hold for different tasks and for different numbers of marks. However, there is little existing work testing assumption, especially given that visually computing ratios is relatively unimportant in real-world visualizations, compared to seeing, remembering, and comparing trends and motifs, across displays that almost universally depict more than two values. We asked participants to immediately reproduce a set of values from memory. With a Bayesian multilevel modeling approach, we observed how the relevant rank positions of visual channels shift across different numbers of marks (2, 4 or 8) and for bias, precision, and error measures. The ranking did not hold, even for reproductions of only 2 marks, and the new ranking was highly inconsistent for reproductions of different numbers of marks. Other factors besides channel choice far more influence on performance, such as the number of values in the series (e.g. more marks led to larger errors), or the value of each mark (e.g. small values are systematically overestimated). Recall was worse for displays with 8 marks than 4, consistent with established limits on visual memory. These results show that we must move beyond two-value ratio judgments as a baseline for ranking the quality of a visual channel, including testing new tasks (detection of trends or motifs), timescales (immediate computation, or later comparison), and the number of values (from a handful, to thousands).

翻译:可以通过位置、 长度或亮度等视觉频道来显示数据。 这些视觉频道的现有排名基于参与者如何精确地报告两个描述的值之间的比例。 假设这种排名应该用于不同的任务和不同的标记数量。 但是, 现有的工作测试假设很少, 特别是考虑到在现实世界的视觉化中,视觉计算比率相对不重要, 与视觉、 记忆和比较不同, 显示的显示几乎普遍地描述两个以上的值。 我们要求参与者立即从记忆中复制一套数值。 通过一种巴伊西亚多级别模型方法, 我们观察视觉频道的相关级别位置如何在不同数量( 2、 4 或 8) 之间移动, 以及偏差、 偏差、 精确和误差衡量。 现有的工作测试假设, 即使在复制2 马克时, 新的排序也非常不一致。 其它因素除了频道选择对业绩的影响要大得多, 例如系列中的数值( 例如, 更多的标记导致更大的误差), 我们观察了不同的视觉频道的相关级别位置位置位置位置位置位置, 或者每个标记的数值值值值比 更差( ), 直观的排序, 直观的顺序的排序,, 直观的比 直观的比 直观的比 的 直观 直观 的 的 的 的 直观的 直观 的 的 的 的 直观的 直观的 直观的 直观 直观 的 的 的 的 的 的 的 的 直观 直观 的 的 的 的 的 的 直观 的 直观 的 的 直观 的 的 直观 直观 的 的 的 的 的 的 的 的 直观 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 直观 直观 直观 直观 的 直观 的 的 的 的 直 直 的 的 的 的 的 的 直 直 直 直 直 直 等 直 直 直 直 直 直 直 直