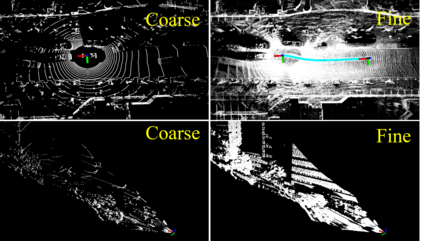

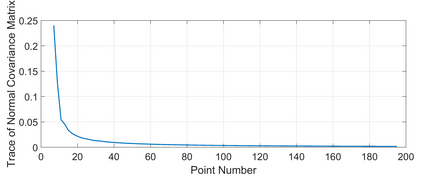

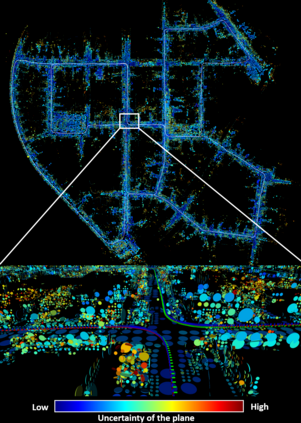

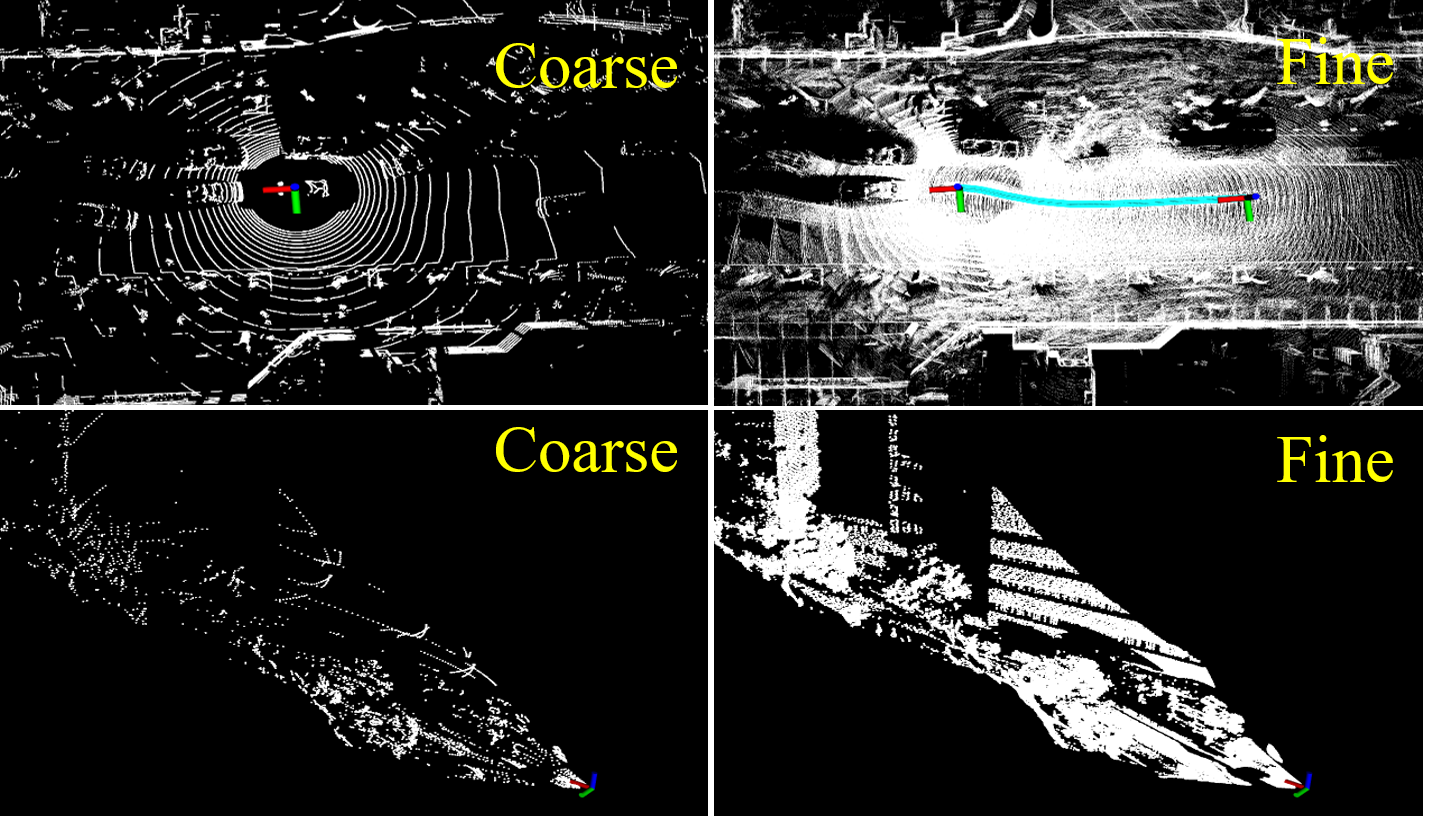

This paper proposes an efficient and probabilistic adaptive voxel mapping method for LiDAR odometry. The map is a collection of voxels; each contains one plane (or edge) feature that enables the probabilistic representation of the environment and accurate registration of a new LiDAR scan. We further analyze the need for coarse-to-fine voxel mapping and then use a novel voxel map organized by a Hash table and octrees to build and update the map efficiently. We apply the proposed voxel map to an iterated extended Kalman filter and construct a maximum a posteriori probability problem for pose estimation. Experiments on the open KITTI dataset show the high accuracy and efficiency of our method compared to other state-of-the-art methods. Outdoor experiments on unstructured environments with non-repetitive scanning LiDARs further verify the adaptability of our mapping method to different environments and LiDAR scanning patterns. Our codes and dataset are open-sourced on Github

翻译:本文为LiDAR odography 提出了一个高效和概率适应的 voxel voxel 绘图方法。 地图是一份 voxel (或边缘) 的集合; 每张地图都包含一个平面( 或边缘) 特征, 能够对环境进行概率描述并准确登记新的 LiDAR 扫描。 我们进一步分析粗向松散的 voxel 绘图的必要性, 然后用由Hash 表格和octrees 组织的小巧的 voxel 地图来高效地构建和更新地图。 我们将拟议的 voxel 地图应用到一个迭代的扩展 Kalman 过滤器, 并构建一个最大的事后概率问题来做出估计。 在开放的 KITTI 数据集上进行的实验显示,我们的方法与其他最先进的方法相比具有很高的准确性和效率。 在无结构环境中进行非重复扫描 LiDAR 的外部实验, 进一步核查我们的绘图方法对不同环境和LDAR 扫描模式的适应性。 我们的代码和数据集是在 Github 上开源的。