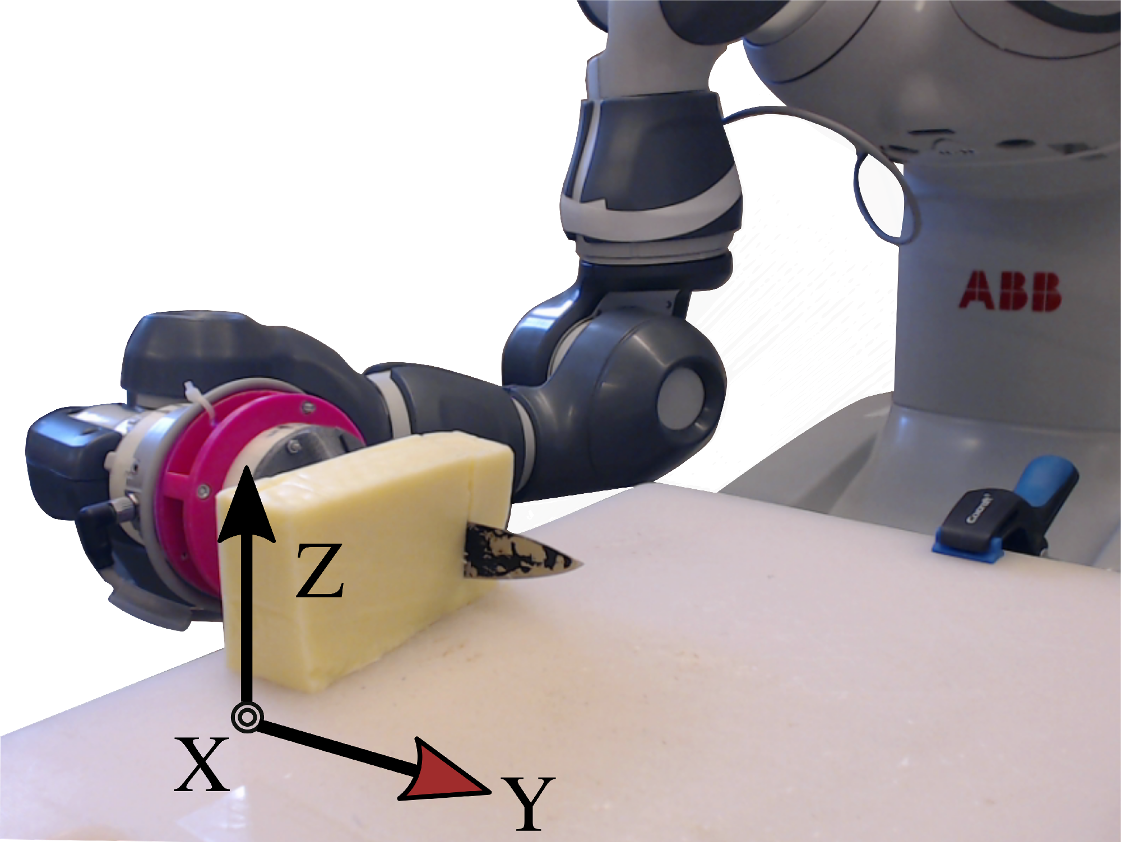

Data-driven approaches for modelling contact-rich tasks address many of the difficulties that analytical models bear. For real-world scenarios, the hardware capabilities constrain the available measurements and consequently, every step of the problem's formulation. In this work, we propose a formulation that encapsulates knowledge from a baseline controller for the contact-rich task of food-cutting. Based on this formulation, we employ deep networks to model the dynamics within a model predictive controller. We design a training process based on curriculum training with learning rate decay for multi-step predictions, which are essential for receding horizon control. Experimental results demonstrate that even with a simple architecture, our model achieves consistently good predictive performance on known and unknown object classes and exhibits a good understanding of the long term dynamics.

翻译:以数据驱动的方法模拟接触丰富的任务,解决了分析模型带来的许多困难。对于现实世界的情景,硬件能力制约了现有测量,因此也制约了问题的每一个步骤。在这项工作中,我们提出了一个提法,将知识从接触丰富的食物切割任务的基准控制器中包含在内。基于这一提法,我们利用深层网络在模型预测控制器中模拟动态。我们设计了一个基于课程培训的培训过程,对多步骤预测进行学习率衰减,这对降低地平线控制至关重要。实验结果表明,即使有了简单的结构,我们的模型仍然在已知和未知的物体类别上取得一贯良好的预测性能,并展示了对长期动态的良好了解。