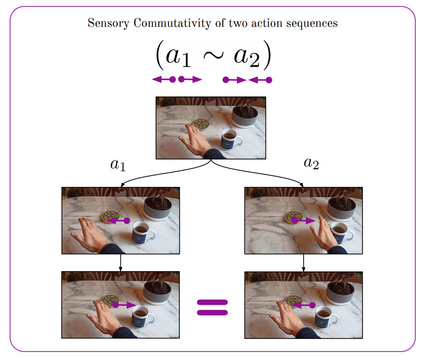

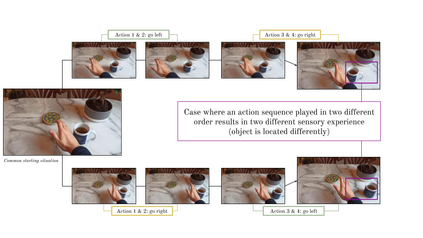

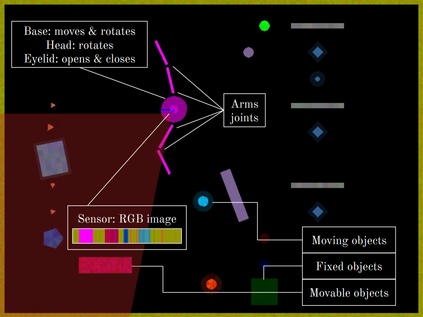

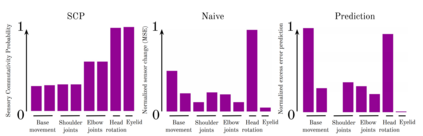

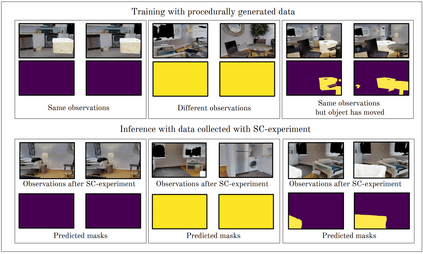

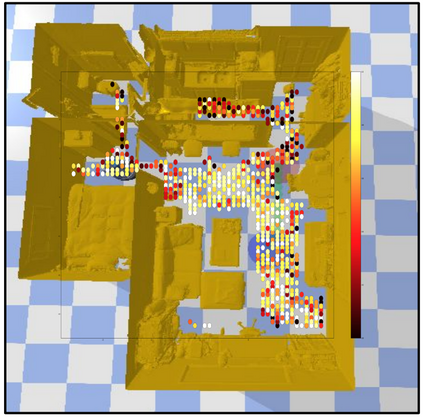

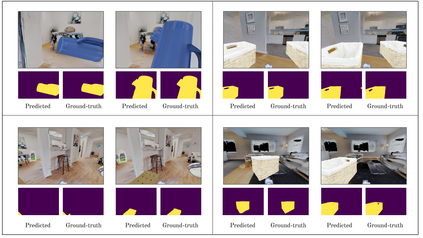

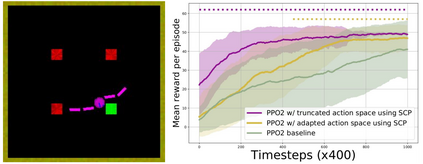

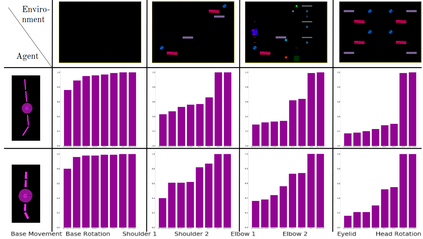

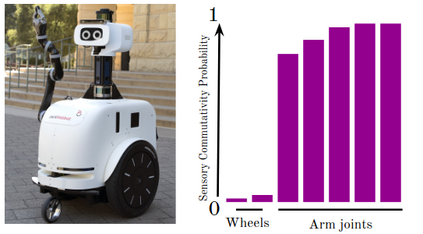

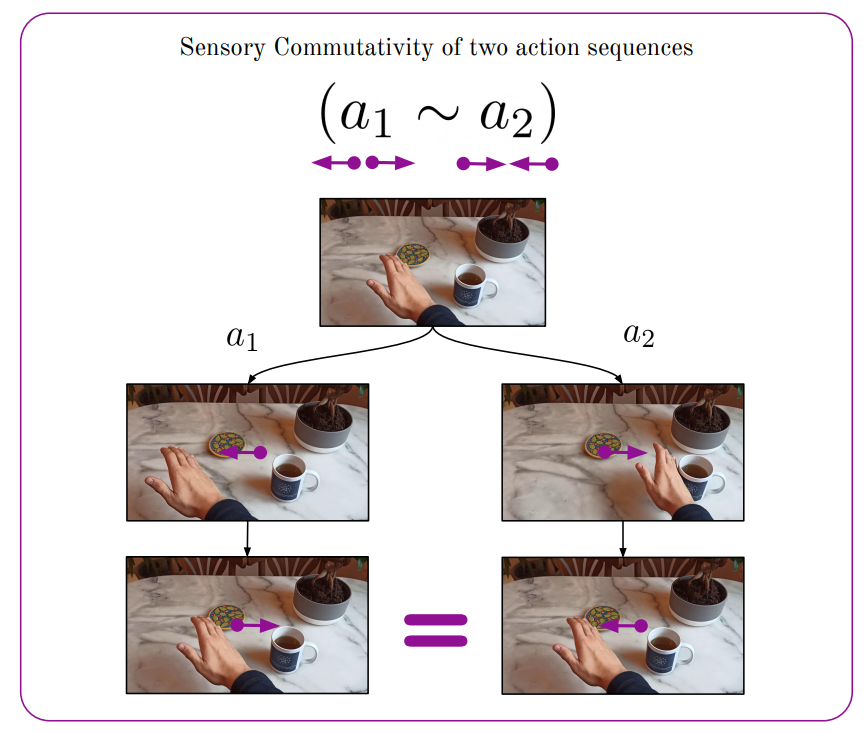

Perception of artificial agents is one the grand challenges of AI research. Deep Learning and data-driven approaches are successful on constrained problems where perception can be learned using supervision, but do not scale to open-worlds. In such case, for autonomous embodied agents with first-person sensors, perception can be learned end-to-end to solve particular tasks. However, literature shows that perception is not a purely passive compression mechanism, and that actions play an important role in the formulation of abstract representations. We propose to study perception for these embodied agents, under the mathematical formalism of group theory in order to make the link between perception and action. In particular, we consider the commutative properties of continuous action sequences with respect to sensory information perceived by such an embodied agent. We introduce the Sensory Commutativity Probability (SCP) criterion which measures how much an agent's degree of freedom affects the environment in embodied scenarios. We show how to compute this criterion in different environments, including realistic robotic setups. We empirically illustrate how SCP and the commutative properties of action sequences can be used to learn about objects in the environment and improve sample-efficiency in Reinforcement Learning.

翻译:对人造物剂的认识是AI研究的重大挑战之一。深层次学习和数据驱动方法在有限的问题上是成功的,通过监督可以了解感知,但不能推广到开放世界。在这种情况下,对于具有第一人传感器的自主内含物剂,可以从端到端学,以解决特定任务。然而,文献表明,感知不是一个纯粹被动的压缩机制,行动在抽象表述中起着重要作用。我们提议根据群体理论的数学形式主义,研究对这些内含物剂的认识,以便使感知与行动联系起来。我们特别考虑到连续行动序列的通融性,以了解这种内含物剂所感知的感官信息。我们引入了感性即感波波性概率标准,以测量一个代理人的自由程度如何在包含的情景中对环境产生多大影响。我们展示了如何在不同的环境中,包括现实的机器人设置中构建这一标准。我们用经验性地展示了SCP和动作序列的通性能是如何用于了解环境中物体的,并提高加强学习的样本效率的。