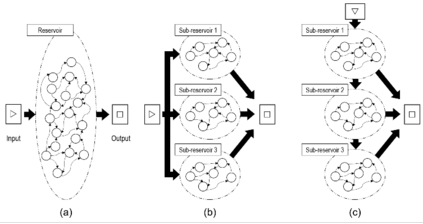

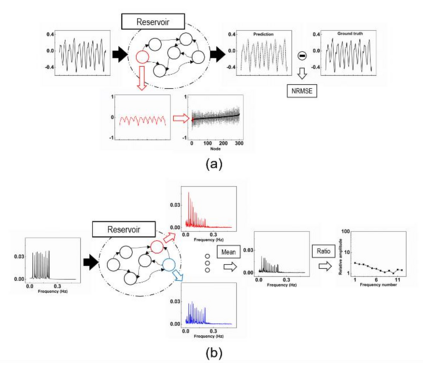

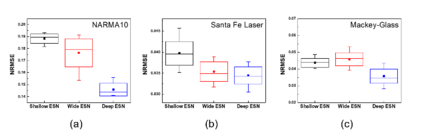

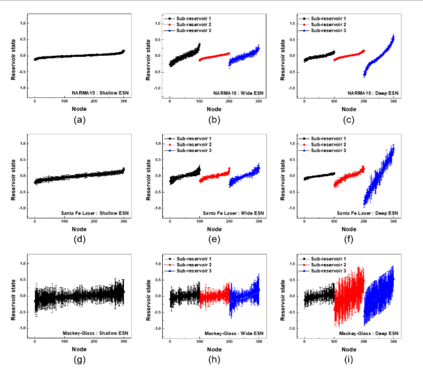

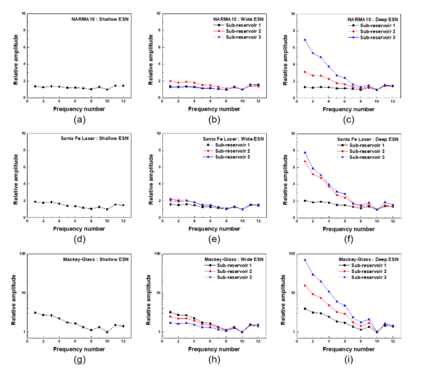

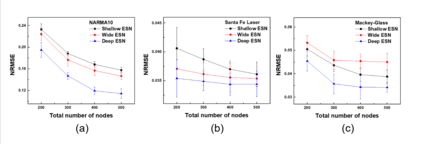

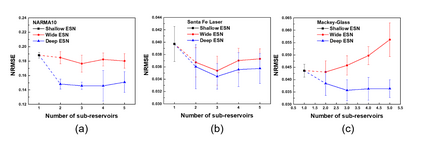

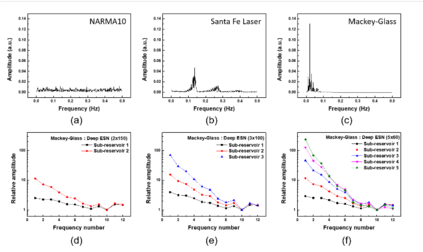

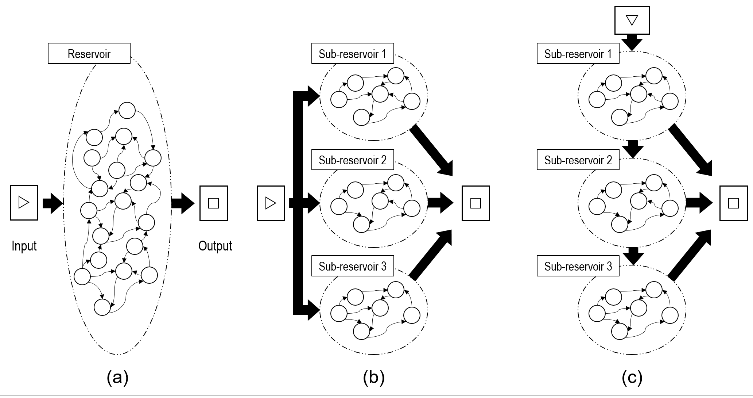

Reservoir computing (RC) offers efficient temporal data processing with a low training cost by separating recurrent neural networks into a fixed network with recurrent connections and a trainable linear network. The quality of the fixed network, called reservoir, is the most important factor that determines the performance of the RC system. In this paper, we investigate the influence of the hierarchical reservoir structure on the properties of the reservoir and the performance of the RC system. Analogous to deep neural networks, stacking sub-reservoirs in series is an efficient way to enhance the nonlinearity of data transformation to high-dimensional space and expand the diversity of temporal information captured by the reservoir. These deep reservoir systems offer better performance when compared to simply increasing the size of the reservoir or the number of sub-reservoirs. Low frequency components are mainly captured by the sub-reservoirs in later stage of the deep reservoir structure, similar to observations that more abstract information can be extracted by layers in the late stage of deep neural networks. When the total size of the reservoir is fixed, tradeoff between the number of sub-reservoirs and the size of each sub-reservoir needs to be carefully considered, due to the degraded ability of individual sub-reservoirs at small sizes. Improved performance of the deep reservoir structure alleviates the difficulty of implementing the RC system on hardware systems.

翻译:储量计算(RC)通过将经常性神经网络分为固定网络,具有经常性连接和可培训的线性网络,提供了高效的时间数据处理,培训成本较低。固定网络的质量,称为储油层,是决定驻地协调员制度绩效的最重要因素。在本文件中,我们调查了等级级储油层结构对储油层特性和驻地协调员制度绩效的影响。对深层神经网络的分析,将子储存层进行系列堆放,是提高数据转换到高空间的无线性、扩大储油层所捕捉的时间信息多样性的有效途径。这些深层储油层系统与仅仅增加储油层规模或次储存数量相比,具有更好的性能。低频组件主要被深层储油层结构后期的次储存库所捕捉到,类似于以下观察,即深层神经网络后期的层可以提取更抽象的信息。当储油层的总量固定时,储油层的次储存量数量与储油层中捕获的时间信息多样化。这些深层系统的数量与每个次储存库规模相比,在仅仅增加储油层结构的深度执行能力时,需要仔细考虑的是每个深层后层系统。