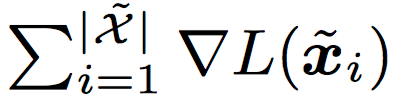

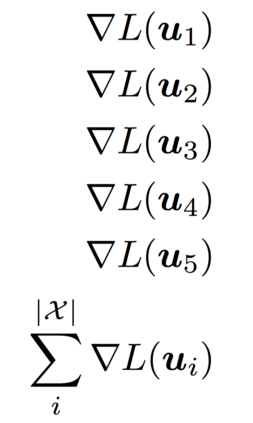

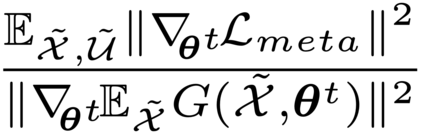

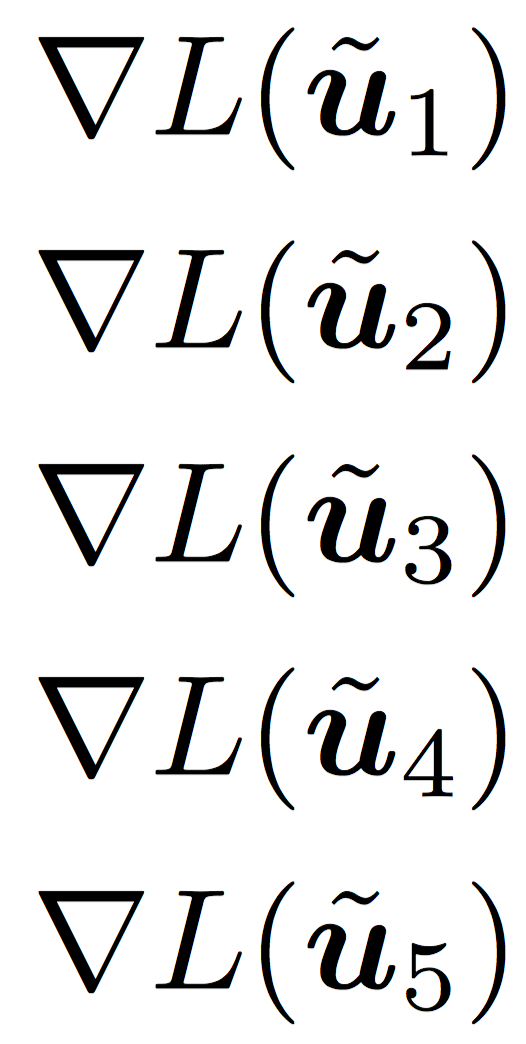

Deep learning based semi-supervised learning (SSL) algorithms have led to promising results in recent years. However, they tend to introduce multiple tunable hyper-parameters, making them less practical in real SSL scenarios where the labeled data is scarce for extensive hyper-parameter search. In this paper, we propose a novel meta-learning based SSL algorithm (Meta-Semi) that requires tuning only one additional hyper-parameter, compared with a standard supervised deep learning algorithm, to achieve competitive performance under various conditions of SSL. We start by defining a meta optimization problem that minimizes the loss on labeled data through dynamically reweighting the loss on unlabeled samples, which are associated with soft pseudo labels during training. As the meta problem is computationally intensive to solve directly, we propose an efficient algorithm to dynamically obtain the approximate solutions. We show theoretically that Meta-Semi converges to the stationary point of the loss function on labeled data under mild conditions. Empirically, Meta-Semi outperforms state-of-the-art SSL algorithms significantly on the challenging semi-supervised CIFAR-100 and STL-10 tasks, and achieves competitive performance on CIFAR-10 and SVHN.

翻译:近些年来,基于半监督的深学习的半监督学习算法(SSL)取得了令人乐观的结果。然而,这些算法往往会引入多种可加金枪鱼的超参数,在实际的SSL假设情景中,标签数据很少用于大规模超参数搜索,因此在这种假设情景中,它们不那么实用。在本文中,我们建议采用一种新的基于元学习的基于SSL算法(Meta-Semi),与标准的受监督的深层次学习算法相比,只需要再调整一个超参数,就可以在SSL的不同条件下取得竞争性的性能。我们首先确定一个元优化问题,通过动态地重新加权未加标签的样本损失,从而最大限度地减少标签数据的损失。由于在培训期间,标签数据与软假标签标签标签标签标签标签标签相关。由于元问题在计算上非常密集,直接解决,我们提议一种高效的算法,以便动态地获得近似的解决办法。我们从理论上看,Met-Sime将标签数据与标签数据在温条件下的损失函数的固定点相交汇点相交汇。我们先行,Met-Semememememime-em exforforforforma exfors 和ST-st-10和ST-10FAR和ST-10和SFAR和S-10C-CFAR的竞争性性能。