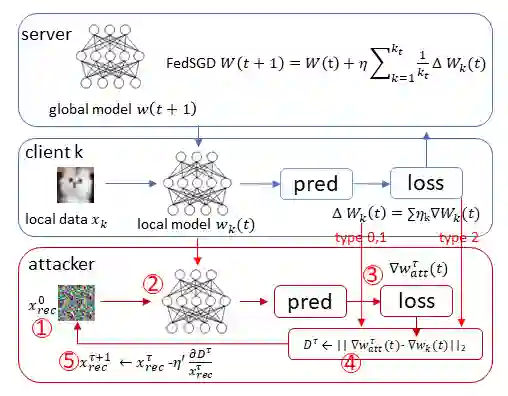

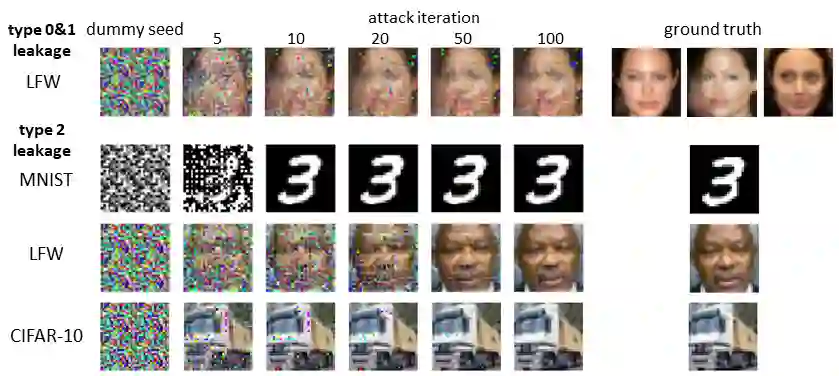

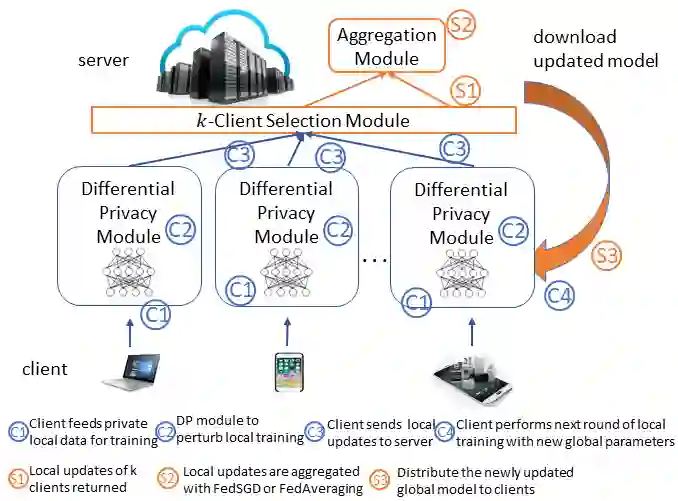

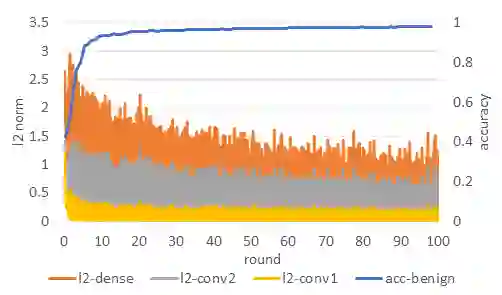

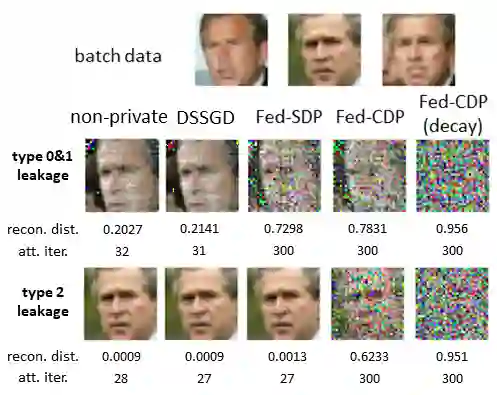

Federated learning(FL) is an emerging distributed learning paradigm with default client privacy because clients can keep sensitive data on their devices and only share local training parameter updates with the federated server. However, recent studies reveal that gradient leakages in FL may compromise the privacy of client training data. This paper presents a gradient leakage resilient approach to privacy-preserving federated learning with per training example-based client differential privacy, coined as Fed-CDP. It makes three original contributions. First, we identify three types of client gradient leakage threats in federated learning even with encrypted client-server communications. We articulate when and why the conventional server coordinated differential privacy approach, coined as Fed-SDP, is insufficient to protect the privacy of the training data. Second, we introduce Fed-CDP, the per example-based client differential privacy algorithm, and provide a formal analysis of Fed-CDP with the $(\epsilon, \delta)$ differential privacy guarantee, and a formal comparison between Fed-CDP and Fed-SDP in terms of privacy accounting. Third, we formally analyze the privacy-utility trade-off for providing differential privacy guarantee by Fed-CDP and present a dynamic decay noise-injection policy to further improve the accuracy and resiliency of Fed-CDP. We evaluate and compare Fed-CDP and Fed-CDP(decay) with Fed-SDP in terms of differential privacy guarantee and gradient leakage resilience over five benchmark datasets. The results show that the Fed-CDP approach outperforms conventional Fed-SDP in terms of resilience to client gradient leakages while offering competitive accuracy performance in federated learning.

翻译:联邦学习联盟(FL)是一个新兴的分布式学习模式,具有默认客户隐私,因为客户可以保留其设备上的敏感数据,并且只能与联邦服务器共享本地培训参数更新;然而,最近的研究表明,FL的梯度渗漏可能损害客户培训数据的隐私。本文以Fed-CDP为首,以Fed-CDP为首,以每份培训以实例为基础的客户差异隐私为首,对隐私保护联合会学习提出了一种梯度渗漏弹性方法。它提供了三种原始贡献。首先,我们查明了三种客户在联邦学习过程中的客户梯度渗漏威胁,即使采用了加密客户-服务器通信。我们说明了传统服务器以Fed-SDP为首,在何时和为什么以美联储-SDP为首,协调差异性保密方法协调不同隐私的保密性做法。第二,我们采用Fed-CDP(Fed-C-DP)的保密性差价位交易方法,在联邦-CFed-DP(Fed-C-DP)为联邦-C(Fed-C)的准确性数据流缩缩缩定义中,在联邦-C-C(Fed-DDD-S)的准确性数据流数据框架中,在向联邦-C-Slation-SLl)的变价化的变变变的变的变的变的变价能中,在美化政策中,对联邦-D-D-D-D-SD-SD-SD-SD-SLBLBLBLLSDSDFDFDFD-SD-SD-SD-SD-SL的变的变的变的变的变的变变的变的变的变的变的变的变的变的保证中,对美的精确性要求的精确性要求的精确性要求的精确性要求中,在向中,进一步的变的精确性要求中,进一步的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变