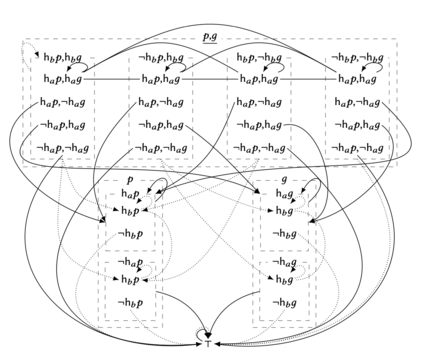

Attention is the crucial cognitive ability that limits and selects what information we observe. Previous work by Bolander et al. (2016) proposes a model of attention based on dynamic epistemic logic (DEL) where agents are either fully attentive or not attentive at all. While introducing the realistic feature that inattentive agents believe nothing happens, the model does not represent the most essential aspect of attention: its selectivity. Here, we propose a generalization that allows for paying attention to subsets of atomic formulas. We introduce the corresponding logic for propositional attention, and show its axiomatization to be sound and complete. We then extend the framework to account for inattentive agents that, instead of assuming nothing happens, may default to a specific truth-value of what they failed to attend to (a sort of prior concerning the unattended atoms). This feature allows for a more cognitively plausible representation of the inattentional blindness phenomenon, where agents end up with false beliefs due to their failure to attend to conspicuous but unexpected events. Both versions of the model define attention-based learning through appropriate DEL event models based on a few and clear edge principles. While the size of such event models grow exponentially both with the number of agents and the number of atoms, we introduce a new logical language for describing event models syntactically and show that using this language our event models can be represented linearly in the number of agents and atoms. Furthermore, representing our event models using this language is achieved by a straightforward formalisation of the aforementioned edge principles.

翻译:注意力是限制和选择我们观察信息的重要认知能力。Bolander等人(2016)的先前研究提出了一种基于动态认知逻辑(DEL)的注意力模型,其中代理人要么完全专注,要么完全不专注。尽管引入了代理人相信无事发生的现实特征,但该模型并未表示注意力最重要的方面:其选择性。在这里,我们提出了一种通用的概念,允许关注原子公式的子集。我们为命题关注引入相应的逻辑,并展示了它的公理化是完备的和与实际情况相符的。然后,我们扩展框架以说明不专注的代理人(而不是假设什么都不会发生)可能会默认为他们未能关注的某个真值(一种关于未关注的原子的事先假设)。这种特征允许更具认知可信度的注意力和盲视现象的代表性,其中代理人由于未能关注显眼但意外事件而得出错误的信念。两个版本的模型通过适当的DEL事件模型定义基于注意力的学习,其基础是一些简单而明确的边缘原则。虽然这些事件模型随着代理人数和原子数的增加呈指数级增长,但我们引入了一种用于在语法上描述事件模型的新逻辑语言,并展示使用这种语言,我们的事件模型可以在代理人数和原子数的线性表示。此外,使用这种语言表示我们的事件模型是通过直接规范上述边缘原则来实现的。